Warunkowe prawdopodobieństwo - Conditional probability

| Część serii o statystykach |

| Teoria prawdopodobieństwa |

|---|

|

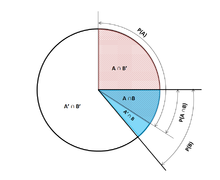

W teorii prawdopodobieństwa , prawdopodobieństwa warunkowego jest miara prawdopodobieństwa wystąpienia zdarzenia występującego, biorąc pod uwagę, że inne zdarzenia (z założenia, założenia twierdzenie lub objawów) ma już miejsce. Jeśli zdarzeniem będącym przedmiotem zainteresowania jest A i wiadomo lub zakłada się, że zaszło zdarzenie B , „prawdopodobieństwo warunkowe A przy danym B ” lub „prawdopodobieństwo wystąpienia A w warunku B ” jest zwykle zapisywane jako P( A | B ) lub czasami P B ( ) . Można to również rozumieć jako ułamek prawdopodobieństwa B, który przecina A: .

Na przykład prawdopodobieństwo, że dana osoba kaszle w danym dniu może wynosić tylko 5%. Ale jeśli wiemy lub zakładamy, że dana osoba jest chora, jest znacznie bardziej prawdopodobne, że będzie kaszleć. Na przykład warunkowe prawdopodobieństwo, że ktoś chory kaszle może wynosić 75%, w takim przypadku mielibyśmy, że P(kaszel) = 5% i P(kaszel|choroba) = 75%. Chociaż nie musi istnieć związek ani zależność między A i B , i nie muszą zachodzić jednocześnie.

P( A | B ) może, ale nie musi być równe P( A ) (bezwarunkowe prawdopodobieństwo A ). Jeśli P( A | B ) = P( A ) , to zdarzenia A i B są uważane za niezależne : w takim przypadku wiedza o żadnym zdarzeniu nie zmienia prawdopodobieństwa siebie nawzajem. P( A | B ) (warunkowe prawdopodobieństwo A przy danym B ) zazwyczaj różni się od P( B | A ) . Na przykład, jeśli dana osoba ma gorączkę denga , może mieć 90% szans na pozytywny wynik testu na tę chorobę. W tym przypadku, co się mierzy, że jeśli zdarzenie B ( o denga ) nastąpiło prawdopodobieństwo A ( uzyskały wynik pozytywny ), zważywszy, że B wystąpiło 90%: P ( | B ) = 90%. Alternatywnie, jeśli dana osoba ma pozytywny wynik testu na gorączkę denga, może mieć tylko 15% szans na tę rzadką chorobę ze względu na wysoki odsetek wyników fałszywie dodatnich . W tym przypadku prawdopodobieństwo zdarzenia B ( zakażającego dengę ) przy założeniu, że zdarzenie A ( test pozytywny ) miało miejsce wynosi 15%: P( B | A ) = 15%. Teraz powinno być oczywiste, że błędnie zrównując oba prawdopodobieństwa może prowadzić do różnych błędów w rozumowaniu, co jest powszechnie widoczne w błędach stopy bazowej .

Chociaż prawdopodobieństwa warunkowe mogą dostarczyć niezwykle przydatnych informacji, często są dostarczane lub pod ręką ograniczone informacje. Dlatego może być przydatne odwrócenie lub przekształcenie prawdopodobieństwa warunku za pomocą twierdzenia Bayesa : . Inną opcją jest wyświetlenie prawdopodobieństw warunkowych w tabeli prawdopodobieństw warunkowych w celu wyjaśnienia związku między zdarzeniami.

Definicja

Uwarunkowanie wydarzenia

Definicja Kołmogorowa

Biorąc pod uwagę dwa zdarzenia A i B z Sigma-pole o powierzchni prawdopodobieństwa, z bezwarunkowym prawdopodobieństwa z B jest większa od zera (czyli P ( B )> 0) , warunkowego prawdopodobieństwa A danej B jest zdefiniowany jako iloraz prawdopodobieństwa stawu zdarzeń a i B , a prawdopodobieństwem w B :

gdzie jest prawdopodobieństwo, że oba zdarzenia A i B występują. Można to wizualizować jako ograniczenie przestrzeni próbki do sytuacji, w których występuje B. Logika stojąca za tym równaniem polega na tym, że jeśli możliwe wyniki dla A i B są ograniczone do tych, w których występuje B , ten zbiór służy jako nowa przestrzeń próbki.

Zauważ, że powyższe równanie jest definicją, a nie wynikiem teoretycznym. Po prostu oznaczamy ilość jako , i nazywamy ją prawdopodobieństwem warunkowym A danego B .

Jako aksjomat prawdopodobieństwa

Niektórzy autorzy, tacy jak de Finetti , wolą wprowadzić prawdopodobieństwo warunkowe jako aksjomat prawdopodobieństwa :

Chociaż matematycznie równoważne, może to być preferowane filozoficznie; w głównych interpretacjach prawdopodobieństwa , takich jak teoria subiektywna , prawdopodobieństwo warunkowe jest uważane za byt pierwotny. Co więcej, ta „reguła mnożenia” może być praktycznie użyteczna przy obliczaniu prawdopodobieństwa i wprowadza symetrię z aksjomatem sumowania dla wzajemnie wykluczających się zdarzeń :

Jako prawdopodobieństwo zdarzenia warunkowego

Prawdopodobieństwo warunkowe można zdefiniować jako prawdopodobieństwo zdarzenia warunkowego . Goodman-Nguyen-van Fraassen zdarzenie warunkowego może być zdefiniowany jako

Można wykazać, że

który spełnia definicję prawdopodobieństwa warunkowego Kołmogorowa.

Uwarunkowanie na zdarzeniu o prawdopodobieństwie zerowym

Jeżeli , to zgodnie z definicją jest niezdefiniowane .

Najbardziej interesującym przypadkiem jest przypadek zmiennej losowej Y , uwarunkowanej ciągłą zmienną losową X dającą określony wynik x . Zdarzenie ma prawdopodobieństwo zerowe i jako takie nie może być warunkowane.

Zamiast warunkować, że X jest dokładnie x , moglibyśmy założyć, że jest ono bliższe niż odległość od x . Zdarzenie będzie na ogół mieć niezerowe prawdopodobieństwo, a zatem może być warunkowane. Możemy wtedy przekroczyć granicę

Na przykład, jeśli dwie ciągłe zmienne losowe X i Y mają wspólną gęstość , to zgodnie z regułą L'Hôpitala :

Otrzymany ograniczeniem jest rozkład warunkowy z Y danego X i występuje, gdy mianownik gęstości prawdopodobieństwa jest ściśle dodatni.

Kuszące jest zdefiniowanie nieokreślonego prawdopodobieństwa przy użyciu tego limitu, ale nie można tego zrobić w sposób konsekwentny. W szczególności można znaleźć zmienne losowe X i W oraz wartości x , w takie, że zdarzenia i są identyczne, ale wynikające z nich granice nie są:

Borel-Kołmogorowa paradoks pokazuje to z geometrycznym argument.

Warunkowanie na dyskretnej zmiennej losowej

Niech X będzie dyskretną zmienną losową, a jej możliwe wyniki oznaczymy V . Na przykład, jeśli X reprezentuje wartość rzuconej kości, to V jest zestawem . Załóżmy dla celów prezentacji, że X jest dyskretną zmienną losową, więc każda wartość w V ma niezerowe prawdopodobieństwo.

Dla wartości x w V i zdarzenia A prawdopodobieństwo warunkowe jest podane przez . Pismo

w skrócie widzimy, że jest to funkcja dwóch zmiennych x i A .

Dla ustalonego A możemy utworzyć zmienną losową . Reprezentuje wynik każdej zaobserwowanej wartości x z X.

Prawdopodobieństwo warunkowe A danego X można zatem traktować jako zmienną losową Y z wynikami w przedziale . Z twierdzenie o prawdopodobieństwie całkowitym , jego wartość oczekiwana jest równa bezwarunkowym prawdopodobieństwem od A .

Częściowe prawdopodobieństwo warunkowe

Częściowe prawdopodobieństwo warunkowe dotyczy prawdopodobieństwa zdarzenia , przy założeniu, że każde ze zdarzeń warunkowych wystąpiło w stopniu (stopień wiary, stopień doświadczenia), który może różnić się od 100%. Często częściowe prawdopodobieństwo warunkowe ma sens, jeśli warunki są testowane w powtórzeniach eksperymentu o odpowiedniej długości . Takie ograniczone częściowe prawdopodobieństwo warunkowe można zdefiniować jako warunkowo oczekiwane średnie wystąpienie zdarzenia na stanowiskach testowych o długości, które są zgodne ze wszystkimi specyfikacjami prawdopodobieństwa , tj.:

Na tej podstawie częściowe prawdopodobieństwo warunkowe można zdefiniować jako

gdzie

Warunkowanie Jeffreya jest szczególnym przypadkiem częściowego prawdopodobieństwa warunkowego, w którym zdarzenia warunkowe muszą tworzyć podział :

Przykład

Załóżmy, że ktoś potajemnie rzuca dwiema sprawiedliwymi sześciościennymi kośćmi , a my chcemy obliczyć prawdopodobieństwo, że wartość pierwszej z nich wynosi 2, biorąc pod uwagę informację, że ich suma nie jest większa niż 5.

Prawdopodobieństwo, że D 1 = 2

Tabela 1 pokazuje przykładową przestrzeń 36 kombinacji wyrzuconych wartości dwóch kości, z których każda występuje z prawdopodobieństwem 1/36, z liczbami wyświetlonymi w czerwonych i ciemnoszarych komórkach jako D 1 + D 2 .

D 1 = 2 dokładnie w 6 z 36 wyników; zatem P ( D 1 = 2) = 6 ⁄ 36 = 1 ⁄ 6 :

Tabela 1 + D 2 1 2 3 4 5 6 D 1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Prawdopodobieństwo, że D 1 + D 2 ≤ 5

Tabela 2 pokazuje, że D 1 + D 2 ≤ 5 dla dokładnie 10 z 36 wyników, stąd P ( D 1 + D 2 ≤ 5) = 10 ⁄ 36 :

Tabela 2 + D 2 1 2 3 4 5 6 D 1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Prawdopodobieństwo, że D 1 = 2 przy założeniu, że D 1 + D 2 ≤ 5

Tabela 3 pokazuje, że dla 3 z tych 10 wyników D 1 = 2.

Zatem prawdopodobieństwo warunkowe P( D 1 = 2 | D 1 + D 2 ≤ 5) = 3 ⁄ 10 = 0,3:

Tabela 3 + D 2 1 2 3 4 5 6 D 1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Tutaj, we wcześniejszym zapisie definicji prawdopodobieństwa warunkowego, zdarzeniem warunkującym B jest to, że D 1 + D 2 ≤ 5, a zdarzeniem A jest D 1 = 2. Mamy to, co widać w tabeli.

Użyj w wnioskowaniu

We wnioskowaniu statystycznym prawdopodobieństwo warunkowe jest aktualizacją prawdopodobieństwa zdarzenia na podstawie nowych informacji. Nowe informacje można wprowadzić w następujący sposób:

- Niech A , zdarzenie będące przedmiotem zainteresowania, będzie w przestrzeni próbki , powiedzmy ( X , P ).

- Wystąpienie zdarzenia A wiedząc, że zdarzenie B miało lub będzie miało miejsce, oznacza wystąpienie zdarzenia A, ponieważ jest ono ograniczone do B , tj . .

- Bez wiedzy o wystąpieniu B informacja o wystąpieniu A byłaby po prostu P ( A )

- Prawdopodobieństwo A wiedząc, że zdarzenie B jest albo będzie miało miejsce, będzie prawdopodobieństwo względem P ( B ), prawdopodobieństwo tego, że B nie wystąpił.

- Powoduje to, gdy P ( B ) > 0 i 0 w przeciwnym razie.

Takie podejście daje w wyniku miarę prawdopodobieństwa, która jest zgodna z pierwotną miarą prawdopodobieństwa i spełnia wszystkie aksjomaty Kołmogorowa . Ta miara prawdopodobieństwa warunkowego mogła również wynikać z założenia, że względna wielkość prawdopodobieństwa A w odniesieniu do X zostanie zachowana w odniesieniu do B (por. Formalne wyprowadzenie poniżej).

Sformułowanie „dowód” lub „informacja” jest powszechnie używane w bayesowskiej interpretacji prawdopodobieństwa . Zdarzenie warunkowania jest interpretowane jako dowód na zdarzenie warunkowane. Oznacza to, że P ( A ) jest prawdopodobieństwem A przed uwzględnieniem dowodu E , a P ( A | E ) jest prawdopodobieństwem A po uwzględnieniu dowodu E lub po aktualizacji P ( A ). Jest to zgodne z interpretacją częstą, która jest pierwszą podaną powyżej definicją.

Statystyczna niezależność

Zdarzenia A i B są zdefiniowane jako statystycznie niezależne, jeśli

Jeśli P ( B ) nie jest zerem, to jest to równoważne stwierdzeniu, że

Podobnie, jeśli P ( A ) nie jest zerem, to

jest również równoważny. Chociaż formy pochodne mogą wydawać się bardziej intuicyjne, nie są one preferowaną definicją, ponieważ prawdopodobieństwa warunkowe mogą być niezdefiniowane, a preferowana definicja jest symetryczna w A i B .

Niezależne wydarzenia a wzajemnie wykluczające się wydarzenia

Pojęcia zdarzeń wzajemnie niezależnych i wykluczających się wzajemnie są odrębne i odrębne. W poniższej tabeli zestawiono wyniki dla dwóch przypadków (pod warunkiem, że prawdopodobieństwo zdarzenia warunkującego nie jest zerowe).

| Jeśli statystycznie niezależny | Jeśli wzajemnie się wykluczają | |

|---|---|---|

| 0 | ||

| 0 | ||

| 0 |

W rzeczywistości wykluczające się zdarzenia nie mogą być statystycznie niezależne (chyba że oba są niemożliwe), gdyż wiedza o tym, że jedno zajdzie, daje informację o drugim (w szczególności, że to drugie na pewno nie wystąpi).

Powszechne błędy

- Tych błędów nie należy mylić z „błędem warunkowym” Roberta K. Shope'a z 1978 roku , który zajmuje się kontrfaktycznymi przykładami, które nasuwają pytanie .

Zakładając, że prawdopodobieństwo warunkowe jest podobnej wielkości do jego odwrotności

Generalnie nie można założyć, że P ( A | B ) ≈ P ( B | A ). Może to być podstępny błąd, nawet dla tych, którzy dobrze znają się na statystykach. Zależność między P ( A | B ) i P ( B | A ) podaje twierdzenie Bayesa :

To znaczy, P( A | B ) ≈ P( B | A ) tylko wtedy, gdy P ( B )/ P ( A ) ≈ 1 lub równoważnie P ( A ) ≈ P ( B ).

Zakładając, że prawdopodobieństwa marginalne i warunkowe są podobnej wielkości

Generalnie nie można założyć, że P ( A ) ≈ P ( A | B ). Prawdopodobieństwa te są połączone przez prawo prawdopodobieństwa całkowitego :

gdzie zdarzenia tworzą przeliczalne partycję z .

Ten błąd może powstać w wyniku błędu selekcji . Na przykład, w kontekście oświadczenia medycznego, niech S C będzie zdarzeniem, w którym następstwo (choroba przewlekła) S występuje jako konsekwencja okoliczności (stan ostry) C . Niech H będzie zdarzeniem, w którym dana osoba szuka pomocy medycznej. Załóżmy, że w większości przypadków C nie powoduje S (a więc P ( S C ) jest niskie). Załóżmy również, że pomoc medyczna jest poszukiwana tylko wtedy, gdy S wystąpiło z powodu C . Z doświadczenia pacjentów lekarz może zatem błędnie wywnioskować, że P ( S C ) jest wysokie. Rzeczywiste prawdopodobieństwo zaobserwowane przez lekarza wynosi P ( S C | H ).

Przeważenie lub niedoważenie priorów

Częściowe lub całkowite nieuwzględnianie prawdopodobieństwa a priori nazywa się zaniedbaniem stopy bazowej . Odwrotna, niewystarczająca korekta z prawdopodobieństwa a priori to konserwatyzm .

Formalne pochodzenie

Formalnie P ( A | B ) definiuje się jako prawdopodobieństwo A zgodnie z nową funkcją prawdopodobieństwa w przestrzeni próbki, taką, że wyniki nie w B mają prawdopodobieństwo 0 i są zgodne ze wszystkimi oryginalnymi miarami prawdopodobieństwa .

Niech Ω będzie próbka przestrzeń ze zdarzeń elementarnych { Ohm } i niech P będzie miarą prawdopodobieństwa w odniesieniu do Ď-algebry z Ohm. Załóżmy, że powiedziano nam, że zaszło zdarzenie B ⊆ Ω. Nowy rozkład prawdopodobieństwa (oznaczony notacją warunkową) należy przypisać do { ω }, aby to odzwierciedlić. Wszystkie zdarzenia, które nie znajdują się w B, będą miały zerowe prawdopodobieństwo w nowym rozkładzie. W przypadku zdarzeń w B muszą być spełnione dwa warunki: prawdopodobieństwo wystąpienia B wynosi jeden i względne wielkości prawdopodobieństw muszą być zachowane. To pierwsze jest wymagane przez aksjomaty prawdopodobieństwa , a drugie wynika z faktu, że nowa miara prawdopodobieństwa musi być analogiem P, w którym prawdopodobieństwo B jest jednością – a zatem każde zdarzenie, które nie jest w B , ma prawdopodobieństwo zerowe. Stąd dla pewnego współczynnika skali α nowy rozkład musi spełniać:

Zastępując 1 i 2 na 3, aby wybrać α :

Zatem nowy rozkład prawdopodobieństwa to

Teraz na ogólne wydarzenie A ,

Zobacz też

- Twierdzenie Bayesa

- epistemologia bayesowska

- Paradoks Borela–Kołmogorowa

- Zasada łańcucha (prawdopodobieństwo)

- Prawdopodobieństwo przynależności do klasy

- Warunkowa niezależność

- Rozkład prawdopodobieństwa warunkowego

- Kondycjonowanie (prawdopodobieństwo)

- Wspólny rozkład prawdopodobieństwa

- Problem z Monty Hall

- Niezależna dystrybucja parami

- Prawdopodobieństwo a posteriori

- Regularne prawdopodobieństwo warunkowe

Bibliografia

Zewnętrzne linki

- Weisstein, Eric W. „Prawdopodobieństwo warunkowe” . MatematykaŚwiat .

- F. Thomas Bruss Der Wyatt-Earp-Effekt oder die betörende Macht kleiner Wahrscheinlichkeiten (w języku niemieckim), Spektrum der Wissenschaft (wydanie niemieckie Scientific American), tom 2, 110–113, (2007).

- Wizualne wyjaśnienie prawdopodobieństwa warunkowego

![[0,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d)

![{\ Displaystyle {\ zacząć {wyrównany} 1 & = \ suma _ {\ omega \ w \ Omega {P (\ omega \ mid B)} \ \ & = \ suma _ {\ omega \ w B} {P (\ omega \mid B)}+{\cancelto {0}{\sum _{\omega \notin B}P(\omega \mid B)}}\\&=\alpha \sum _{\omega \in B} {P(\omega )}\\[5pt]&=\alpha \cdot P(B)\\[5pt]\Rightarrow \alpha &={\frac {1}{P(B)}}\end{wyrównany }}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bc21b49c38af5566aeb4794016be9ee06b40458c)

![{\ Displaystyle {\ zacząć {wyrównany} P (A \ mid B) i = \ suma _ {\ omega \ w A \ czapka B} {P (\ omega \ mid B)} + {\ anulować {0}{\ sum _{\omega \in A\cap B^{c}}P(\omega \mid B)}}\\&=\sum _{\omega \in A\cap B}{\frac {P(\ omega )}{P(B)}}\\[5pt]&={\frac {P(A\cap B)}{P(B)}}\end{wyrównany}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4f6e98f9200e5cf74a15231fc3c753ccfeb8d1c6)