Teoria prawdopodobieństwa - Probability theory

| Część serii o statystykach |

| Teoria prawdopodobieństwa |

|---|

|

Teoria prawdopodobieństwa jest gałęzią matematyki zajmującą się prawdopodobieństwem . Chociaż istnieje kilka różnych interpretacji prawdopodobieństwa, teoria prawdopodobieństwa traktuje to pojęcie w ścisły matematyczny sposób, wyrażając go za pomocą zestawu aksjomatów . Zazwyczaj te aksjomaty formalizują prawdopodobieństwo w postaci przestrzeni prawdopodobieństwa , która przypisuje miarę o wartościach od 0 do 1, nazywaną miarą prawdopodobieństwa , zestawowi wyników zwanego przestrzenią próbek . Każdy określony podzbiór przestrzeni próbki jest nazywany zdarzeniem . Główne tematy teorii prawdopodobieństwa obejmują dyskretne i ciągłe zmienne losowe , rozkłady prawdopodobieństwa i procesy stochastyczne , które dostarczają matematycznych abstrakcji niedeterministycznych lub niepewnych procesów lub mierzonych wielkości, które mogą być pojedynczymi zdarzeniami lub ewoluować w czasie w sposób losowy. Chociaż nie da się idealnie przewidzieć zdarzeń losowych, wiele można powiedzieć o ich zachowaniu. Dwa główne wyniki teorii prawdopodobieństwa opisujące takie zachowanie to prawo wielkich liczb i centralne twierdzenie graniczne .

Jako matematyczna podstawa statystyki , teoria prawdopodobieństwa jest niezbędna w wielu ludzkich działaniach, które obejmują ilościową analizę danych. Metody rachunku prawdopodobieństwa stosują się również do opisów układów złożonych przy jedynie częściowej wiedzy o ich stanie, jak w mechanice statystycznej czy estymacji sekwencyjnej . Wielkim odkryciem fizyki XX wieku była probabilistyczna natura zjawisk fizycznych w skali atomowej, opisana w mechanice kwantowej .

Historia prawdopodobieństwa

Nowoczesny matematyczna teoria prawdopodobieństwa, ma swoje korzenie w próbach do analizy gier losowych przez Girolamo Cardano w XVI wieku, a przez Pierre de Fermat i Blaise Pascal w XVII wieku (na przykład „ Problem punktów ”). Christiaan Huygens opublikował książkę na ten temat w 1657 roku, aw XIX wieku Pierre Laplace ukończył to, co dziś uważa się za klasyczną interpretację.

Początkowo teoria prawdopodobieństwa uwzględniała głównie zdarzenia dyskretne , a jej metody były głównie kombinatoryczne . Ostatecznie względy analityczne wymusiły włączenie do teorii zmiennych ciągłych .

Kulminacją tego była współczesna teoria prawdopodobieństwa, na fundamentach położonych przez Andrieja Nikołajewicza Kołmogorowa . Kołmogorow połączył pojęcie przestrzeni próbek , wprowadzone przez Richarda von Misesa , z teorią miary i przedstawił swój system aksjomatów dla teorii prawdopodobieństwa w 1933 roku. Stało się to w większości niekwestionowaną aksjomatyczną podstawą współczesnej teorii prawdopodobieństwa; ale istnieją alternatywy, takie jak przyjęcie skończonej, a nie policzalnej addytywności przez Bruno de Finetti .

Leczenie

Większość wstępów do teorii prawdopodobieństwa traktuje oddzielnie dyskretne rozkłady prawdopodobieństwa i ciągłe rozkłady prawdopodobieństwa. Oparte na teorii miary traktowanie prawdopodobieństwa obejmuje dyskretne, ciągłe, połączenie tych dwóch i więcej.

Motywacja

Rozważ eksperyment, który może przynieść wiele wyników. Zbiór wszystkich wyników nazywamy przestrzenią próbną eksperymentu. Zestaw potęgowy przestrzeni próbek (lub równoważnie przestrzeni zdarzeń) jest tworzony przez rozważenie wszystkich różnych zbiorów możliwych wyników. Na przykład rzucenie uczciwą kostką daje jeden z sześciu możliwych wyników. Jeden zbiór możliwych wyników odpowiada uzyskaniu liczby nieparzystej. Zatem podzbiór {1,3,5} jest elementem zbioru potęgowego przestrzeni próbnej rolek matrycowych. Te kolekcje nazywane są wydarzeniami . W tym przypadku {1,3,5} jest zdarzeniem, w którym kostka padnie na jakąś nieparzystą liczbę. Jeśli wyniki, które faktycznie występują, przypadają w danym zdarzeniu, mówi się, że to zdarzenie miało miejsce.

Prawdopodobieństwo to sposób na przypisanie każdemu „zdarzeniu” wartości z zakresu od zera do jedynki, z zastrzeżeniem, że na zdarzenie składają się wszystkie możliwe wyniki (w naszym przykładzie zdarzenie {1,2,3,4,5,6}) mieć przypisaną wartość jeden. Aby kwalifikować się jako rozkład prawdopodobieństwa , przypisanie wartości musi spełniać wymaganie, że w przypadku zbioru wzajemnie wykluczających się zdarzeń (zdarzeń, które nie zawierają wspólnych wyników, np. zdarzenia {1,6}, {3} i { 2,4} wzajemnie się wykluczają), prawdopodobieństwo wystąpienia któregokolwiek z tych zdarzeń jest określone przez sumę prawdopodobieństw zdarzeń.

Prawdopodobieństwo wystąpienia dowolnego zdarzenia {1,6}, {3} lub {2,4} wynosi 5/6. To to samo, co powiedzenie, że prawdopodobieństwo zdarzenia {1,2,3,4,6} wynosi 5/6. W tym wydarzeniu istnieje możliwość wyrzucenia dowolnej liczby z wyjątkiem pięciu. Zdarzenie wzajemnie wykluczające się {5} ma prawdopodobieństwo 1/6, a zdarzenie {1,2,3,4,5,6} ma prawdopodobieństwo 1, czyli absolutną pewność.

Wykonując obliczenia z wykorzystaniem wyników eksperymentu, konieczne jest, aby wszystkie te elementarne zdarzenia miały przypisany numer. Odbywa się to za pomocą zmiennej losowej . Zmienna losowa to funkcja, która przypisuje każdemu elementarnemu zdarzeniu w przestrzeni próbki liczbę rzeczywistą . Ta funkcja jest zwykle oznaczana wielką literą. W przypadku wykrojnika przypisanie numeru do określonego zdarzenia elementarnego można wykonać za pomocą funkcji tożsamości . To nie zawsze działa. Na przykład, rzucając monetą, dwa możliwe wyniki to „orzeł” i „reszka”. W tym przykładzie zmienna losowa X mogłaby przypisać wynikowi „głowy” liczbę „0” ( ), a wynikowi „ogonom” liczbę „1” ( ).

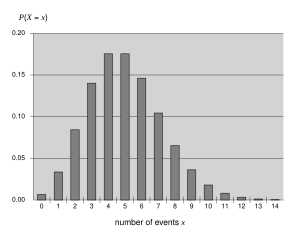

Dyskretne rozkłady prawdopodobieństwa

Dyskretna teoria prawdopodobieństwa zajmuje się zdarzeniami zachodzącymi w policzalnych przestrzeniach próbek.

Przykłady: rzucanie kostkami , eksperymenty z taliami kart , losowy spacer i rzucanie monet

Definicja klasyczna : Początkowo prawdopodobieństwo wystąpienia zdarzenia było definiowane jako liczba przypadków korzystnych dla zdarzenia w stosunku do liczby możliwych wyników w równie prawdopodobnej przestrzeni próbek: patrz Klasyczna definicja prawdopodobieństwa .

Na przykład, jeśli wydarzeniem jest „wystąpienie liczby parzystej podczas rzutu kostką”, prawdopodobieństwo jest podane przez , ponieważ 3 twarze z 6 mają liczby parzyste, a każda twarz ma takie samo prawdopodobieństwo pojawienia się.

Nowoczesna definicja : Nowoczesna definicja zaczyna się od skończonego lub policzalnego zbioru zwanego przestrzenią próbki , który odnosi się do zbioru wszystkich możliwych wyników w klasycznym sensie, oznaczonego przez . Zakłada się wtedy, że do każdego elementu przypisana jest wewnętrzna wartość „prawdopodobieństwo” , która spełnia następujące właściwości:

Oznacza to, że funkcja prawdopodobieństwa f ( x ) leży od zera do jednego dla każdej wartości x w przestrzeni próbek Ω , a suma f ( x ) po wszystkich wartościach x w przestrzeni próbek Ω jest równa 1. Zdarzenie jest zdefiniowany jako dowolny podzbiór przestrzeni próbki . Prawdopodobieństwo zdarzenia określa się jako

Tak więc prawdopodobieństwo całej przestrzeni próbek wynosi 1, a prawdopodobieństwo zdarzenia zerowego wynosi 0.

Funkcja odwzorowująca punkt w przestrzeni próbki na wartość „prawdopodobieństwo” nazywana jest funkcją masy prawdopodobieństwa w skrócie pmf . Współczesna definicja nie próbuje odpowiedzieć na pytanie, w jaki sposób uzyskuje się funkcje masy prawdopodobieństwa; zamiast tego buduje teorię, która zakłada ich istnienie.

Ciągłe rozkłady prawdopodobieństwa

Teoria prawdopodobieństwa ciągłego zajmuje się zdarzeniami zachodzącymi w ciągłej przestrzeni próbek.

Definicja klasyczna : Definicja klasyczna załamuje się w konfrontacji z przypadkiem ciągłym. Zobacz paradoks Bertranda .

Współczesna definicja : Jeśli przestrzeń wynikowa zmiennej losowej X jest zbiorem liczb rzeczywistych ( ) lub ich podzbiorem, to istnieje funkcja zwana funkcją rozkładu skumulowanego (lub cdf ) , zdefiniowana przez . Oznacza to, że F ( x ) zwraca prawdopodobieństwo, że X będzie mniejsze lub równe x .

CDf koniecznie spełnia następujące właściwości.

- jest funkcją monotonicznie nie malejącą , prawo-ciągłą ;

Jeśli jest absolutnie ciągła , tj. jej pochodna istnieje i całkowanie tej pochodnej daje nam ponownie cdf, to mówi się, że zmienna losowa X ma funkcję gęstości prawdopodobieństwa lub pdf lub po prostu gęstość

Za zestaw , prawdopodobieństwo zmiennej losowej X jest w Is

W przypadku, gdy istnieje funkcja gęstości prawdopodobieństwa, można to zapisać jako

Podczas gdy pdf istnieje tylko dla ciągłych zmiennych losowych, cdf istnieje dla wszystkich zmiennych losowych (w tym dyskretnych zmiennych losowych), które przyjmują wartości w

Te koncepcje można uogólnić dla przypadków wielowymiarowych na i innych ciągłych przestrzeniach próbek.

Teoretyczna teoria prawdopodobieństwa miar

Racją istnienia zabiegu pomiarowego, teoretyczna prawdopodobieństwa jest to, że łączy dyskretnego i ciągłego przypadkach, oraz sprawia, że różnica St. od użytego środka. Ponadto obejmuje rozkłady, które nie są ani dyskretne, ani ciągłe, ani nie są mieszaninami tych dwóch.

Przykładem takich rozkładów może być kombinacja rozkładów dyskretnych i ciągłych — na przykład zmienna losowa, która ma wartość 0 z prawdopodobieństwem 1/2 i przyjmuje losową wartość z rozkładu normalnego z prawdopodobieństwem 1/2. Nadal można go do pewnego stopnia zbadać, uznając, że ma pdf z , gdzie jest funkcją delta Diraca .

Inne rozkłady mogą nawet nie być mieszanką, na przykład rozkład Cantora nie ma dodatniego prawdopodobieństwa dla żadnego pojedynczego punktu, ani nie ma gęstości. Nowoczesne podejście do teorii prawdopodobieństwa rozwiązuje te problemy przy użyciu teorii miary do zdefiniowania przestrzeni prawdopodobieństwa :

Mając dowolny zbiór (zwany również przestrzenią prób ) i σ-algebrę na nim, miara zdefiniowana na jest nazywana miarą prawdopodobieństwa, jeśli

Jeśli jest Borelowska σ-algebrą na zbiorze liczb rzeczywistych, to istnieje jednoznaczna miara prawdopodobieństwa dla każdego cdf i vice versa. Mówi się, że miara odpowiadająca cdf jest indukowana przez cdf. Miara ta zbiega się z pmf dla zmiennych dyskretnych i pdf dla zmiennych ciągłych, dzięki czemu podejście oparte na teorii miary jest wolne od błędów.

Prawdopodobieństwo zestawu w Ď-Algebra jest zdefiniowany jako

gdzie integracja jest w odniesieniu do środka wywołanego przez

Oprócz lepszego zrozumienia i ujednolicenia prawdopodobieństw dyskretnych i ciągłych, traktowanie teorii miary pozwala nam również pracować nad prawdopodobieństwami zewnętrznymi , jak w teorii procesów stochastycznych . Na przykład, aby zbadać ruchy Browna , prawdopodobieństwo definiuje się na przestrzeni funkcji.

Gdy wygodnie jest pracować z miarą dominującą, twierdzenie Radona-Nikodyma jest używane do zdefiniowania gęstości jako pochodnej Radona-Nikodyma interesującego rozkładu prawdopodobieństwa względem tej miary dominującej. Dyskretne gęstości są zwykle definiowane jako ta pochodna w odniesieniu do miary liczenia w zestawie wszystkich możliwych wyników. Gęstości dla rozkładów absolutnie ciągłych są zwykle definiowane jako ta pochodna względem miary Lebesgue'a . Jeśli twierdzenie można udowodnić w tym ogólnym ustawieniu, dotyczy ono zarówno rozkładów dyskretnych, jak i ciągłych, a także innych; oddzielne dowody nie są wymagane dla dystrybucji dyskretnych i ciągłych.

Klasyczne rozkłady prawdopodobieństwa

Pewne zmienne losowe występują bardzo często w teorii prawdopodobieństwa, ponieważ dobrze opisują wiele procesów naturalnych lub fizycznych. Dlatego ich rozkłady nabrały szczególnego znaczenia w teorii prawdopodobieństwa. Niektóre podstawowe rozkłady dyskretne to dyskretny jednostajny , Bernoulliego , dwumianowy , ujemny dwumianowy , Poissona i rozkład geometryczny . Ważnymi rozkładami ciągłymi są ciągłe rozkłady równomierne , normalne , wykładnicze , gamma i beta .

Zbieżność zmiennych losowych

W teorii prawdopodobieństwa istnieje kilka pojęć zbieżności dla zmiennych losowych . Są one wymienione poniżej w kolejności siły, tj. każde kolejne pojęcie zbieżności na liście implikuje zbieżność zgodnie ze wszystkimi poprzednimi pojęciami.

- Słaba zbieżność

- Sekwencja zmiennych losowych zbiega słabo zmiennej losowej jeśli ich odpowiednie łączne funkcje rozkładu zbieżne dystrybuanty z , gdzie jest ciągły . Słaba zbieżność nazywana jest również zbieżnością w rozkładzie .

- Najpopularniejsza notacja skrócona:

- Zbieżność prawdopodobieństwa

- Mówi się, że sekwencja zmiennych losowych zbiega się w kierunku zmiennej losowej z prawdopodobieństwem, jeśli dla każdego ε > 0.

- Najpopularniejsza notacja skrócona:

- Silna konwergencja

- Mówi się, że sekwencja zmiennych losowych jest silnie zbieżna w kierunku zmiennej losowej, jeśli . Silna zbieżność jest również znana jako prawie pewna zbieżność .

- Najpopularniejsza notacja skrócona:

Jak wskazują nazwy, słaba zbieżność jest słabsza niż silna zbieżność. W rzeczywistości silna zbieżność implikuje zbieżność prawdopodobieństwa, a zbieżność prawdopodobieństwa implikuje słabą zbieżność. Odwrotne stwierdzenia nie zawsze są prawdziwe.

Prawo wielkich liczb

Powszechna intuicja podpowiada, że jeśli uczciwą monetą rzuca się wiele razy, to mniej więcej w połowie wypadnie ona rewersem , a druga połowa – rewersem . Co więcej, im częściej rzuca się monetą, tym bardziej prawdopodobne jest, że stosunek liczby orłów do liczby reszek zbliża się do jedności. Współczesna teoria prawdopodobieństwa dostarcza formalnej wersji tej intuicyjnej idei, znanej jako prawo wielkich liczb . To prawo jest niezwykłe, ponieważ nie zostało przyjęte w podstawach teorii prawdopodobieństwa, lecz wyłania się z tych podstaw jako twierdzenie. Ponieważ łączy wyprowadzone teoretycznie prawdopodobieństwa z ich faktyczną częstością występowania w świecie rzeczywistym, prawo wielkich liczb jest uważane za filar w historii teorii statystycznej i ma szerokie oddziaływanie.

Prawo wielkich liczb (DGN) stwierdza, że średnia próbka

ciągu niezależnych i identycznie rozłożonych zmiennych losowych zbiega się w kierunku ich wspólnego oczekiwania , pod warunkiem, że oczekiwanie jest skończone.

To w różnych formach zbieżności zmiennych losowych oddziela słabe i silne prawo dużych liczb

- Słabe prawo: dla

- Silne prawo: za

Z LLN wynika, że jeśli zdarzenie o prawdopodobieństwie p jest obserwowane wielokrotnie podczas niezależnych eksperymentów, stosunek obserwowanej częstotliwości tego zdarzenia do całkowitej liczby powtórzeń zbliża się do p .

Na przykład, jeśli niezależne zmienne losowe Bernoulliego przyjmują wartości 1 z prawdopodobieństwem p i 0 z prawdopodobieństwem 1- p , to dla wszystkich i , więc prawie na pewno zbiega się do p .

Centralne twierdzenie graniczne

„Centralne twierdzenie graniczne (CLT) jest jednym z najlepszych wyników matematyki”. (Rozdział 18 w) Wyjaśnia wszechobecne występowanie rozkładu normalnego w przyrodzie.

Twierdzenie to mówi, że średnia wielu niezależnych zmiennych losowych o identycznym rozkładzie ze skończoną wariancją dąży do rozkładu normalnego niezależnie od rozkładu, po którym następują pierwotne zmienne losowe. Formalnie niech będą niezależne zmienne losowe ze średnią i wariancją Następnie ciąg zmiennych losowych

jest zbieżny w rozkładzie do standardowej normalnej zmiennej losowej.

Dla niektórych klas zmiennych losowych klasyczne centralne twierdzenie graniczne działa dość szybko (patrz twierdzenie Berry'ego-Esseena ), na przykład rozkłady ze skończonym pierwszym, drugim i trzecim momentem z rodziny wykładniczej ; z drugiej strony, dla niektórych zmiennych losowych odmiany ogona ciężkiego i ogona grubego , działa bardzo wolno lub może nie działać wcale: w takich przypadkach można użyć Generalized Central Limit Theorem (GCLT).

Zobacz też

- Katalog artykułów z teorii prawdopodobieństwa

- Oczekiwana wartość i wariancja

- Logika rozmyta i teoria miary rozmytej

- Słowniczek prawdopodobieństwa i statystyki

- Funkcja prawdopodobieństwa

- Lista tematów prawdopodobieństwa

- Lista publikacji w statystykach

- Lista tematów statystycznych

- Notacja w prawdopodobieństwie

- Modelowanie predykcyjne

- Logika probabilistyczna – połączenie teorii prawdopodobieństwa i logiki

- Probabilistyczne dowody twierdzeń nieprobabilistycznych

- Rozkład prawdopodobieństwa

- Aksjomaty prawdopodobieństwa

- Interpretacje prawdopodobieństwa

- Przestrzeń prawdopodobieństwa

- Statystyczna niezależność

- Fizyka statystyczna

- Logika subiektywna

- Prawdopodobieństwo zjednoczenia parami niezależnych zdarzeń

Uwagi

Bibliografia

- Pierre Simon de Laplace (1812). Analityczna teoria prawdopodobieństwa .

- Pierwszy poważny traktat łączący rachunek różniczkowy z teorią prawdopodobieństwa, pierwotnie w języku francuskim: Théorie Analytique des Probabilités .

- A. Kołmogorowa (1933). Grundbegriffe der Wahrscheinlichkeitsrechnung . doi : 10.1007/978-3-642-49888-6 . Numer ISBN 978-3-642-49888-6.

- Angielskie tłumaczenie Nathana Morrisona ukazało się pod tytułem Podstawy teorii prawdopodobieństwa (Chelsea, Nowy Jork) w 1950 r., drugie wydanie w 1956 r.

- Patricka Billingsleya (1979). Prawdopodobieństwo i miara . Nowy Jork, Toronto, Londyn: John Wiley and Sons.

- Olav Kallenberg ; Podstawy współczesnego prawdopodobieństwa, wyd. Seria Springera w statystyce. (2002). 650 stron. ISBN 0-387-95313-2

- Henka Tijmsa (2004). Zrozumienie prawdopodobieństwa . Uniwersytet w Cambridge Naciskać.

- Żywe wprowadzenie do teorii prawdopodobieństwa dla początkujących.

- Olafa Kallenberga; Symetrie probabilistyczne i zasady niezmienności . Springer - Verlag, Nowy Jork (2005). 510 s. ISBN 0-387-25115-4

- Gut, Allan (2005). Prawdopodobieństwo: kurs dla absolwentów . Springer-Verlag. Numer ISBN 0-387-22833-0.

![f(x)\in [0,1]{\mbox{ dla wszystkich }}x\in \Omega \,;](https://wikimedia.org/api/rest_v1/media/math/render/svg/d9fb6901c7d0c1686386da77b3a2af38bc0d7952)

![(\delta [x]+\varphi (x))/2](https://wikimedia.org/api/rest_v1/media/math/render/svg/b59e7c343760eb33e805760c20aff9d9c3831260)

![\delta [x]](https://wikimedia.org/api/rest_v1/media/math/render/svg/3953eacd8865ec4c182566de1728419117164d2c)