Przybliżone obliczenia bayesowskie - Approximate Bayesian computation

Przybliżone obliczenia bayesowskie ( ABC ) stanowią klasę metod obliczeniowych zakorzenionych w statystyce bayesowskiej, które można wykorzystać do oszacowania a posteriori rozkładów parametrów modelu.

W sumie w oparciu o model wnioskowania statystycznego The funkcja prawdopodobieństwa ma zasadnicze znaczenie, gdyż wyraża prawdopodobieństwo obserwowanych danych w ramach danego modelu statystycznego , a więc ilościowo poparcie dane pożyczy do konkretnych wartości parametrów oraz wyboru spośród różnych modeli. W przypadku prostych modeli można zazwyczaj wyprowadzić wzór analityczny na funkcję wiarygodności. Jednak w przypadku bardziej złożonych modeli formuła analityczna może być nieuchwytna lub ocena funkcji prawdopodobieństwa może być bardzo kosztowna obliczeniowo.

Metody ABC omijają ocenę funkcji wiarygodności. W ten sposób metody ABC poszerzają sferę modeli, dla których można rozważać wnioskowanie statystyczne. Metody ABC są matematycznie dobrze ugruntowane, ale nieuchronnie dokonują założeń i przybliżeń, których wpływ należy dokładnie ocenić. Ponadto szersza dziedzina zastosowań ABC zwiększa wyzwania związane z estymacją parametrów i doborem modelu .

ABC w ostatnich latach szybko zyskała popularność, aw szczególności do analizy złożonych problemów pojawiających się w naukach biologicznych , np. w genetyce populacyjnej , ekologii , epidemiologii , biologii systemów i propagacji radiowej .

Historia

Pierwsze pomysły związane z ABC sięgają lat 80-tych. Donald Rubin , omawiając interpretację twierdzeń bayesowskich w 1984 r., opisał hipotetyczny mechanizm próbkowania, który daje próbkę z rozkładu a posteriori . Ten schemat był bardziej konceptualnym eksperymentem myślowym, aby pokazać, jakiego rodzaju manipulacje są wykonywane podczas wnioskowania o rozkładach parametrów a posteriori. Opis mechanizmu próbkowania pokrywa się dokładnie z opisem schematu odrzucania ABC i ten artykuł można uznać za pierwszy opisujący przybliżone obliczenia bayesowskie. Jednak pod koniec XIX wieku Francis Galton skonstruował dwustopniowy kwinkunks, który można postrzegać jako fizyczną implementację schematu odrzucania ABC dla pojedynczej nieznanej (parametru) i pojedynczej obserwacji. Kolejny proroczy punkt poczynił Rubin, gdy argumentował, że we wnioskowaniu bayesowskim statystycy stosowani nie powinni zadowalać się tylko modelami analitycznymi, ale zamiast tego rozważać metody obliczeniowe, które pozwalają im oszacować rozkład a posteriori zainteresowania. W ten sposób można rozważyć szerszą gamę modeli. Argumenty te są szczególnie istotne w kontekście ABC.

W 1984 Peter Diggle i Richard Gratton zasugerowali użycie systematycznego schematu symulacji do przybliżenia funkcji prawdopodobieństwa w sytuacjach, gdy jej forma analityczna jest niewykonalna . Ich metoda opierała się na zdefiniowaniu siatki w przestrzeni parametrów i wykorzystaniu jej do przybliżenia prawdopodobieństwa poprzez przeprowadzenie kilku symulacji dla każdego punktu siatki. Przybliżenie zostało następnie ulepszone poprzez zastosowanie technik wygładzania do wyników symulacji. Chociaż pomysł wykorzystania symulacji do testowania hipotez nie był nowy, Diggle i Gratton najwyraźniej wprowadzili pierwszą procedurę wykorzystującą symulację do wnioskowania statystycznego w okolicznościach, w których prawdopodobieństwo jest niewykonalne.

Chociaż podejście Diggle'a i Grattona otworzyło nową granicę, ich metoda nie była jeszcze dokładnie identyczna z tym, co jest obecnie znane jako ABC, ponieważ miała na celu raczej przybliżenie prawdopodobieństwa niż rozkład a posteriori. Artykuł Simona Tavaré i in. jako pierwszy zaproponował algorytm ABC do wnioskowania a posteriori. W ich przełomowej pracy rozważano wnioskowanie na temat genealogii danych dotyczących sekwencji DNA, a w szczególności problem decydowania o rozkładzie a posteriori czasu do ostatniego wspólnego przodka badanych osobników. Takie wnioskowanie jest analitycznie niewykonalne dla wielu modeli demograficznych, ale autorzy przedstawili sposoby symulacji drzew koalescencyjnych w ramach domniemanych modeli. Próbkę z a posteriori parametrów modelu uzyskano akceptując/odrzucając propozycje oparte na porównaniu liczby segregujących miejsc w danych syntetycznych i rzeczywistych. Po tej pracy Jonathan K. Pritchard i in. przy użyciu metody ABC. Wreszcie termin przybliżone obliczenia bayesowskie został ustanowiony przez Marka Beaumonta i in. , rozszerzając dalej metodologię ABC i omawiając przydatność podejścia ABC bardziej szczegółowo do problemów genetyki populacyjnej. Od tego czasu ABC rozprzestrzeniło się na zastosowania poza genetyką populacyjną, takie jak biologia systemowa, epidemiologia i filogeografia .

metoda

Motywacja

Typowym wcieleniem Bayesa twierdzenie wiąże prawdopodobieństwa warunkowego (lub gęstość) konkretnej wartości parametrów podanych danych z prawdopodobieństwem od podane regułą

- ,

gdzie oznacza a posteriori, prawdopodobieństwo, a priori i dowody (określane również jako marginalne prawdopodobieństwo lub wcześniejsze predykcyjne prawdopodobieństwo danych). Zauważ, że mianownik normalizuje całkowite prawdopodobieństwo gęstości a posteriori do jedności i można go obliczyć w ten sposób.

Przeor reprezentuje przekonania lub wiedzę (taką jak np. ograniczenia fizyczne) o tym, zanim była dostępna. Ponieważ poprzednie zawężają niepewność, szacunki a posteriori mają mniejszą wariancję, ale mogą być stronnicze. Dla wygody a priori jest często określana przez wybranie konkretnego rozkładu spośród zbioru dobrze znanych i wykonalnych rodzin rozkładów, tak że zarówno ocena prawdopodobieństw a priori, jak i losowe generowanie wartości są stosunkowo proste. W przypadku niektórych rodzajów modeli bardziej pragmatyczne jest określenie a priori za pomocą faktoryzacji łącznego rozkładu wszystkich elementów w postaci ciągu ich rozkładów warunkowych. Jeśli interesuje nas tylko względne prawdopodobieństwa a posteriori różnych wartości , dowody można zignorować, ponieważ stanowią one stałą normalizującą , która anuluje każdy stosunek prawdopodobieństw a posteriori. Pozostaje jednak konieczne oszacowanie prawdopodobieństwa i a priori . W przypadku wielu aplikacji ocena prawdopodobieństwa jest kosztowna obliczeniowo , a nawet całkowicie niewykonalna, co motywuje użycie ABC do obejścia tego problemu.

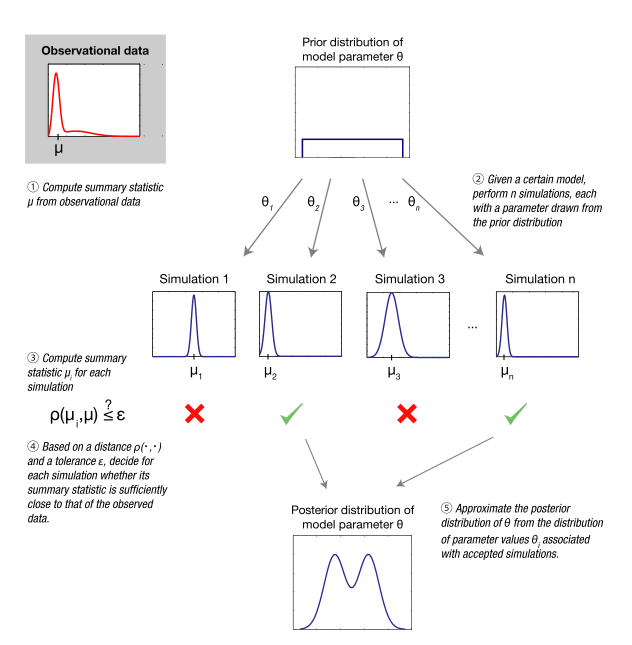

Algorytm odrzucania ABC

Wszystkie metody oparte na ABC aproksymują funkcję wiarygodności za pomocą symulacji, których wyniki są porównywane z obserwowanymi danymi. Dokładniej, za pomocą algorytmu odrzucania ABC — najbardziej podstawowej postaci ABC — zestaw punktów parametrów jest najpierw próbkowany z poprzedniego rozkładu. Biorąc pod uwagę próbkowany punkt parametru , zestaw danych jest następnie symulowany zgodnie z modelem statystycznym określonym przez . Jeśli wygenerowane dane są zbyt różne od zaobserwowanych danych , próbkowana wartość parametru jest odrzucana. Mówiąc ściśle, jest akceptowana z tolerancją, jeżeli:

- ,

gdzie miara odległości określa poziom rozbieżności między i na podstawie danej metryki (np. odległość euklidesowa ). Zwykle konieczna jest ściśle pozytywna tolerancja, ponieważ prawdopodobieństwo, że wynik symulacji dokładnie pokrywa się z danymi (zdarzenie ) jest pomijalne dla wszystkich, z wyjątkiem trywialnych zastosowań ABC, co w praktyce prowadziłoby do odrzucenia prawie wszystkich próbkowanych punktów parametrów. Wynikiem algorytmu odrzucenia ABC jest próbka wartości parametrów w przybliżeniu rozłożonych zgodnie z pożądanym rozkładem a posteriori i, co najważniejsze, uzyskana bez konieczności jawnej oceny funkcji wiarygodności.

Statystyki podsumowujące

Prawdopodobieństwo wygenerowania zestawu danych z niewielkiej odległości zwykle maleje wraz ze wzrostem wymiarów danych. Prowadzi to do znacznego spadku wydajności obliczeniowej powyższego podstawowego algorytmu odrzucania ABC. Typowym podejściem do rozwiązania tego problemu jest zastąpienie zestawu statystyk podsumowujących niższego wymiaru , które są wybierane w celu uchwycenia istotnych informacji w programie . Kryterium akceptacji w algorytmie odrzucania ABC staje się:

- .

Jeżeli statystyki sumaryczne są wystarczające w odniesieniu do parametrów modelu , to uzyskany w ten sposób przyrost wydajności nie wprowadza błędu. Rzeczywiście, z definicji wystarczalność oznacza, że wszystkie informacje w o są przechwytywane przez .

Jak opisano poniżej , poza wykładniczą rodziną rozkładów zazwyczaj niemożliwe jest zidentyfikowanie skończenie wymiarowego zestawu wystarczających statystyk. Niemniej jednak pouczające, ale prawdopodobnie niewystarczające statystyki podsumowujące są często używane w aplikacjach, w których wnioskowanie odbywa się za pomocą metod ABC.

Przykład

Ilustracyjnym przykładem jest system bistabilny , który można scharakteryzować za pomocą ukrytego modelu Markowa (HMM) poddanego pomiarowi szumu. Takie modele są wykorzystywane w wielu systemach biologicznych: były wykorzystywane na przykład w rozwoju, sygnalizacji komórkowej , aktywacji /dezaktywacji, przetwarzaniu logicznym i termodynamice nierównowagowej . Na przykład zachowanie czynnika transkrypcyjnego Sonic hedgehog (Shh) u Drosophila melanogaster można modelować za pomocą HMM. Model dynamiczny (biologiczny) składa się z dwóch stanów: A i B. Jeżeli prawdopodobieństwo przejścia z jednego stanu do drugiego zdefiniujemy jako dwukierunkowe, to prawdopodobieństwo pozostania w tym samym stanie w każdym kroku czasowym wynosi . Prawdopodobieństwo prawidłowego pomiaru stanu wynosi (i odwrotnie, prawdopodobieństwo nieprawidłowego pomiaru wynosi ).

Ze względu na warunkowe zależności między stanami w różnych punktach czasowych obliczanie prawdopodobieństwa danych szeregów czasowych jest nieco żmudne, co ilustruje motywację do korzystania z ABC. Problemem obliczeniowym dla podstawowego ABC jest duża wymiarowość danych w takiej aplikacji. Wymiarowość można zmniejszyć za pomocą statystyki podsumowującej , która jest częstotliwością przełączania między dwoma stanami. Różnica bezwzględna jest używana jako miara odległości z tolerancją . Późniejsze wnioskowanie o parametrze można wykonać, wykonując pięć kroków przedstawionych w.

Krok 1: Załóżmy, że obserwowane dane tworzą sekwencję stanów AAAABAABBAAAAAABAAAA, która jest generowana za pomocą i . Powiązana statystyka podsumowująca — liczba przełączeń między stanami w danych eksperymentalnych — wynosi .

Krok 2: Zakładając, że nic nie wiadomo o , stosuje się jednorodny a priori w przedziale . Zakłada się, że parametr jest znany i ustalony w wartości generującej dane , ale ogólnie można go również oszacować na podstawie obserwacji. Suma punktów parametrów jest pobierana z poprzedniego, a model jest symulowany dla każdego z punktów parametrów , co daje w wyniku sekwencje symulowanych danych. W tym przykładzie , z każdym narysowanym parametrem i symulowanym zestawem danych zarejestrowanym w Tabeli 1, kolumny 2-3 . W praktyce musiałby być znacznie większy, aby uzyskać odpowiednie przybliżenie.

| i | Symulowane zbiory danych (krok 2) | Statystyki podsumowujące (krok 3)

|

Odległość (krok 4)

|

Wynik (krok 4) |

|

|---|---|---|---|---|---|

| 1 | 0,08 | AAAAAAAAAAAAAAAAAAAAA | 8 | 2 | przyjęty |

| 2 | 0,68 | AABBABAAAABBABABBAB | 13 | 7 | odrzucony |

| 3 | 0,87 | BBBABBABBBBABABBBBBA | 9 | 3 | odrzucony |

| 4 | 0,43 | AAAAAAAABBBBBBBBBBBA | 6 | 0 | przyjęty |

| 5 | 0,53 | ABBBBBAABBABBABAABBB | 9 | 3 | odrzucony |

Krok 3: Statystyka podsumowująca jest obliczana dla każdej sekwencji symulowanych danych .

Krok 4: Odległość między obserwowanymi i symulowanymi częstotliwościami przejścia jest obliczana dla wszystkich punktów parametrów. Punkty parametrów, dla których odległość jest mniejsza lub równa, są przyjmowane jako próbki przybliżone od tyłu.

Krok 5: Rozkład a posteriori jest aproksymowany za pomocą przyjętych punktów parametrów. Rozkład a posteriori powinien mieć niepomijalne prawdopodobieństwo dla wartości parametrów w regionie wokół prawdziwej wartości w systemie, jeśli dane są wystarczająco pouczające. W tym przykładzie masa prawdopodobieństwa a posteriori jest równomiernie podzielona między wartości 0,08 i 0,43.

Prawdopodobieństwa a posteriori uzyskuje się za pomocą ABC z dużymi , wykorzystując statystykę podsumowującą (z i ) oraz pełną sekwencję danych (z ). Są one porównywane z prawdziwym a posteriori, które można dokładnie i wydajnie obliczyć za pomocą algorytmu Viterbiego . Statystyka podsumowująca zastosowana w tym przykładzie nie jest wystarczająca, ponieważ odchylenie od teoretycznego a posteriori jest znaczące nawet w przypadku rygorystycznego wymogu . Potrzebna byłaby znacznie dłuższa obserwowana sekwencja danych, aby uzyskać a posteriori skoncentrowaną wokół prawdziwej wartości .

Ta przykładowa aplikacja ABC wykorzystuje uproszczenia w celach ilustracyjnych. Bardziej realistyczne zastosowania ABC są dostępne w coraz większej liczbie recenzowanych artykułów.

Porównanie modeli z ABC

Poza estymacją parametrów ramę ABC można wykorzystać do obliczenia prawdopodobieństw a posteriori różnych modeli kandydujących. W takich aplikacjach jedną z możliwości jest wykorzystanie próbkowania odrzuceń w sposób hierarchiczny. Najpierw model jest próbkowany z wcześniejszego rozkładu modeli. Następnie parametry są próbkowane z wcześniejszego rozkładu przypisanego do tego modelu. Na koniec przeprowadzana jest symulacja jak w jednomodelowym ABC. Względne częstości akceptacji dla różnych modeli przybliżają teraz rozkład a posteriori dla tych modeli. Ponownie zaproponowano ulepszenia obliczeniowe ABC w przestrzeni modeli, takie jak skonstruowanie filtra cząstek w wspólnej przestrzeni modeli i parametrów.

Po oszacowaniu prawdopodobieństw a posteriori modeli można w pełni wykorzystać techniki Bayesowskiego porównania modeli . Na przykład, aby porównać względne wiarygodności dwóch modeli i , można obliczyć ich stosunek a posteriori, który jest powiązany ze współczynnikiem Bayesa :

- .

Jeśli a priori modelu są równe — to znaczy — współczynnik Bayesa jest równy stosunkowi a posteriori.

W praktyce, jak omówiono poniżej , miary te mogą być bardzo wrażliwe na wybór uprzednich rozkładów parametrów i statystyk podsumowujących, dlatego wnioski z porównania modeli należy wyciągać z ostrożnością.

Pułapki i środki zaradcze

| Źródło błędu | Potencjalny problem | Rozwiązanie | Podrozdział |

|---|---|---|---|

| Niezerowa tolerancja | Niedokładność wprowadza błąd do obliczonego rozkładu tylnego. | Teoretyczne/praktyczne badania wrażliwości rozkładu a posteriori na tolerancję. Głośne ABC. | #Aproksymacja odcinka tylnego |

| Niewystarczające statystyki podsumowujące | Utrata informacji powoduje zawyżone wiarygodne przedziały. | Automatyczny wybór/półautomatyczna identyfikacja wystarczających statystyk. Kontrole walidacji modelu (np. Templeton 2009). | #Wybór i wystarczalność statystyk podsumowujących |

| Mała liczba modeli/błędnie określone modele | Badane modele nie są reprezentatywne/nie mają mocy predykcyjnej. | Staranny dobór modeli. Ocena mocy predykcyjnej. | #Mała liczba modeli |

| Priory i zakresy parametrów | Wnioski mogą być wrażliwe na wybór przeorów. Wybór modelu może być bez znaczenia. | Sprawdź wrażliwość czynników Bayesa na wybór a priori. Dostępne są niektóre teoretyczne wyniki dotyczące wyboru a priori. Użyj alternatywnych metod walidacji modelu. | #Poprzedni rozkład i zakresy parametrów |

| Przekleństwo wymiarowości | Niskie wskaźniki akceptacji parametrów. Błędów modelu nie można odróżnić od niedostatecznej eksploracji przestrzeni parametrów. Ryzyko nadmiernego dopasowania. | Metody redukcji modelu, jeśli dotyczy. Metody przyspieszające eksplorację parametrów. Kontrole jakości w celu wykrycia nadmiernego dopasowania. | #Przekleństwo wymiarowości |

| Ranking modeli ze statystykami podsumowującymi | Obliczenie współczynników Bayesa w statystykach podsumowujących może nie być powiązane ze współczynnikami Bayesa w danych pierwotnych, co może spowodować, że wyniki będą bez znaczenia. | Należy używać wyłącznie statystyk podsumowujących, które spełniają niezbędne i wystarczające warunki, aby uzyskać spójny wybór modelu bayesowskiego. Użyj alternatywnych metod walidacji modelu. | #Współczynnik Bayesa z ABC i statystykami podsumowującymi |

| Realizacja | Niska ochrona wspólnych założeń w symulacji i procesie wnioskowania. | Kontrole poczytalności wyników. Standaryzacja oprogramowania. | #Niezbędne kontrole jakości |

Jak w przypadku wszystkich metod statystycznych, do zastosowania metod opartych na ABC do rzeczywistych problemów modelowania koniecznych jest szereg założeń i przybliżeń. Na przykład ustawienie parametru tolerancji na zero zapewnia dokładny wynik, ale zwykle powoduje, że obliczenia są zbyt kosztowne. Tak więc w praktyce stosuje się wartości większe od zera, co wprowadza błąd. Podobnie, wystarczające statystyki są zazwyczaj niedostępne, a zamiast tego używane są inne statystyki podsumowujące, które wprowadzają dodatkową stronniczość z powodu utraty informacji. Dodatkowe źródła tendencyjności – na przykład w kontekście wyboru modelu – mogą być bardziej subtelne.

Jednocześnie część krytyki, która została skierowana pod adresem metod ABC, w szczególności w dziedzinie filogeografii , nie jest specyficzna dla ABC i dotyczy wszystkich metod bayesowskich, a nawet wszystkich metod statystycznych (np. wybór uprzedniego rozkładu i zakresy parametrów). Jednak ze względu na zdolność metod ABC do obsługi znacznie bardziej złożonych modeli, niektóre z tych ogólnych pułapek mają szczególne znaczenie w kontekście analiz ABC.

W tej sekcji omówiono te potencjalne zagrożenia i omówiono możliwe sposoby ich rozwiązania.

Aproksymacja tylna

Nie bez znaczenia jest cena, z której pobiera się próbki zamiast prawdziwej tylnej części . Przy wystarczająco małej tolerancji i rozsądnej mierze odległości wynikowy rozkład powinien często dość dobrze przybliżać rzeczywisty rozkład docelowy . Z drugiej strony tolerancja, która jest wystarczająco duża, aby każdy punkt w przestrzeni parametrów został zaakceptowany, da replikę wcześniejszego rozkładu. Istnieją badania empiryczne różnicy między i jako funkcji , oraz teoretyczne wyniki dla górnej zależnej granicy błędu w oszacowaniach parametrów. Zbadano również dokładność a posteriori (definiowanej jako oczekiwana utrata kwadratowa) dostarczonej przez ABC jako funkcja . Jednak zbieżność rozkładów, gdy zbliża się do zera, oraz to, jak zależy to od zastosowanej miary odległości, jest ważnym tematem, który nie został jeszcze bardziej szczegółowo zbadany. W szczególności trudno jest oddzielić błędy wprowadzone przez to przybliżenie od błędów spowodowanych błędną specyfikacją modelu.

Jako próbę skorygowania niektórych błędów wynikających z wartości niezerowej sugerowano użycie lokalnej liniowej regresji ważonej z ABC w celu zmniejszenia wariancji oszacowań a posteriori. Metoda przypisuje wagi parametrom zgodnie z tym, jak dobrze symulowane podsumowania przylegają do obserwowanych i wykonuje regresję liniową między podsumowaniami a parametrami ważonymi w pobliżu obserwowanych podsumowań. Otrzymane współczynniki regresji służą do korekcji parametrów próbkowanych w kierunku obserwowanych zestawień. Zasugerowano poprawę w postaci nieliniowej regresji przy użyciu modelu sieci neuronowej ze sprzężeniem do przodu. Wykazano jednak, że rozkłady a posteriori uzyskane za pomocą tych podejść nie zawsze są zgodne z rozkładem wcześniejszym, co doprowadziło do przeformułowania korekty regresji, która uwzględnia rozkład wcześniejszy.

Wreszcie, wnioskowanie statystyczne przy użyciu ABC z niezerową tolerancją nie jest z natury wadliwe: przy założeniu błędów pomiarowych można w rzeczywistości wykazać , że optymalne nie jest zerem. Rzeczywiście, błąd systematyczny spowodowany niezerową tolerancją można scharakteryzować i skompensować przez wprowadzenie określonej formy szumu do statystyk podsumowujących. Ustalono asymptotyczną spójność dla takiego „zaszumionego ABC” wraz ze wzorami na asymptotyczną wariancję oszacowań parametrów dla ustalonej tolerancji.

Wybór i wystarczalność statystyk podsumowujących

Statystyki podsumowujące mogą być używane do zwiększenia współczynnika akceptacji ABC dla danych wielowymiarowych. Do tego celu optymalne są wystarczające statystyki niskowymiarowe, ponieważ wychwytują wszystkie istotne informacje obecne w danych w najprostszej możliwej formie. Jednak wystarczające statystyki niskowymiarowe są zazwyczaj nieosiągalne dla modeli statystycznych, w których wnioskowanie oparte na ABC jest najbardziej istotne, a w konsekwencji pewna heurystyka jest zwykle niezbędna do zidentyfikowania przydatnych statystyk podsumowujących niskowymiarowych. Użycie zestawu źle dobranych statystyk podsumowujących często prowadzi do zawyżonych wiarygodnych przedziałów z powodu domniemanej utraty informacji, co może również wpływać na dyskryminację między modelami. Dostępny jest przegląd metod wyboru statystyk podsumowujących, który może dostarczyć cennych wskazówek w praktyce.

Jednym ze sposobów przechwytywania większości informacji zawartych w danych byłoby użycie wielu statystyk, ale dokładność i stabilność ABC wydaje się szybko spadać wraz ze wzrostem liczby statystyk podsumowujących. Zamiast tego lepszą strategią jest skupienie się tylko na odpowiednich statystykach — trafności zależnej od całego problemu wnioskowania, zastosowanego modelu i dostępnych danych.

Zaproponowano algorytm identyfikacji reprezentatywnego podzbioru statystyk podsumowujących poprzez iteracyjne ocenianie, czy dodatkowa statystyka wprowadza znaczącą modyfikację a posteriori. Jednym z wyzwań jest to, że duży błąd aproksymacji ABC może mieć duży wpływ na wnioski dotyczące użyteczności statystyki na dowolnym etapie procedury. Inna metoda dzieli się na dwa główne etapy. Najpierw konstruuje się przybliżenie odniesienia a posteriori, minimalizując entropię . Zestawy podsumowań kandydatów są następnie oceniane przez porównanie aproksymowanych ABC z tyłu z wzorcem.

W przypadku obu tych strategii podzbiór statystyk jest wybierany z dużego zestawu statystyk kandydujących. Zamiast tego podejście regresji cząstkowych najmniejszych kwadratów wykorzystuje informacje ze wszystkich statystyk kandydujących, z których każda jest odpowiednio ważona. Ostatnio dużym zainteresowaniem cieszy się metoda konstruowania podsumowań w sposób półautomatyczny. Metoda ta opiera się na obserwacji, że optymalny dobór statystyk sumarycznych, przy minimalizacji kwadratowej utraty oszacowań punktowych parametrów, można uzyskać za pomocą średniej tylnej parametrów, którą aproksymuje się wykonując regresję liniową na podstawie symulowanych danych .

Dużą wartość miałyby metody identyfikacji statystyk podsumowujących, które mogłyby jednocześnie ocenić wpływ na aproksymację a posteriori. Dzieje się tak, ponieważ wybór statystyk podsumowujących i wybór tolerancji stanowią dwa źródła błędów w otrzymanym rozkładzie a posteriori. Błędy te mogą uszkodzić ranking modeli i mogą również prowadzić do nieprawidłowych prognoz modeli. Rzeczywiście, żadna z powyższych metod nie ocenia wyboru podsumowań na potrzeby wyboru modelu.

Współczynnik Bayesa z ABC i statystykami podsumowującymi

Wykazano, że połączenie niewystarczających statystyk podsumowujących i ABC do wyboru modelu może być problematyczne. Rzeczywiście, jeśli pozwolimy, aby czynnik Bayesa oparty na statystyce sumarycznej był oznaczony przez , relacja między i przyjmuje postać:

- .

Zatem statystyka podsumowująca jest wystarczająca do porównania dwóch modeli i wtedy i tylko wtedy, gdy:

- ,

co powoduje, że . Z powyższego równania jasno wynika również, że może istnieć ogromna różnica między i jeśli warunek nie jest spełniony, co można zademonstrować na przykładach zabawek. Co najważniejsze, wykazano, że wystarczalność dla lub osobno, lub dla obu modeli, nie gwarantuje wystarczalności do rankingu modeli. Wykazano jednak również, że każda wystarczająca statystyka podsumowująca dla modelu, w którym oba i są zagnieżdżone, jest ważna dla rankingu modeli zagnieżdżonych .

Obliczenie współczynników Bayesa na może być zatem mylące dla celów wyboru modelu, chyba że stosunek między czynnikami Bayesa na i byłby dostępny lub przynajmniej można by go dość dobrze przybliżyć. Alternatywnie, konieczne i wystarczające warunki dotyczące statystyk podsumowujących dla spójnego wyboru modelu bayesowskiego zostały ostatnio wyprowadzone, co może dostarczyć użytecznych wskazówek.

Jednak ten problem dotyczy tylko wyboru modelu, gdy rozmiar danych został zmniejszony. Wnioskowanie oparte na ABC, w którym rzeczywiste zbiory danych są bezpośrednio porównywane — tak jak w przypadku niektórych aplikacji biologii systemów (np. patrz ) — pozwala ominąć ten problem.

Niezbędne kontrole jakości

Jak wynika z powyższej dyskusji, każda analiza ABC wymaga wyborów i kompromisów, które mogą mieć znaczący wpływ na jej wyniki. W szczególności wybór konkurencyjnych modeli/hipotez, liczba symulacji, wybór statystyk podsumowujących lub próg akceptacji nie może obecnie opierać się na ogólnych zasadach, ale efekt tych wyborów powinien być oceniany i testowany w każdym badaniu.

Zaproponowano szereg heurystycznych podejść do kontroli jakości ABC, takich jak kwantyfikacja ułamka wariancji parametrów wyjaśniona przez statystyki podsumowujące. Wspólna klasa metod ma na celu ocenę, czy wnioskowanie daje prawidłowe wyniki, niezależnie od faktycznie zaobserwowanych danych. Na przykład, mając zestaw wartości parametrów, które są zazwyczaj pobierane z rozkładu a priori lub a posteriori modelu, można wygenerować dużą liczbę sztucznych zbiorów danych. W ten sposób jakość i wiarygodność wnioskowania ABC można ocenić w kontrolowanym środowisku, mierząc, jak dobrze wybrana metoda wnioskowania ABC odtwarza prawdziwe wartości parametrów, a także modele, jeśli jednocześnie rozważanych jest wiele różnych strukturalnie modeli.

Inna klasa metod ocenia, czy wnioskowanie zakończyło się powodzeniem w świetle danych zaobserwowanych danych, na przykład porównując rozkład predykcyjny a posteriori statystyk podsumowujących z zaobserwowanymi statystykami podsumowującymi. Poza tym techniki walidacji krzyżowej i testy predykcyjne stanowią obiecujące przyszłe strategie oceny stabilności i trafności predykcyjnej poza próbą wniosków dotyczących ABC. Jest to szczególnie ważne podczas modelowania dużych zbiorów danych, ponieważ wtedy wsparcie a posteriori konkretnego modelu może wydawać się przytłaczająco rozstrzygające, nawet jeśli wszystkie proponowane modele w rzeczywistości są słabymi reprezentacjami systemu stochastycznego będącego podstawą danych obserwacyjnych. Kontrole predykcyjne poza próbą mogą ujawnić potencjalne systematyczne błędy w modelu i dostarczyć wskazówek, jak poprawić jego strukturę lub parametryzację.

Ostatnio zaproponowano całkowicie nowatorskie podejścia do wyboru modelu, które obejmują kontrolę jakości jako integralny etap procesu. ABC pozwala, poprzez konstrukcję, oszacować rozbieżności między obserwowanymi danymi a przewidywaniami modelu, w odniesieniu do pełnego zestawu statystyk. Te statystyki niekoniecznie są takie same, jak te stosowane w kryterium akceptacji. Uzyskane rozkłady rozbieżności zostały wykorzystane do wyboru modeli, które są zgodne z wieloma aspektami danych jednocześnie, a niespójność modelu jest wykrywana na podstawie sprzecznych i współzależnych podsumowań. Inna metoda wyboru modelu oparta na kontroli jakości wykorzystuje ABC do przybliżenia efektywnej liczby parametrów modelu oraz odchylenia a posteriori rozkładów predykcyjnych podsumowań i parametrów. Kryterium informacji o odchyleniu jest następnie wykorzystywane jako miara dopasowania modelu. Wykazano również, że preferowane modele oparte na tym kryterium mogą kolidować z modelami wspieranymi przez czynniki Bayesa . Z tego powodu warto łączyć różne metody doboru modelu w celu uzyskania poprawnych wniosków.

Kontrole jakości są osiągalne i rzeczywiście przeprowadzane w wielu pracach opartych na ABC, ale w przypadku pewnych problemów ocena wpływu parametrów związanych z metodą może być trudna. Można jednak oczekiwać, że szybko rosnące wykorzystanie ABC zapewni dokładniejsze zrozumienie ograniczeń i stosowalności metody.

Ogólne ryzyko we wnioskowaniu statystycznym nasilone w ABC

W tej sekcji dokonano przeglądu zagrożeń, które ściśle rzecz biorąc nie są specyficzne dla ABC, ale są również istotne dla innych metod statystycznych. Jednak elastyczność oferowana przez ABC w zakresie analizowania bardzo złożonych modeli sprawia, że są one bardzo istotne do omówienia tutaj.

Rozkład a priori i zakresy parametrów

Specyfikacja zakresu i uprzedniego rozkładu parametrów silnie korzysta z wcześniejszej wiedzy o właściwościach systemu. Jednym z zarzutów było to, że w niektórych badaniach „zakresy i rozkłady parametrów są jedynie zgadywane na podstawie subiektywnej opinii badaczy”, co jest powiązane z klasycznymi zastrzeżeniami podejść bayesowskich.

W przypadku każdej metody obliczeniowej zazwyczaj konieczne jest ograniczenie zakresów badanych parametrów. Przedziały parametrów powinny, jeśli to możliwe, być określone w oparciu o znane właściwości badanego systemu, ale w przypadku praktycznych zastosowań może to wymagać wykształconych domysłów. Dostępne są jednak teoretyczne wyniki dotyczące obiektywnych a priorów , które mogą być oparte na przykład na zasadzie obojętności lub na zasadzie maksymalnej entropii . Z drugiej strony, zautomatyzowane lub półautomatyczne metody wyboru wcześniejszej dystrybucji często dają niewłaściwe gęstości . Ponieważ większość procedur ABC wymaga generowania próbek z wcześniejszych, niewłaściwe a priori nie mają bezpośredniego zastosowania do ABC.

Należy również pamiętać o celu analizy przy wyborze wcześniejszego rozkładu. W zasadzie nieinformacyjne i płaskie a priori, które wyolbrzymiają naszą subiektywną ignorancję na temat parametrów, mogą nadal dawać rozsądne oszacowania parametrów. Jednak czynniki Bayesa są bardzo wrażliwe na wcześniejszy rozkład parametrów. Wnioski dotyczące wyboru modelu w oparciu o czynnik Bayesa mogą być mylące, chyba że dokładnie rozważy się wrażliwość wniosków na wybór a priori.

Mała liczba modeli

Metody oparte na modelach zostały skrytykowane za niewyczerpujące pokrycie przestrzeni hipotez. Rzeczywiście, badania oparte na modelach często obracają się wokół małej liczby modeli, a ze względu na wysoki koszt obliczeniowy oceny pojedynczego modelu w niektórych przypadkach może być wówczas trudno objąć dużą część przestrzeni hipotez.

Górna granica liczby rozważanych modeli kandydujących jest zwykle ustalana przez znaczny wysiłek wymagany do zdefiniowania modeli i wyboru między wieloma alternatywnymi opcjami. Nie ma powszechnie akceptowanej procedury budowy modelu specyficznej dla ABC, dlatego zamiast tego wykorzystywane jest doświadczenie i wcześniejsza wiedza. Chociaż bardziej solidne procedury wyboru i formułowania modeli a priori byłyby korzystne, nie ma jednej uniwersalnej strategii opracowywania modeli w statystyce: rozsądna charakterystyka złożonych systemów zawsze będzie wymagała dużej ilości pracy detektywistycznej i wykorzystania ekspertów wiedza z dziedziny problemowej.

Niektórzy przeciwnicy ABC twierdzą, że ponieważ tylko kilka modeli — subiektywnie wybranych i prawdopodobnie całkowicie błędnych — można realistycznie rozważyć, analizy ABC dostarczają jedynie ograniczonego wglądu. Istnieje jednak ważne rozróżnienie między identyfikacją wiarygodnej hipotezy zerowej a oceną względnego dopasowania hipotez alternatywnych. Ponieważ użyteczne hipotezy zerowe, które potencjalnie są prawdziwe, mogą być niezwykle rzadko formułowane w kontekście złożonych modeli, zdolność predykcyjna modeli statystycznych jako wyjaśnień złożonych zjawisk jest o wiele ważniejsza niż testowanie statystycznej hipotezy zerowej w tym kontekście. Powszechne jest również uśrednianie badanych modeli, ważone na podstawie ich względnej wiarygodności, wnioskowanie cech modelu (np. wartości parametrów) i dokonywanie prognoz.

Duże zbiory danych

Duże zbiory danych mogą stanowić wąskie gardło obliczeniowe dla metod opartych na modelach. Zwrócono na przykład uwagę, że w niektórych analizach opartych na ABC część danych musi zostać pominięta. Wielu autorów twierdziło, że duże zbiory danych nie są praktycznym ograniczeniem, chociaż powaga tego problemu zależy silnie od cech modeli. Kilka aspektów problemu modelowania może przyczynić się do złożoności obliczeniowej, takie jak wielkość próbki, liczba obserwowanych zmiennych lub cech, rozdzielczość czasowa lub przestrzenna itp. Jednak wraz ze wzrostem mocy obliczeniowej problem ten potencjalnie będzie mniej istotny.

Zamiast próbkowania parametrów dla każdej symulacji z poprzedniej, zaproponowano alternatywnie połączenie algorytmu Metropolis-Hastings z ABC, co dawało wyższy wskaźnik akceptacji niż dla zwykłego ABC. Oczywiście takie podejście dziedziczy ogólne obciążenia metod MCMC, takie jak trudność w ocenie zbieżności, korelacja między próbkami z tyłu i stosunkowo słaba paralelizowalność.

Podobnie idee sekwencyjnych metod Monte Carlo (SMC) i populacyjnych metod Monte Carlo (PMC) zostały dostosowane do ustawienia ABC. Ogólna idea polega na iteracyjnym podejściu do a posteriori od a priori poprzez sekwencję rozkładów docelowych. Zaletą takich metod w porównaniu z ABC-MCMC jest to, że próbki z powstałego a posteriori są niezależne. Ponadto w przypadku metod sekwencyjnych poziomy tolerancji nie mogą być określane przed analizą, ale są dostosowywane adaptacyjnie.

Stosunkowo proste jest zrównoleglenie kilku kroków w algorytmach ABC opartych na próbkowaniu odrzucania i sekwencyjnych metodach Monte Carlo . Wykazano również, że algorytmy równoległe mogą znacznie przyspieszyć wnioskowanie oparte na MCMC w filogenetyce, co może być wykonalnym podejściem również dla metod opartych na ABC. Jednak adekwatny model dla złożonego systemu najprawdopodobniej będzie wymagał intensywnych obliczeń niezależnie od wybranej metody wnioskowania i od użytkownika zależy wybór metody, która jest odpowiednia dla danego zastosowania.

Przekleństwo wymiarowości

Wielowymiarowe zestawy danych i wielowymiarowe przestrzenie parametrów mogą wymagać symulacji bardzo dużej liczby punktów parametrów w badaniach opartych na ABC, aby uzyskać rozsądny poziom dokładności dla wniosków a posteriori. W takich sytuacjach koszt obliczeniowy jest znacznie zwiększony iw najgorszym przypadku może sprawić, że analiza obliczeniowa będzie niewykonalna. Są to przykłady dobrze znanych zjawisk, które zwykle określa się mianem klątwy wymiarowości .

Aby ocenić, jak bardzo wymiarowość zbioru danych wpływa na analizę w kontekście ABC, wyprowadzono wzory analityczne dla błędu estymatorów ABC jako funkcji wymiaru statystyki podsumowującej. Ponadto Blum i François zbadali, w jaki sposób wymiar statystyk podsumowujących jest powiązany z błędem średniokwadratowym dla różnych korekt korygujących błąd estymatorów ABC. Argumentowano również, że techniki redukcji wymiarów są przydatne do uniknięcia przekleństwa wymiarowości, ze względu na potencjalnie niskowymiarową podstawową strukturę statystyk podsumowujących. Zmotywowani minimalizacją kwadratowej utraty estymatorów ABC, Fearnhead i Prangle zaproponowali schemat rzutowania (prawdopodobnie wielowymiarowych) danych na oszacowania parametrów tylnych średnich; środki te, mające teraz ten sam wymiar co parametry, są następnie używane jako statystyki podsumowujące dla ABC.

ABC można wykorzystać do wnioskowania problemów w przestrzeniach parametrów o dużej wielkości, chociaż należy wziąć pod uwagę możliwość overfittingu (np. zobacz metody wyboru modelu w i ). Jednak prawdopodobieństwo zaakceptowania symulowanych wartości parametrów w danej tolerancji za pomocą algorytmu odrzucania ABC zwykle maleje wykładniczo wraz ze wzrostem wymiarowości przestrzeni parametrów (ze względu na globalne kryterium akceptacji). Chociaż wydaje się, że żadna metoda obliczeniowa (oparta na ABC lub nie) nie jest w stanie przełamać klątwy wymiarowości, ostatnio opracowano metody obsługujące wysokowymiarowe przestrzenie parametrów przy pewnych założeniach (np. oparte na aproksymacji wielomianowej na nielicznych siatkach, co może potencjalnie znacznie skrócić czas symulacji dla ABC). Jednak stosowalność takich metod jest uzależniona od problemu, a trudność eksploracji przestrzeni parametrów w zasadzie nie powinna być lekceważona. Na przykład wprowadzenie deterministycznej estymacji parametrów globalnych doprowadziło do doniesień, że globalne optima uzyskane w kilku wcześniejszych badaniach problemów niskowymiarowych były nieprawidłowe. W przypadku niektórych problemów może być zatem trudno stwierdzić, czy model jest nieprawidłowy lub, jak omówiono powyżej , czy badany obszar przestrzeni parametrów jest niewłaściwy. Bardziej pragmatyczne podejścia polegają na zmniejszeniu zakresu problemu poprzez redukcję modelu, dyskretyzację zmiennych i wykorzystanie modeli kanonicznych, takich jak modele zaszumione. Modele zaszumione wykorzystują informacje o warunkowej niezależności między zmiennymi.

Oprogramowanie

Obecnie dostępnych jest wiele pakietów oprogramowania do zastosowania ABC do poszczególnych klas modeli statystycznych.

| Oprogramowanie | Słowa kluczowe i funkcje | Referencja |

|---|---|---|

| pyABC | Framework Pythona do wydajnego rozproszonego ABC-SMC (Sequential Monte Carlo). | |

| PyMC | Pakiet Pythona do Bayesowskiego modelowania statystycznego i probabilistycznego uczenia maszynowego. | |

| DIY-ABC | Oprogramowanie do dopasowania danych genetycznych do złożonych sytuacji. Porównanie modeli konkurencyjnych. Estymacja parametrów. Obliczanie miar obciążenia i precyzji dla danego modelu i znanych wartości parametrów. | |

|

Pakiet abc R |

Kilka algorytmów ABC do wykonywania estymacji parametrów i wyboru modelu. Nieliniowe metody regresji heteroskedastycznej dla ABC. Narzędzie do weryfikacji krzyżowej. | |

|

Pakiet EasyABC R |

Kilka algorytmów do wykonywania wydajnych schematów próbkowania ABC, w tym 4 sekwencyjne schematy próbkowania i 3 schematy MCMC. | |

| ABC-SysBio | Pakiet Pythona. Wnioskowanie parametrów i dobór modelu dla układów dynamicznych. Łączy próbnik odrzucenia ABC, ABC SMC do wnioskowania parametrów i ABC SMC do wyboru modelu. Kompatybilny z modelami napisanymi w Systems Biology Markup Language (SBML). Modele deterministyczne i stochastyczne. | |

| ABCprzybornik | Programy typu open source dla różnych algorytmów ABC, w tym próbkowanie odrzucania, MCMC bez prawdopodobieństwa, próbnik oparty na cząstkach i ABC-GLM. Zgodność z większością programów do obliczania symulacji i statystyk podsumowujących. | |

| msBayes | Pakiet oprogramowania open source składający się z kilku programów C i R, które są uruchamiane z "front-endem" Perla. Hierarchiczne modele koalescencyjne. Dane genetyczne populacji z wielu współdystrybuowanych gatunków. | |

| Pop ABC | Pakiet oprogramowania do wnioskowania o wzorze dywergencji demograficznej. Symulacja koalescencyjna. Wybór modelu bayesowskiego. | |

| ONESAMP | Internetowy program do oszacowania efektywnej wielkości populacji na podstawie próbki genotypów mikrosatelitarnych. Szacunki efektywnej wielkości populacji wraz z 95% wiarygodnymi granicami. | |

| ABC4F | Oprogramowanie do estymacji statystyki F dla danych dominujących. | |

| 2ZŁE | Mieszanka Bayesowska 2-zdaniowa. Oprogramowanie umożliwiające do dwóch niezależnych domieszek z maksymalnie trzema populacjami rodzicielskimi. Estymacja kilku parametrów (domieszki, efektywne rozmiary itp.). Porównanie par modeli domieszek. | |

| ELFI | Silnik do wnioskowania bez prawdopodobieństwa. ELFI to pakiet oprogramowania statystycznego napisany w Pythonie dla przybliżonych obliczeń bayesowskich (ABC), znanych również jako wnioskowanie bez wiarygodności, wnioskowanie oparte na symulatorze, aproksymacyjne wnioskowanie bayesowskie itp. | |

| ABCpy | Pakiet Pythona dla ABC i innych schematów wnioskowania bez prawdopodobieństwa. Dostępnych jest kilka najnowocześniejszych algorytmów. Zapewnia szybki sposób integracji istniejących generatywnych (z C++, R itp.), przyjazną dla użytkownika równoległość przy użyciu MPI lub Spark oraz uczenie statystyk podsumowujących (z siecią neuronową lub regresją liniową). |

Przydatność poszczególnych pakietów oprogramowania zależy od konkretnej aplikacji, środowiska systemu komputerowego i wymaganych algorytmów.

Zobacz też

Bibliografia

![]() Ten artykuł został zaadaptowany z następującego źródła na licencji CC BY 4.0 ( 2013 ) ( raporty recenzentów ):

Mikael Sunnåker; Alberto Giovanni Busetto; Elina Numminen; Jukka Corander; Matthieu Foll; Christophe Dessimoz (2013). „Przybliżone obliczenia Bayesa” . PLOS Biologia Obliczeniowa . 9 (1): e1002803. doi : 10.1371/JOURNAL.PCBI.1002803 . ISSN 1553-734X . PMC 3547661 . PMID 23341757 . Wikidane Q4781761 .

Ten artykuł został zaadaptowany z następującego źródła na licencji CC BY 4.0 ( 2013 ) ( raporty recenzentów ):

Mikael Sunnåker; Alberto Giovanni Busetto; Elina Numminen; Jukka Corander; Matthieu Foll; Christophe Dessimoz (2013). „Przybliżone obliczenia Bayesa” . PLOS Biologia Obliczeniowa . 9 (1): e1002803. doi : 10.1371/JOURNAL.PCBI.1002803 . ISSN 1553-734X . PMC 3547661 . PMID 23341757 . Wikidane Q4781761 .

Zewnętrzne linki

- Darren Wilkinson (31 marca 2013). „Wprowadzenie do przybliżonych obliczeń bayesowskich” . Pobrano 2013-03-31 .

- Rasmus Bååth (20 października 2014). „Małe dane, przybliżone obliczenia bayesowskie i skarpetki Karla Bromana” . Źródło 2015-01-22 .

![[0,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d)