Zestawy szkoleniowe, walidacyjne i testowe - Training, validation, and test sets

W uczeniu maszynowym powszechnym zadaniem jest badanie i konstruowanie algorytmów, które mogą uczyć się na podstawie danych i przewidywać na ich podstawie . Takie algorytmy działają poprzez dokonywanie prognoz lub decyzji opartych na danych, poprzez budowanie modelu matematycznego z danych wejściowych. Te dane wejściowe wykorzystywane do budowy modelu są zwykle podzielone na wiele zestawów danych . W szczególności na różnych etapach tworzenia modelu powszechnie wykorzystywane są trzy zbiory danych: uczące, walidacyjne i testowe.

Model jest początkowo dopasowywany do uczącego zbioru danych , który jest zbiorem przykładów służących do dopasowania parametrów (np. wag połączeń między neuronami w sztucznych sieciach neuronowych ) modelu. Model (np. naiwny klasyfikator Bayesa ) jest szkolony na zbiorze danych uczących przy użyciu metody nadzorowanego uczenia się , na przykład przy użyciu metod optymalizacji, takich jak zejście gradientowe lub zejście stochastyczne gradientowe . W praktyce zestaw danych uczących często składa się z par wektora wejściowego (lub skalarnego) i odpowiadającego mu wektora wyjściowego (lub skalarnego), gdzie klucz odpowiedzi jest powszechnie oznaczany jako docelowy (lub etykieta ). Bieżący model jest uruchamiany z zestawem danych szkoleniowych i generuje wynik, który jest następnie porównywany z target , dla każdego wektora wejściowego w zestawie danych szkoleniowych. Na podstawie wyniku porównania i zastosowanego konkretnego algorytmu uczenia parametry modelu są dostosowywane. Dopasowanie modelu może obejmować zarówno dobór zmiennych, jak i estymację parametrów .

Kolejno dopasowany model jest używany do przewidywania odpowiedzi na obserwacje w drugim zbiorze danych zwanym zbiorem danych walidacyjnych . Zestaw danych walidacyjnych zapewnia bezstronną ocenę dopasowania modelu do zestawu danych uczących podczas dostrajania hiperparametrów modelu (np. liczby jednostek ukrytych — warstw i szerokości warstw — w sieci neuronowej). Zbiory danych do walidacji można wykorzystać do regularyzacji poprzez wczesne zatrzymanie (przerywanie uczenia, gdy błąd w zestawie danych do walidacji wzrasta, ponieważ jest to oznaką nadmiernego dopasowania do zestawu danych uczących). Ta prosta procedura jest skomplikowana w praktyce przez fakt, że błąd zestawu danych walidacyjnych może się zmieniać podczas uczenia, tworząc wiele lokalnych minimów. Ta komplikacja doprowadziła do stworzenia wielu doraźnych zasad decydowania, kiedy naprawdę zaczęło się nadmierne dopasowanie.

Wreszcie zestaw danych testowych to zestaw danych służący do zapewnienia obiektywnej oceny ostatecznego dopasowania modelu do zestawu danych treningowych. Jeśli dane z zestawu danych testowych nigdy nie były używane podczas uczenia (na przykład w walidacji krzyżowej ), zestaw danych testowych jest również nazywany zestawem danych wstrzymanych . W niektórych publikacjach termin „zbiór walidacyjny” jest czasami używany zamiast „zestaw testowy” (np. jeśli pierwotny zestaw danych został podzielony na tylko dwa podzbiory, zestaw testowy można nazwać zbiorem walidacyjnym).

Decydowanie o rozmiarach i strategiach podziału zbioru danych na zbiory uczące, testowe i walidacyjne jest bardzo zależne od problemu i dostępnych danych.

Zestaw danych treningowych

Zbiór danych uczących to zestaw danych przykładów używanych podczas procesu uczenia się i jest używany do dopasowania parametrów (np. wag) np . klasyfikatora .

W przypadku zadań klasyfikacyjnych nadzorowany algorytm uczenia analizuje zestaw danych uczących, aby określić lub poznać optymalne kombinacje zmiennych, które wygenerują dobry model predykcyjny . Celem jest stworzenie wytrenowanego (dopasowanego) modelu, który dobrze uogólnia nowe, nieznane dane. Dopasowany model jest oceniany przy użyciu „nowych” przykładów z przetrzymywanych zestawów danych (zestawy danych walidacyjnych i testowych) w celu oszacowania dokładności modelu w klasyfikowaniu nowych danych. Aby zmniejszyć ryzyko problemów, takich jak nadmierne dopasowanie, przykłady w walidacyjnych i testowych zestawach danych nie powinny być wykorzystywane do uczenia modelu.

Większość podejść, które przeszukują dane szkoleniowe pod kątem relacji empirycznych, ma tendencję do nadmiernego uzupełniania danych, co oznacza, że mogą identyfikować i wykorzystywać pozorne relacje w danych szkoleniowych, które nie są ogólnie dostępne.

Zestaw danych walidacyjnych

Zbiór danych walidacyjnych to zbiór danych przykładów używanych do dostrajania hiperparametrów (tj. architektury) klasyfikatora. Czasami jest również nazywany zestawem deweloperskim lub „zestawem deweloperskim”. Przykład hiperparametru dla sztucznych sieci neuronowych zawiera liczbę jednostek ukrytych w każdej warstwie. To, podobnie jak zbiór testowy (jak wspomniano powyżej), powinno mieć taki sam rozkład prawdopodobieństwa, jak zbiór danych uczących.

Aby uniknąć nadmiernego dopasowania, gdy jakikolwiek parametr klasyfikacji wymaga dostosowania, konieczne jest posiadanie zestawu danych walidacyjnych oprócz zestawów danych uczących i testowych. Na przykład, jeśli poszukiwany jest najbardziej odpowiedni klasyfikator dla problemu, zestaw danych uczących jest używany do uczenia różnych klasyfikatorów kandydujących, zestaw danych walidacyjnych jest używany do porównania ich wyników i podjęcia decyzji, który z nich wybrać, a na koniec dane testowe zestaw służy do uzyskania charakterystyk wydajności, takich jak dokładność , czułość , swoistość , miara F i tak dalej. Zbiór danych walidacyjnych funkcjonuje jako hybryda: są to dane szkoleniowe wykorzystywane do testowania, ale nie jako część szkolenia niskiego poziomu ani jako część końcowego testowania.

Podstawowym procesem wykorzystania zbioru danych walidacyjnych do wyboru modelu (w ramach zbioru danych uczących, zbioru danych walidacyjnych i zbioru danych testowych) jest:

Ponieważ naszym celem jest znalezienie sieci o najlepszej wydajności na nowych danych, najprostszym podejściem do porównania różnych sieci jest ocena funkcji błędu przy użyciu danych, które są niezależne od danych użytych do uczenia. Różne sieci są uczone przez minimalizację odpowiedniej funkcji błędu zdefiniowanej w odniesieniu do zestawu danych uczących. Wydajność sieci jest następnie porównywana przez ocenę funkcji błędu przy użyciu niezależnego zestawu walidacji i wybierana jest sieć mająca najmniejszy błąd w odniesieniu do zestawu walidacji. Takie podejście nazywa się metodą wstrzymania . Ponieważ ta procedura sama w sobie może prowadzić do nadmiernego dopasowania do zestawu walidacyjnego, działanie wybranej sieci należy potwierdzić, mierząc jej działanie na trzecim niezależnym zestawie danych zwanym zestawem testowym.

Zastosowanie tego procesu polega na wczesnym zatrzymaniu , gdzie kandydujące modele są kolejnymi iteracjami tej samej sieci, a uczenie zatrzymuje się, gdy błąd w zbiorze walidacyjnym rośnie, wybierając poprzedni model (ten z minimalnym błędem).

Testowy zestaw danych

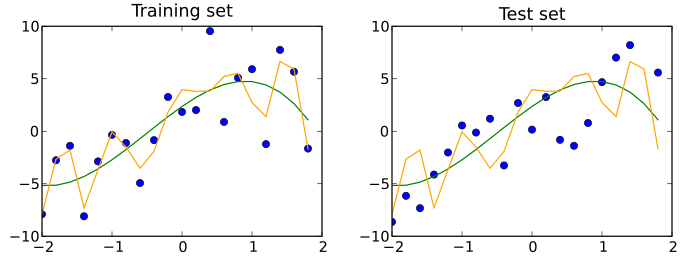

Testowy zestaw danych to zestaw danych, który jest niezależny od zestawu danych uczących, ale ma taki sam rozkład prawdopodobieństwa jak zestaw danych uczących. Jeśli dopasowanie modelu do zestawu danych uczących również dobrze pasuje do zestawu danych testowych, wystąpiło minimalne nadmierne dopasowanie (patrz rysunek poniżej). Lepsze dopasowanie zestawu danych treningowych w przeciwieństwie do zestawu danych testowych zwykle wskazuje na nadmierne dopasowanie.

Zbiór testowy jest zatem zbiorem przykładów używanych wyłącznie do oceny działania (tj. uogólnienia) w pełni określonego klasyfikatora. W tym celu ostateczny model służy do przewidywania klasyfikacji przykładów w zestawie testowym. Te przewidywania są porównywane z prawdziwymi klasyfikacjami przykładów, aby ocenić dokładność modelu.

W scenariuszu, w którym używane są zarówno zestawy danych walidacyjnych, jak i testowych, zestaw danych testowych jest zwykle używany do oceny ostatecznego modelu wybranego podczas procesu walidacji. W przypadku, gdy oryginalny zestaw danych jest podzielony na dwa podzbiory (zestawy danych uczących i testowych), zestaw danych testowych może ocenić model tylko raz (np. w metodzie wstrzymania ). Zauważ, że niektóre źródła odradzają taką metodę. Jednak w przypadku korzystania z metody, takiej jak walidacja krzyżowa , dwa podziały mogą być wystarczające i skuteczne, ponieważ wyniki są uśredniane po wielokrotnych rundach uczenia i testowania modelu w celu zmniejszenia błędu systematycznego i zmienności.

Zamieszanie w terminologii

Testowanie to próba czegoś, aby się o tym dowiedzieć („Postawić na dowód; udowodnić prawdziwość, autentyczność lub jakość przez eksperyment” według Collaborative International Dictionary of English) i zweryfikować to udowodnić, że coś jest ważne ( „Aby potwierdzić; potwierdzić” Międzynarodowy słownik języka angielskiego oparty na współpracy). Z tej perspektywy najczęstszym zastosowaniem terminów zestaw testowy i zestaw walidacyjny jest to, które zostało opisane tutaj. Jednak zarówno w przemyśle, jak i na uczelniach, są one czasami używane zamiennie, biorąc pod uwagę, że proces wewnętrzny polega na testowaniu różnych modeli w celu ulepszenia (zestaw testowy jako zestaw rozwojowy), a ostateczny model to taki, który należy zweryfikować przed rzeczywistym użyciem z niewidoczne dane (zestaw walidacyjny). „Literatura na temat uczenia maszynowego często odwraca znaczenie zestawów »walidacji« i »testów«. Jest to najbardziej rażący przykład zamieszania terminologicznego, które przenika badania nad sztuczną inteligencją. Niemniej jednak ważną koncepcją, którą należy zachować, jest to, że ostateczny zestaw , nazywany testem lub walidacją, powinien być używany tylko w końcowym eksperymencie.

Weryfikacja krzyżowa

Aby uzyskać bardziej stabilne wyniki i wykorzystać wszystkie cenne dane do treningu, zestaw danych można wielokrotnie podzielić na kilka zestawów danych uczących i walidacyjnych. Nazywa się to sprawdzaniem krzyżowym . W celu walidacji wydajności modelu zwykle stosuje się dodatkowy zestaw danych testowych pochodzących z walidacji krzyżowej.

Zobacz też

- Klasyfikacja statystyczna

- Lista zbiorów danych do badań nad uczeniem maszynowym

- Klasyfikacja hierarchiczna