Precyzja i przypomnienie - Precision and recall

W rozpoznawania wzorców , wyszukiwania informacji i klasyfikacji (uczenia maszynowego) , precyzja i przywołanie są wskaźniki wydajności, które odnoszą się do danych pobranych z kolekcji , corpus lub próbki przestrzeni .

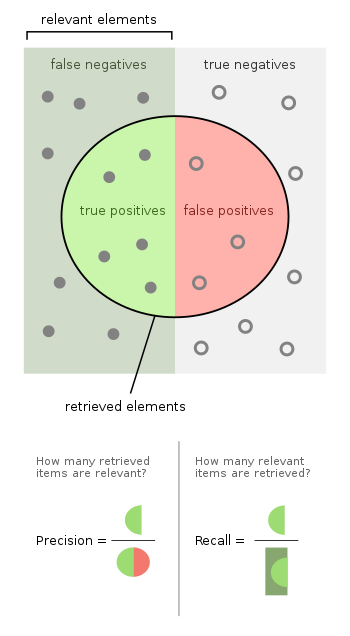

Dokładność (nazywana również dodatnią wartością predykcyjną ) to ułamek odpowiednich wystąpień wśród pobranych wystąpień, natomiast przypomnienie (znane również jako czułość ) to ułamek odpowiednich wystąpień, które zostały pobrane. Zarówno precyzja, jak i przypomnienie są zatem oparte na trafności .

Rozważmy program komputerowy do rozpoznawania psów ( odpowiedni element) na fotografii cyfrowej. Po przetworzeniu obrazu, który zawiera dziesięć kotów i dwanaście psów, program identyfikuje osiem psów. Spośród ośmiu elementów zidentyfikowanych jako psy tylko pięć to psy (prawdziwie pozytywne), podczas gdy pozostałe trzy to koty (fałszywie pozytywne). Siedem psów zostało pominiętych (negatywy fałszywie), a siedem kotów zostało prawidłowo wykluczonych (negatywy prawdziwe). Dokładność programu wynosi wtedy 5/8 (prawdziwe pozytywy / wybrane elementy), a jego odwołanie 5/12 (prawdziwe pozytywy / istotne elementy).

Gdy wyszukiwarka zwraca 30 stron, z których tylko 20 jest odpowiednich, a nie zwraca 40 dodatkowych odpowiednich stron, jej precyzja wynosi 20/30 = 2/3, co mówi nam, jak ważne są wyniki, podczas gdy jej odwołanie wynosi 20/ 60 = 1/3, co mówi nam, jak kompletne są wyniki.

Przyjęcie ze statystyk podejścia testującego hipotezę , w którym w tym przypadku hipotezą zerową jest, że dana pozycja jest nieistotna , tj. nie pies, brak błędów typu I i II (tj. doskonała swoistość i czułość 100% każdy) odpowiada odpowiednio doskonałej precyzji (brak wyników fałszywie pozytywnych) i doskonałej pamięci (brak wyników fałszywie negatywnych).

Bardziej ogólnie, wycofanie jest po prostu uzupełnieniem poziomu błędu typu II, tj. jeden minus poziom błędu typu II. Precyzja jest powiązana ze wskaźnikiem błędów typu I, ale w nieco bardziej skomplikowany sposób, ponieważ zależy również od wcześniejszego rozmieszczenia pozycji istotnej i nieistotnej.

Powyższy przykład z kotem i psem zawierał 8-5 = 3 błędy typu I, dla poziomu błędu I typu 3/10 i 12-5 = 7 błędów typu II, dla poziomu błędu II typu 7/12. Precyzja może być postrzegana jako miara jakości, a przypominanie jako miara ilości. Większa precyzja oznacza, że algorytm zwraca więcej trafnych wyników niż nieistotnych, a wysoka powtarzalność oznacza, że algorytm zwraca większość trafnych wyników (niezależnie od tego, czy zwracane są również te nieistotne).

Wstęp

W wyszukiwaniu informacji instancje są dokumentami, a zadaniem jest zwrócenie zestawu odpowiednich dokumentów na podstawie wyszukiwanego hasła. Przypomnij to liczba istotnych dokumentów wyszukanych podzielona przez całkowitą liczbę istniejących odpowiednich dokumentów , a precyzja to liczba odpowiednich dokumentów wyszukanych w wyniku wyszukiwania podzielona przez całkowitą liczbę dokumentów wyszukanych przez to wyszukiwanie.

W zadaniu klasyfikacyjnym precyzja dla klasy to liczba prawdziwie pozytywnych (tj. liczba elementów poprawnie oznaczonych jako należące do klasy pozytywnej) podzielona przez całkowitą liczbę elementów oznaczonych jako należące do pozytywnej klasy (tj. suma prawdziwe pozytywne i fałszywe alarmy , które są elementami nieprawidłowo oznaczonymi jako należące do klasy). Odwołanie w tym kontekście jest definiowane jako liczba prawdziwie pozytywnych podzielona przez całkowitą liczbę elementów, które faktycznie należą do klasy pozytywnej (tj. suma prawdziwie pozytywnych i fałszywie negatywnych , które nie zostały oznaczone jako należące do klasy pozytywnej ale powinno być).

W przypadku wyszukiwania informacji doskonały wynik dokładności wynoszący 1,0 oznacza, że każdy wynik uzyskany w wyniku wyszukiwania był istotny (ale nie mówi nic o tym, czy wszystkie istotne dokumenty zostały pobrane), podczas gdy doskonały wynik zapamiętywania wynoszący 1,0 oznacza, że wszystkie odpowiednie dokumenty zostały pobrane przez wyszukiwanie ( ale nic nie mówi o tym, ile nieistotnych dokumentów zostało również odzyskanych).

Precyzja i przypomnienie nie są szczególnie przydatnymi wskaźnikami, gdy są używane oddzielnie. Na przykład możliwe jest uzyskanie doskonałego przywołania, po prostu pobierając każdy pojedynczy element. Podobnie, można uzyskać niemal idealną precyzję, wybierając tylko bardzo małą liczbę bardzo prawdopodobnych elementów.

W zadaniu klasyfikacyjnym wynik precyzji równy 1,0 dla klasy C oznacza, że każda pozycja oznaczona jako należąca do klasy C rzeczywiście należy do klasy C (ale nie mówi nic o liczbie pozycji z klasy C, które nie zostały prawidłowo oznakowane), podczas gdy przypomnienie o wartości 1.0 oznacza, że każdy przedmiot z klasy C został oznaczony jako należący do klasy C (ale nic nie mówi o tym, ile przedmiotów z innych klas zostało również błędnie oznaczonych jako należące do klasy C).

Często istnieje odwrotna zależność między precyzją a pamięcią, gdzie możliwe jest zwiększenie jednego kosztem zmniejszenia drugiego. Chirurgia mózgu stanowi ilustracyjny przykład kompromisu. Rozważmy chirurga mózgu, który usuwa guza nowotworowego z mózgu pacjenta. Chirurg musi usunąć wszystkie komórki nowotworowe, ponieważ wszelkie pozostałe komórki rakowe zregenerują guz. I odwrotnie, chirurg nie może usuwać zdrowych komórek mózgowych, ponieważ spowoduje to upośledzenie funkcji mózgu u pacjenta. Chirurg może być bardziej liberalny w obszarze mózgu, który usuwa, aby upewnić się, że pobrał wszystkie komórki rakowe. Ta decyzja zwiększa pamięć, ale zmniejsza precyzję. Z drugiej strony chirurg może być bardziej konserwatywny w mózgu, który usuwa, aby mieć pewność, że wydobywa tylko komórki rakowe. Ta decyzja zwiększa precyzję, ale zmniejsza przypomnienie. Innymi słowy, większa pamięć zwiększa szanse na usunięcie zdrowych komórek (wynik negatywny) i zwiększa szanse na usunięcie wszystkich komórek rakowych (wynik pozytywny). Większa precyzja zmniejsza szanse na usunięcie zdrowych komórek (wynik pozytywny), ale także zmniejsza szanse na usunięcie wszystkich komórek rakowych (wynik negatywny).

Zwykle wyniki precyzji i przypominania nie są omawiane oddzielnie. Zamiast tego albo wartości jednej miary są porównywane na ustalonym poziomie drugiej miary (np. precyzja na poziomie przypominania 0,75 ), albo obie są łączone w jedną miarę. Przykładami miar, które są kombinacją precyzji i pamięci, są miara F (ważona harmoniczna średnia precyzji i pamięci) lub współczynnik korelacji Matthewsa , który jest średnią geometryczną wariantów skorygowanych o przypadek: współczynniki regresji Informedness ( DeltaP') i oznakowanie (DeltaP). Dokładność to ważona średnia arytmetyczna precyzji i odwrotnej precyzji (ważona przez odchylenie), a także ważona średnia arytmetyczna odwołań i odwrotnych odwołań (ważona częstością występowania). Odwrotna precyzja i odwrotne odtworzenie to po prostu precyzja i odwrotność problemu odwrotnego, w którym wymieniane są dodatnie i ujemne etykiety (zarówno dla klas rzeczywistych, jak i etykiet predykcji). Recall i Inverse Recall, lub równoważnie odsetek prawdziwie dodatnich i fałszywie dodatnich, są często wykreślane względem siebie jako krzywe ROC i zapewniają zasadniczy mechanizm do badania kompromisów między punktami operacyjnymi. Poza odzyskiwaniem informacji, zastosowanie Recall, Precision i F-measure jest uważane za wadliwe, ponieważ ignorują one prawdziwie ujemną komórkę tabeli kontyngencji i można nimi łatwo manipulować poprzez stronniczość prognoz. Pierwszy problem „rozwiązuje się” za pomocą dokładności, a drugi problem „rozwiązuje się” przez zdyskontowanie składnika szansy i ponowną normalizację do kappa Cohena , ale nie daje to już możliwości graficznego zbadania kompromisów. Jednak Informedness i Markedness są podobnymi do Kappa renormalizacjami Recall i Precision, a ich średnia geometryczna współczynnika korelacji Matthewsa działa zatem jak nieobciążona miara F.

Definicja (kontekst wyszukiwania informacji)

W kontekstach wyszukiwania informacji precyzja i przywoływanie są definiowane w kategoriach zestawu wyszukanych dokumentów (np. lista dokumentów stworzona przez wyszukiwarkę internetową dla zapytania) oraz zestaw odpowiednich dokumentów (np. lista wszystkich dokumentów w Internecie które są istotne dla określonego tematu), zob. trafność .

Precyzja

W dziedzinie wyszukiwania informacji precyzja to ułamek wyszukanych dokumentów, które są istotne dla zapytania:

Na przykład w przypadku wyszukiwania tekstowego w zestawie dokumentów precyzja to liczba poprawnych wyników podzielona przez liczbę wszystkich zwróconych wyników.

Precyzja bierze pod uwagę wszystkie pobrane dokumenty, ale może być również oceniana na danym poziomie odcięcia, biorąc pod uwagę tylko najwyższe wyniki zwracane przez system. Ta miara nazywa się precyzją w n lub P@n .

Precyzja jest używana z odwołaniem, procentem wszystkich odpowiednich dokumentów, które są zwracane przez wyszukiwanie. Te dwie miary są czasami używane razem w F 1 Score (lub miara f), aby zapewnić pojedynczy pomiar dla systemu.

Należy zauważyć, że znaczenie i użycie „precyzji” w dziedzinie wyszukiwania informacji różni się od definicji dokładności i precyzji w innych gałęziach nauki i technologii.

Przypomnienie sobie czegoś

W wyszukiwaniu informacji wycofanie to ułamek odpowiednich dokumentów, które zostały pomyślnie odzyskane.

Na przykład w przypadku wyszukiwania tekstowego w zestawie dokumentów odwołanie to liczba poprawnych wyników podzielona przez liczbę wyników, które powinny zostać zwrócone.

W klasyfikacji binarnej przywołanie nazywa się wrażliwością . Można to traktować jako prawdopodobieństwo wyszukania odpowiedniego dokumentu przez zapytanie.

Osiągnięcie 100% wycofania poprzez zwrócenie wszystkich dokumentów w odpowiedzi na jakiekolwiek zapytanie jest trywialne. Dlatego samo wycofanie nie wystarczy, ale trzeba również zmierzyć liczbę nieistotnych dokumentów, na przykład poprzez obliczenie precyzji.

Definicja (kontekst klasyfikacji)

W przypadku zadań klasyfikacyjnych terminy prawdziwie pozytywne , prawdziwie negatywne , fałszywie pozytywne i fałszywie negatywne (patrz definicje błędów typu I i typu II ) porównują wyniki testowanego klasyfikatora z zaufanymi ocenami zewnętrznymi. Terminy pozytywne i negatywne odnoszą się do przewidywania klasyfikatora (czasami znanego jako oczekiwanie ), a terminy prawda i fałsz odnoszą się do tego, czy przewidywanie odpowiada osądowi zewnętrznemu (czasami znanemu jako obserwacja ).

Zdefiniujmy eksperyment z P pozytywnych przypadków i N negatywnych przypadków dla pewnego warunku. Cztery wyniki można sformułować w tabeli kontyngencji 2×2 lub macierzy pomyłek w następujący sposób:

| Przewidywany stan | Źródła: | ||||

|

Całkowita populacja = P + N |

Pozytywny (PP) | Negatywne (PN) | Świadomość, świadomość bukmachera (BM) = TPR + TNR − 1 |

Próg chorobowości (PT) = √ TPR × FPR − FPR/TPR − FPR |

|

| Pozytywny (P) |

Prawdziwie pozytywne (TP), trafienie |

Fałszywie ujemny (FN), błąd typu II , brak, niedoszacowanie |

Prawdziwie dodatni wskaźnik (TPR), przywołanie , czułość (SEN), prawdopodobieństwo wykrycia, wskaźnik trafień, moc =TP/P = 1 − FNR |

Współczynnik fałszywie ujemnych (FNR), współczynnik chybień =FN/P = 1 − TPR |

|

| Ujemny (N) |

Fałszywie dodatni (FP), błąd typu I , fałszywy alarm, przeszacowanie |

Prawdziwie ujemna (TN), prawidłowe odrzucenie |

Wskaźnik fałszywie dodatnich (FPR), prawdopodobieństwo fałszywego alarmu, wypadanie =FP/n = 1 − TNR |

Prawdziwie ujemna stopa (TNR), swoistość (SPC), selektywność =TN/n = 1 − FPR |

|

|

Występowanie =P/P + N |

Dodatnia wartość predykcyjna (PPV), precyzja =TP/PP = 1 − FDR |

Wskaźnik fałszywych pominięć (FOR) =FN/PN = 1 − NPV |

Dodatni współczynnik wiarygodności (LR+) =TPR/FPR |

Ujemny współczynnik wiarygodności (LR−) =FNR/TNR |

|

| Dokładność (ACC) =TP + TN/P + N |

Wskaźnik fałszywych odkryć (FDR) =FP/PP = 1 − PPV |

Ujemna wartość predykcyjna (NPV) =TN/PN = 1 − FOR |

Oznakowanie (MK), deltaP (Δp) = PPV + NPV − 1 |

Iloraz szans diagnostycznych (DOR) =LR+/LR− | |

| Zrównoważona dokładność (BA) =TPR + TNR/2 |

Wynik F 1 =2 PPV × TPR/PPV + TPR = 2 TP/2 TP + PR + FN |

Indeks Fowlkesa-Mallowsa (FM) = √ PPV×TPR |

Współczynnik korelacji Matthewsa (MCC) = √ TPR×TNR×PPV×NPV − √ FNR×FPR×FOR×FDR |

Ocena zagrożenia (TS), wskaźnik krytycznego sukcesu (CSI), wskaźnik Jaccarda =TP/TP + FN + FP | |

Źródła: Fawcett (2006), Piryonesi i El-Diraby (2020), Powers (2011), Ting (2011), CAWCR, D. Chicco i G. Jurman (2020, 2021) , Tharwat (2018). |

Precyzja i wycofanie są następnie definiowane jako:

Przypomnienie w tym kontekście jest również określane jako prawdziwie dodatnia częstość lub czułość , a precyzja jest również określana jako dodatnia wartość predykcyjna (PPV); inne pokrewne miary stosowane w klasyfikacji obejmują prawdziwie ujemną stawkę i dokładność . Prawdziwie ujemna stawka nazywana jest również specyficznością .

Niezrównoważone dane

Dokładność może być mylącą metryką w przypadku niezrównoważonych zestawów danych. Rozważ próbkę z 95 ujemnymi i 5 dodatnimi wartościami. Zaklasyfikowanie wszystkich wartości jako ujemnych w tym przypadku daje wynik dokładności 0,95. Istnieje wiele wskaźników, które nie cierpią z powodu tego problemu. Na przykład zrównoważona dokładność (bACC) normalizuje prawdziwie dodatnie i prawdziwie ujemne predykcje odpowiednio przez liczbę dodatnich i ujemnych próbek i dzieli ich sumę przez dwa:

W poprzednim przykładzie (95 negatywnych i 5 pozytywnych próbek) zaklasyfikowanie wszystkich jako negatywnych daje 0,5 zrównoważonego wyniku dokładności (maksymalny wynik bACC wynosi jeden), co odpowiada oczekiwanej wartości losowego odgadnięcia w zrównoważonym zestawie danych. Zrównoważona dokładność może służyć jako ogólna metryka wydajności dla modelu, niezależnie od tego, czy prawdziwe etykiety są niezrównoważone w danych, zakładając, że koszt FN jest taki sam jak FP.

Inną metryką jest wskaźnik przewidywanego stanu pozytywnego (PPCR), który określa procent całej populacji, który jest oflagowany. Na przykład dla wyszukiwarki, która zwraca 30 wyników (pobrane dokumenty) z 1 000 000 dokumentów, PPCR wynosi 0,003%.

Według Saito i Rehmsmeiera, podczas oceny klasyfikatorów binarnych na niezrównoważonych danych, wykresy precyzyjnego odtworzenia są bardziej pouczające niż wykresy ROC. W takich scenariuszach wykresy ROC mogą być wizualnie mylące w odniesieniu do wniosków dotyczących wiarygodności wyników klasyfikacji.

W przeciwieństwie do powyższych podejść, jeśli skalowanie niezrównoważenia jest stosowane bezpośrednio poprzez ważenie elementów macierzy pomyłek, standardowe definicje metryk nadal mają zastosowanie nawet w przypadku niezrównoważonych zestawów danych. Procedura ważenia wiąże elementy macierzy pomyłek ze zbiorem pomocniczym każdej rozważanej klasy.

Interpretacja probabilistyczna

Można też interpretować precyzję i przypominać nie jako wskaźniki, ale jako oszacowania prawdopodobieństw:

- Precyzja to szacowane prawdopodobieństwo, że dokument losowo wybrany z puli wyszukanych dokumentów jest odpowiedni.

- Przypomnij to szacowane prawdopodobieństwo, że zostanie pobrany dokument losowo wybrany z puli odpowiednich dokumentów.

Inną interpretacją jest to, że precyzja jest średnim prawdopodobieństwem odpowiedniego wyszukania, a przywołanie jest średnim prawdopodobieństwem pełnego pobrania uśrednionym dla wielu zapytań o wyszukiwanie.

Miara F

Miarą, która łączy precyzję i przywołanie, jest średnia harmoniczna precyzji i przywołania, tradycyjna miara F lub zrównoważona wartość F:

Miara ta jest w przybliżeniu średnią tych dwóch, gdy są one bliskie, i ogólnie jest średnią harmoniczną , która w przypadku dwóch liczb pokrywa się z kwadratem średniej geometrycznej podzielonej przez średnią arytmetyczną . Istnieje kilka powodów, dla których wskaźnik F-score może być krytykowany w określonych okolicznościach ze względu na jego stronniczość jako metrykę oceny. Nazywa się to również miarą, ponieważ odwołanie i precyzja są ważone równomiernie.

Jest to szczególny przypadek miary ogólnej (dla nieujemnych wartości rzeczywistych ):

Dwie inne powszechnie używane miary to miara, której wagi przypominają bardziej niż precyzja, oraz miara, która kładzie większy nacisk na precyzję niż odwoływanie.

Miara F została wyprowadzona przez van Rijsbergena (1979), aby „mierzyć skuteczność wyszukiwania w odniesieniu do użytkownika, który przywiązuje tyle samo znaczenia do przypomnienia, co precyzja”. Opiera się na mierze efektywności van Rijsbergena , przy czym drugim terminem jest ważona średnia harmoniczna precyzji i przywołania z wagami . Ich związek jest tam .

Ograniczenia jako cele

Istnieją inne parametry i strategie metryki wydajności systemu wyszukiwania informacji, takie jak obszar pod krzywą ROC (AUC).

Zobacz też

- Współczynnik niepewności zwany również biegłością

- Czułość i specyficzność

Bibliografia

- Baeza-Yates, Ricardo; Ribeiro-Neto, Berthier (1999). Nowoczesne wyszukiwanie informacji . Nowy Jork, NY: ACM Press, Addison-Wesley, Seiten 75 ff. ISBN 0-201-39829-X

- Hjørland, Birger (2010); Podstawa koncepcji relewancji , Journal of the American Society for Information Science and Technology, 61(2), 217-237

- Makhoul, Jan ; Kubali, Franciszek; Schwartz, Richard; i Weischedel, Ralph (1999); Miary wydajności dla ekstrakcji informacji , w Proceedings of DARPA Broadcast News Workshop, Herndon, VA, luty 1999

- van Rijsbergen, Cornelis Joost "Keith" (1979); Wyszukiwarka informacji , Londyn, GB; Boston, MA: Butterworth, wydanie 2, ISBN 0-408-70929-4