Lasso (statystyki) - Lasso (statistics)

W statystykach i uczenia maszyny , lasso ( przynajmniej absolutnego skurczu i operatora selekcji , również Lasso lub lasso ) jest analizy regresji metodą, która wykonuje zarówno wybór zmiennej i uregulowanie w celu zwiększenia dokładności przewidywania i interpretability otrzymanego modelu statystycznego . Została pierwotnie wprowadzona do geofizyki , a później przez Roberta Tibshirani , który ukuł ten termin.

Lasso został pierwotnie sformułowany dla modeli regresji liniowej . Ten prosty przypadek ujawnia znaczną część estymatora. Obejmują one jego związek z regresją grzbietową i wyborem najlepszego podzbioru oraz powiązania między oszacowaniami współczynnika lassa a tak zwanym miękkim progowaniem. Pokazuje również, że (podobnie jak standardowa regresja liniowa) oszacowania współczynnika nie muszą być unikalne, jeśli współzmienne są współliniowe .

Chociaż pierwotnie zdefiniowana dla regresji liniowej, regularyzacja lassa jest łatwo rozszerzona na inne modele statystyczne, w tym uogólnione modele liniowe , uogólnione równania estymujące , modele proporcjonalnego hazardu i M-estymatory . Zdolność Lasso do wykonywania selekcji podzbiorów opiera się na formie ograniczenia i ma wiele interpretacji, w tym w zakresie geometrii , statystyki bayesowskiej i analizy wypukłej .

LASSO jest ściśle związane z odszumianiem pościgu podstawowego .

Motywacja

Lasso wprowadzono w celu poprawy dokładności przewidywania i interpretacji modeli regresji. Wybiera zredukowany zestaw znanych współzmiennych do użycia w modelu.

Historia

Lasso zostało opracowane niezależnie w literaturze geofizycznej w 1986 roku, w oparciu o wcześniejsze prace, w których stosowano karę zarówno do dopasowania, jak i karania współczynników. Statystyk Robert Tibshirani niezależnie odkrył i spopularyzował go w 1996 roku, na podstawie Breiman nieujemną garotą „s.

Przed lassem najszerzej stosowaną metodą wyboru współzmiennych była selekcja krokowa . Takie podejście poprawia dokładność predykcji tylko w niektórych przypadkach, na przykład gdy tylko kilka zmiennych towarzyszących ma silny związek z wynikiem. Jednak w innych przypadkach może zwiększyć błąd przewidywania.

W tamtym czasie najpopularniejszą techniką poprawy dokładności prognoz była regresja grzbietowa . Regresja grzbietowa poprawia błąd predykcji, zmniejszając sumę kwadratów współczynników regresji do wartości mniejszej niż stała wartość w celu zmniejszenia przepełnienia , ale nie dokonuje selekcji współzmiennej, a zatem nie pomaga w poprawie interpretacji modelu.

Lasso osiąga oba te cele, wymuszając, aby suma wartości bezwzględnych współczynników regresji była mniejsza niż wartość stała, co wymusza zerowanie niektórych współczynników, wykluczając je z wpływu na przewidywanie. Ten pomysł jest podobny do regresji grzbietowej, która również zmniejsza rozmiar współczynników, jednak regresja grzbietowa ma tendencję do ustawiania znacznie mniejszej liczby współczynników na zero.

Podstawowa forma

Najmniej kwadratów

Rozważ próbę składającą się z N przypadków, z których każdy składa się z p zmiennych towarzyszących i jednego wyniku. Niech będzie wynikiem i będzie wektorem współzmiennym dla i- tego przypadku. Wtedy celem lasso jest rozwiązanie

Oto stały współczynnik, jest wektorem współczynników i jest z góry określonym wolnym parametrem, który określa stopień regularyzacji.

Pozostawiając macierz współzmienną, tak że i jest i- tym rzędem , wyrażenie można zapisać bardziej zwięźle jako

gdzie jest standardową normą i jest wektorem jedynek.

Oznaczając średnią skalarną punktów danych przez i średnią zmiennych odpowiedzi przez , wynikowe oszacowanie dla jest , tak że

dlatego standardowo pracuje się ze zmiennymi, które zostały ustawione na zero. Dodatkowo współzmienne są zazwyczaj standaryzowane, aby rozwiązanie nie zależało od skali pomiaru.

Pomocne może być przepisanie

w tzw. formie Lagrange'a

gdzie dokładny związek między i jest zależny od danych.

Współzmienne ortonormalne

Można teraz rozważyć kilka podstawowych właściwości estymatora lasso.

Zakładając najpierw, że współzmienne są ortonormalne, tak że , gdzie jest iloczynem skalarnym i jest deltą Kroneckera , lub równoważnie, , a następnie stosując metody podgradientowe można wykazać, że

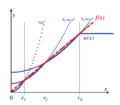

jest określany jako operator miękkiego progowania, ponieważ tłumaczy wartości w kierunku zera (czyniąc je dokładnie zerowymi, jeśli są wystarczająco małe), zamiast ustawiać mniejsze wartości na zero i pozostawiać większe nietknięte, jak zrobiłby to operator twardego progowania, często oznaczany .

W regresji grzbietowej celem jest minimalizacja

wydajność

Regresja grzbietowa zmniejsza wszystkie współczynniki o jednolity współczynnik i nie ustawia żadnych współczynników na zero.

Można to również porównać do regresji z selekcją najlepszego podzbioru , w której celem jest minimalizacja

gdzie jest „ norma”, która jest zdefiniowana tak, jakby dokładnie m składowych z jest niezerowe. W tym przypadku można wykazać, że

gdzie jest tak zwaną funkcją twardego progu i jest funkcją wskaźnika (jest 1, jeśli jej argument jest prawdziwy, a 0 w przeciwnym razie).

Dlatego oszacowania lasso mają wspólne cechy regresji wyboru grzbietu i najlepszego podzbioru, ponieważ oba zmniejszają wielkość wszystkich współczynników, jak regresja grzbietowa, i ustawiają niektóre z nich na zero, jak w przypadku wyboru najlepszego podzbioru. Dodatkowo, podczas gdy regresja grzbietu skaluje wszystkie współczynniki za pomocą stałego współczynnika, lasso zamiast tego przekształca współczynniki w kierunku zera o stałą wartość i ustawia je na zero, jeśli osiągną tę wartość.

W jednym szczególnym przypadku dwie współzmienne, powiedzmy j i k , są identyczne dla każdej obserwacji, tak że , gdzie . Wówczas wartości i minimalizujące funkcję celu lasso nie są jednoznacznie określone. W rzeczywistości, jeśli niektóre, w których , to jeśli zastąpienie przez i przez , zachowując wszystkie inne stałe, daje nowe rozwiązanie, więc funkcja celu lasso ma wtedy kontinuum prawidłowych minimalizatorów. Kilka wariantów lassa, w tym regularyzacja sieci elastycznej , zostało zaprojektowanych w celu usunięcia tego niedociągnięcia.

Ogólna forma

Regularyzacja lasso może być rozszerzona na inne funkcje celu, takie jak te dla uogólnionych modeli liniowych , uogólnionych równań estymujących , modeli proporcjonalnych hazardów i M-estymatorów . Biorąc pod uwagę funkcję celu

uregulowana przez lasso wersja estymatora jest rozwiązaniem

gdzie karane jest tylko wtedy, gdy wolno przyjmować dowolną dozwoloną wartość, tak jak nie było karane w podstawowym przypadku.

Interpretacje

Interpretacja geometryczna

Lasso może ustawić współczynniki na zero, podczas gdy powierzchownie podobna regresja grzbietu nie. Wynika to z różnicy w kształcie ich granic ograniczeń. Regresję lassa i grzbietu można interpretować jako minimalizację tej samej funkcji celu

ale w odniesieniu do różnych ograniczeń: na lasso i na grzbiet. Rysunek pokazuje, że obszar więzów zdefiniowany przez normę jest kwadratem obróconym tak, że jego rogi leżą na osiach (ogólnie jest to cross-politop ), podczas gdy obszar zdefiniowany przez normę jest kołem (ogólnie n -sferą ) , który jest niezmienny rotacyjnie i dlatego nie ma narożników. Jak widać na rysunku, obiekt wypukły leżący stycznie do granicy, taki jak pokazana linia, prawdopodobnie napotka róg (lub odpowiednik w wyższych wymiarach) hipersześcianu, którego niektóre składowe są identycznie zerowe, podczas gdy w przypadku n- sfery, punkty na granicy, dla których niektóre składowe są zerowe, nie są rozróżniane od innych, a obiekt wypukły nie ma większego prawdopodobieństwa zetknięcia się z punktem, w którym niektóre składowe mają wartość zero niż jeden dla których żaden z nich nie jest.

Ułatwienie interpretacji λ dzięki kompromisowi między dokładnością a prostotą

Lasso można przeskalować, aby łatwo było przewidzieć i wpłynąć na stopień skurczu związany z daną wartością . Zakłada się, że jest standaryzowany z-scores i jest wyśrodkowany (średnia zerowa). Niech reprezentuje hipotezę współczynniki regresji i pozwolić znajdują się w zwykłych roztworach najmniej danych zoptymalizowane kwadratów. Następnie możemy zdefiniować Lagrange'a jako kompromis między dokładnością w próbce rozwiązań zoptymalizowanych pod kątem danych a prostotą trzymania się hipotetycznych wartości. To skutkuje

gdzie określono poniżej. Pierwszy ułamek reprezentuje względną dokładność, drugi ułamek względną prostotę i równowagę między nimi.

Biorąc pod uwagę pojedynczy regresor, względną prostotę można zdefiniować, określając jako , która jest maksymalną wartością odchylenia od kiedy . Zakładając , że ścieżka rozwiązania może być zdefiniowana w kategoriach :

Jeśli , używane jest zwykłe rozwiązanie najmniejszych kwadratów (OLS). Hipotetyczna wartość jest wybierana, jeśli jest większa niż . Ponadto, jeśli , to reprezentuje proporcjonalny wpływ . Innymi słowy, mierzy w ujęciu procentowym minimalną wielkość wpływu hipotetycznej wartości w stosunku do zoptymalizowanego pod względem danych rozwiązania OLS.

Jeśli -norma jest używana do karania odchyleń od zera przy danym pojedynczym regresorze, ścieżka rozwiązania jest dana przez

. Podobnie jak , porusza się w kierunku punktu, gdy jest bliski zeru; ale w przeciwieństwie do , wpływ maleje, jeśli wzrasta (patrz rysunek). Biorąc pod uwagę wiele regresorów, moment, w którym parametr jest aktywowany (tj. może odejść od ) jest również określany przez wkład regresora w dokładność. Najpierw,

Wartość 75% oznacza, że dokładność w próbce poprawia się o 75%, jeśli zamiast hipotetycznych wartości stosowane są nieograniczone rozwiązania OLS . Indywidualny wkład odchylenia od każdej hipotezy można obliczyć za pomocą macierzy x

gdzie . Jeśli oblicza się kiedy , to elementy przekątne sumy do . Wartości przekątne mogą być mniejsze niż 0 lub, rzadziej, większe niż 1. Jeśli regresory nie są skorelowane, wówczas element diagonalny po prostu odpowiada wartości między i .

Przeskalowaną wersję adaptacyjnego lasso można uzyskać, ustawiając . Jeśli regresory nie są skorelowane, moment aktywacji parametru jest określony przez element diagonalny . Zakładając dla wygody, że jest to wektor zer,

Oznacza to, że jeśli regresory są nieskorelowane, ponownie określa minimalny wpływ . Nawet jeśli regresory są skorelowane, pierwszy raz, gdy parametr regresji jest aktywowany, ma miejsce, gdy jest równy najwyższemu elementowi diagonalnej .

Wyniki te można porównać do przeskalowanej wersji lassa poprzez zdefiniowanie , które jest średnim bezwzględnym odchyleniem od . Zakładając, że regresory nie są skorelowane, to moment aktywacji regresora jest podany przez

Dla , moment aktywacji jest ponownie podany przez . Jeśli jest wektorem zer i podzbiór odpowiednich parametrów jest w równym stopniu odpowiedzialny za idealne dopasowanie , to ten podzbiór jest aktywowany przy wartości . Moment aktywacji odpowiedniego regresora jest wtedy równy . Innymi słowy, włączenie nieistotnych regresorów opóźnia moment, w którym odpowiednie regresory są aktywowane przez to przeskalowane lasso. Lasso adaptacyjne i lasso są szczególnymi przypadkami estymatora „1ASTc”. Ta ostatnia grupuje parametry tylko wtedy, gdy bezwzględna korelacja między regresorami jest większa niż wartość określona przez użytkownika.

Interpretacja bayesowska

Tak jak regresję grzbietową można interpretować jako regresję liniową, dla której współczynnikom przypisano normalne rozkłady uprzednie, lasso można interpretować jako regresję liniową, dla której współczynniki mają rozkłady uprzednie Laplace'a . Rozkład Laplace'a ma ostry pik przy zerze (jego pierwsza pochodna jest nieciągła przy zerze) i koncentruje swoją masę prawdopodobieństwa bliżej zera niż rozkład normalny. Zapewnia to alternatywne wyjaśnienie, dlaczego lasso ma tendencję do ustawiania niektórych współczynników na zero, podczas gdy regresja grzbietu nie.

Wypukła interpretacja relaksacyjna

Lasso można również postrzegać jako wypukłą relaksację problemu regresji wyboru najlepszego podzbioru, która polega na znalezieniu podzbioru zmiennych towarzyszących, który daje najmniejszą wartość funkcji celu dla pewnego ustalonego , gdzie n jest całkowitą liczbą zmiennych towarzyszących. W „ norma” , (liczba wpisów niezerowych wektora), jest ograniczenie przypadku „ normy”, z postaci (gdzie cudzysłów oznacza, że nie są to naprawdę Normy ponieważ nie jest wypukła dla , więc nierówność trójkąta nie zachodzi). W związku z tym, ponieważ p = 1 jest najmniejszą wartością, dla której „ norma” jest wypukła (a zatem faktycznie normą), lasso jest w pewnym sensie najlepszym wypukłym przybliżeniem do problemu wyboru najlepszego podzbioru, ponieważ obszar zdefiniowany przez jest wypukły kadłuba regionu określone dla .

Uogólnienia

Warianty Lasso zostały stworzone w celu usunięcia ograniczeń oryginalnej techniki i uczynienia metody bardziej użyteczną w konkretnych problemach. Prawie wszystkie z nich koncentrują się na poszanowaniu lub wykorzystywaniu zależności między współzmiennymi.

Elastyczna regularyzacja netto dodaje dodatkową karę podobną do regresji grzbietowej, która poprawia wydajność, gdy liczba predyktorów jest większa niż wielkość próbki, umożliwia metodzie wybór silnie skorelowanych zmiennych razem i poprawia ogólną dokładność predykcji.

Lasso grupowe umożliwia wybranie grup powiązanych zmiennych towarzyszących jako pojedynczej jednostki, co może być przydatne w ustawieniach, w których nie ma sensu dołączanie niektórych zmiennych towarzyszących bez innych. Dalsze rozszerzenia lassa grupowego dokonują selekcji zmiennych w obrębie poszczególnych grup (lasso grupowe) i umożliwiają nakładanie się grup (lasso grupowe pokrywające się).

Połączone lasso może uwzględniać przestrzenną lub czasową charakterystykę problemu, dzięki czemu szacunki lepiej pasują do struktury systemu. Modele uregulowane metodą lasso można dopasować przy użyciu technik, w tym metod subgradientowych , regresji najmniejszych kątów (LARS) i metod gradientu proksymalnego . Określenie optymalnej wartości parametru regularyzacji jest ważną częścią zapewnienia, że model działa prawidłowo; jest zwykle wybierany za pomocą walidacji krzyżowej .

Elastyczna siatka

W 2005 roku Zou i Hastie wprowadzili elastyczną siatkę . Gdy p > n (liczba zmiennych towarzyszących jest większa niż wielkość próby), lasso może wybrać tylko n zmiennych towarzyszących (nawet jeśli z wynikiem jest powiązanych więcej) i ma tendencję do wybierania jednej zmiennej towarzyszącej z dowolnego zestawu wysoce skorelowanych zmiennych towarzyszących. Dodatkowo, nawet gdy n > p , regresja grzbietowa ma tendencję do osiągania lepszych wyników przy silnie skorelowanych współzmiennych.

Elastyczna siatka wydłuża lasso, dodając dodatkowy termin karny dający

co jest równoznaczne z rozwiązywaniem

Ten problem można zapisać w prostej formie lasso

wpuszczanie

- , ,

Wtedy , które, gdy współzmienne są względem siebie ortogonalne, daje

Tak więc wynik kary za elastyczną siatkę jest kombinacją efektów kary na lasso i za grzbiet.

Wracając do przypadku ogólnego, fakt, że funkcja kara jest teraz ściśle wypukłe oznacza, że jeśli , , który jest zmiana z lasso. Ogólnie, jeśli

jest macierzą korelacji próbki, ponieważ 's są znormalizowane.

Dlatego wysoce skorelowane współzmienne mają zwykle podobne współczynniki regresji, przy czym stopień podobieństwa zależy od obu i , co różni się od lasso. Zjawisko to, w którym współzmienne silnie skorelowane mają podobne współczynniki regresji, określane jest mianem efektu grupowania. Grupowanie jest pożądane, ponieważ w zastosowaniach, takich jak wiązanie genów z chorobą, preferowane jest znalezienie wszystkich powiązanych zmiennych towarzyszących, niż wybieranie jednej z każdego zestawu skorelowanych zmiennych towarzyszących, jak to często robi Lasso. Ponadto wybranie tylko jednego z każdej grupy zwykle skutkuje zwiększonym błędem predykcji, ponieważ model jest mniej odporny (dlatego regresja grzbietowa często przewyższa lasso).

Grupowe lasso

W 2006 roku Yuan i Lin wprowadzili lasso grupowe, aby umożliwić wspólne wybieranie wstępnie zdefiniowanych grup zmiennych towarzyszących do lub z modelu. Jest to przydatne w wielu ustawieniach, być może najbardziej oczywiste, gdy zmienna kategorialna jest zakodowana jako zbiór binarnych zmiennych towarzyszących. W takim przypadku lasso grupowe może zapewnić, że wszystkie zmienne kodujące współzmienną jakościową zostaną uwzględnione lub wykluczone razem. Innym środowiskiem, w którym grupowanie jest naturalne, są badania biologiczne. Ponieważ geny i białka często leżą w znanych szlakach, to, które szlaki są powiązane z wynikiem, mogą być ważniejsze niż to, czy poszczególne geny są. Funkcja celu dla lassa grupowego jest naturalnym uogólnieniem standardowego celu lassa

gdzie macierz projektu i wektor towarzyszący zostały zastąpione zbiorem macierzy projektu i wektorów towarzyszących , po jednym dla każdej z grup J. Dodatkowo okres kary jest teraz sumą ponad normy określone przez dodatnie określone macierze . Jeśli każda współzmienna znajduje się we własnej grupie i , to sprowadza się to do standardowego lassa, natomiast jeśli istnieje tylko jedna grupa i , sprowadza się to do regresji grzbietowej. Ponieważ kara sprowadza się do normy na podprzestrzeniach określonych przez każdą grupę, nie może wybrać z grupy tylko niektórych zmiennych towarzyszących, tak jak nie może tego dokonać regresja grzbietowa. Ponieważ jednak kara jest sumą po różnych normach podprzestrzennych, tak jak w standardowym lasso, więz ma pewne punkty nieróżnicowe, które odpowiadają niektórym podprzestrzeniom równym zero. Dlatego może ustawić wektory współczynników odpowiadające niektórym podprzestrzeniom na zero, a tylko zmniejszyć inne. Istnieje jednak możliwość rozszerzenia lassa grupowego o tzw. lasso grupowe, które może wybierać poszczególne współzmienne w obrębie grupy, dodając dodatkową karę do każdej podprzestrzeni grupowej. Kolejne rozszerzenie, lasso grupowe z nakładaniem się, umożliwia współzmienne współzmienne między grupami, np. jeśli gen miałby wystąpić na dwóch szlakach.

Połączone lasso

W niektórych przypadkach badane zjawisko może mieć ważną strukturę przestrzenną lub czasową, którą należy wziąć pod uwagę podczas analizy, np. szeregi czasowe lub dane obrazowe. W 2005 roku Tibshirani i współpracownicy wprowadzili fuzyjne lasso, aby rozszerzyć wykorzystanie lasso na tego typu dane. Połączona funkcja celu lasso to

Pierwszym ograniczeniem jest ograniczenie lasso, podczas gdy drugie bezpośrednio karze duże zmiany w odniesieniu do struktury czasowej lub przestrzennej, co wymusza płynną zmianę współczynników, aby odzwierciedlić logikę leżącą u podstaw systemu. Lasso skupione jest uogólnieniem skondensowanego lassa, które identyfikuje i grupuje odpowiednie współzmienne na podstawie ich efektów (współczynników). Podstawową ideą jest takie karanie różnic między współczynnikami, aby niezerowe się skupiały. Można to modelować za pomocą następującej regularyzacji:

W przeciwieństwie do tego, zmienne można pogrupować w silnie skorelowane grupy, a następnie z każdego skupienia można wyodrębnić jedną reprezentatywną współzmienną.

Istnieją algorytmy, które rozwiązują problem stopionego lassa i pewne jego uogólnienia. Algorytmy mogą to rozwiązać dokładnie w skończonej liczbie operacji.

Quasi-normy i regresja mostowa

Lasso, elastyczna sieć, grupa i skondensowane lasso konstruują funkcje kary z norm i (w razie potrzeby z wagami). Regresja mostkowa wykorzystuje normy ogólne ( ) i quasinormy ( ). Na przykład dla p = 1/2 analogiem celu lasso w formie Lagrange'a jest rozwiązanie

gdzie

Twierdzi się, że quasi-normy ułamkowe ( ) dostarczają bardziej znaczących wyników w analizie danych zarówno teoretycznie, jak i empirycznie. Niewypukłość tych quasi-norm komplikuje problem optymalizacji. Aby rozwiązać ten problem, opracowano i wdrożono procedurę minimalizacji oczekiwań w celu minimalizacji funkcji

gdzie jest dowolną wklęsłą monotonicznie rosnącą funkcją (na przykład daje karę za lasso i daje karę).

Wydajny algorytm minimalizacji oparty jest na aproksymacji kwadratowej wzrostu podkwadratowego (PQSQ).

Lasso adaptacyjne

Lasso adaptacyjne zostało wprowadzone przez Zou w 2006 roku dla regresji liniowej oraz przez Zhanga i Lu w 2007 roku dla regresji proporcjonalnych hazardów.

Wcześniejsze lasso

Wcześniejsze lasso zostało wprowadzone do uogólnionych modeli liniowych przez Jianga i in. w 2016 r., aby uwzględnić wcześniejsze informacje, takie jak znaczenie niektórych współzmiennych. W poprzednim lasso takie informacje są podsumowywane w pseudoodpowiedziach (nazywanych wcześniejszymi odpowiedziami), a następnie do zwykłej funkcji celu dodawana jest dodatkowa funkcja kryterium z karą za lasso. Bez utraty ogólności, w regresji liniowej, nową funkcję celu można zapisać jako

co jest równoważne

zwykła funkcja celu lasso z odpowiedziami zastępowanymi średnią ważoną zaobserwowanych odpowiedzi i wcześniejszych odpowiedzi (nazywanych skorygowanymi wartościami odpowiedzi przez wcześniejsze informacje).

W poprzednim lasso parametr jest nazywany parametrem równoważącym, ponieważ równoważy względną ważność danych i wcześniejszych informacji. W skrajnym przypadku , wcześniejsze lasso zostaje zredukowane do lasso. Jeśli , wcześniejsze lasso będzie polegać wyłącznie na wcześniejszych informacjach, aby dopasować model. Co więcej, parametr równoważący ma inną atrakcyjną interpretację: kontroluje wariancję swojego wcześniejszego rozkładu z bayesowskiego punktu widzenia.

Wcześniejsze lasso jest bardziej wydajne w estymacji i predykcji parametrów (z mniejszym błędem estymacji i błędem predykcji), gdy informacje wcześniejsze są wysokiej jakości i są odporne na informacje wcześniejsze o niskiej jakości z dobrym wyborem parametru równoważenia .

Rozwiązania do komputerowego lasso

Funkcja straty lassa nie jest różniczkowalna, ale opracowano szeroką gamę technik z analizy wypukłej i teorii optymalizacji w celu obliczenia ścieżki rozwiązania lassa. Obejmują one zejście współrzędnych, metody subgradientowe, regresję najmniejszych kątów (LARS) i metody gradientu proksymalnego. Metody subgradientowe są naturalnym uogólnieniem tradycyjnych metod, takich jak gradient gradientu i stochastycznego spadku gradientu na przypadek, w którym funkcja celu nie jest we wszystkich punktach różniczkowalna. LARS to metoda ściśle powiązana z modelami lasso i w wielu przypadkach pozwala na ich efektywne dopasowanie, chociaż może nie działać dobrze we wszystkich okolicznościach. LARS generuje kompletne ścieżki rozwiązań. Metody proksymalne stały się popularne ze względu na swoją elastyczność i wydajność i są obszarem aktywnych badań. Wybór metody będzie zależał od konkretnego wariantu lassa, danych i dostępnych zasobów. Jednak metody proksymalne na ogół dobrze się sprawdzają.

Wybór parametru regularyzacji

Wybór parametru regularyzacji ( ) jest podstawową częścią lassa. Dobra wartość ma kluczowe znaczenie dla wydajności lassa, ponieważ kontroluje siłę skurczu i wybór zmiennych, co z umiarem może poprawić zarówno dokładność przewidywania, jak i interpretację. Jeśli jednak regularyzacja stanie się zbyt silna, ważne zmienne mogą zostać pominięte, a współczynniki mogą zostać nadmiernie zmniejszone, co może zaszkodzić zarówno zdolności predykcyjnej, jak i wnioskowaniu. Walidacja krzyżowa jest często używana do znalezienia parametru regularyzacji.

Kryteria informacyjne, takie jak Bayesowskie kryterium informacyjne (BIC) i kryterium informacyjne Akaike (AIC) mogą być lepsze niż walidacja krzyżowa, ponieważ są one obliczane szybciej, a ich wydajność jest mniej niestabilna w małych próbkach. Kryterium informacyjne wybiera parametr regularyzacji estymatora, maksymalizując dokładność modelu w próbce, jednocześnie karząc jego efektywną liczbę parametrów/stopni swobody. Zou i in. zaproponował mierzenie efektywnych stopni swobody poprzez zliczenie liczby parametrów, które odbiegają od zera. Podejście stopni swobody zostało uznane za wadliwe przez Kaufmana i Rosseta oraz Jansona i innych, ponieważ stopnie swobody modelu mogą wzrosnąć, nawet jeśli jest to bardziej karane przez parametr regularyzacji. Alternatywnie, do zliczenia efektywnej liczby parametrów można zastosować względną miarę prostoty zdefiniowaną powyżej. Dla lassa miara ta jest podawana przez

- ,

który monotonicznie wzrasta od zera do gdy parametr regularyzacji maleje od do zera.

Wybrane aplikacje

LASSO zostało zastosowane w ekonomii i finansach i okazało się, że poprawia prognozowanie i wybiera czasami pomijane zmienne, na przykład w literaturze dotyczącej prognozowania upadłości przedsiębiorstw lub prognozowania firm wysokiego wzrostu.

![{\displaystyle s\w [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aff1a54fbbee4a2677039524a5139e952fa86eb9)

![{\ Displaystyle {\ zacząć {wyrównany} i \ min _ {\ beta} \ lewo \ {{\ Frac {1} {N}} \ suma _ {i = 1} ^ {N} \ lewo (y_ {i} -x_{i}^{t}\beta \right)^{2}\right\}\\[4pt]&{\text{ z zastrzeżeniem }}\sum _{j=1}^{p}|\ beta _{j}|\leq t_{1}{\text{ i }}\sum _{j=2}^{p}|\beta _{j}-\beta _{j-1}|\leq t_{2}.\end{wyrównany}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a75f99fe3b19232504b470197d1158638ad10255)