tf–idf — tf–idf

W wyszukiwaniu informacji , tfidf , TF * IDF lub TFIDF , skrót terminu częstotliwości odwrotność częstotliwości dokumentu , to statystyka liczbowa, która ma odzwierciedlać, jak ważne jest słowo do dokumentu w kolekcji lub korpusu . Jest często używany jako czynnik ważenia w wyszukiwaniu wyszukiwania informacji, eksploracji tekstu i modelowaniu użytkowników . Wartość tf–idf zwiększa się proporcjonalnie do liczby wystąpień danego słowa w dokumencie i jest równoważona liczbą dokumentów w korpusie zawierających to słowo, co pomaga uwzględnić fakt, że niektóre słowa pojawiają się ogólnie częściej. tf–idf jest obecnie jednym z najpopularniejszych systemów ważenia terminów. Badanie przeprowadzone w 2015 r. wykazało, że 83% tekstowych systemów rekomendujących w bibliotekach cyfrowych korzysta z tf–idf.

Odmiany schematu ważenia tf–idf są często wykorzystywane przez wyszukiwarki jako główne narzędzie do oceniania i oceniania trafności dokumentu na podstawie zapytania użytkownika . tf–idf może być z powodzeniem stosowany do filtrowania stop-słów w różnych polach tematycznych, w tym do podsumowywania i klasyfikacji tekstu .

Jedna z najprostszych funkcji rankingowych jest obliczana przez zsumowanie tf-idf dla każdego terminu zapytania; wiele bardziej wyrafinowanych funkcji rankingowych to warianty tego prostego modelu.

Motywacje

Termin częstotliwość

Załóżmy, że mamy zestaw angielskich dokumentów tekstowych i chcemy je uszeregować według tego, który dokument jest bardziej odpowiedni dla zapytania „brązowa krowa”. Prostym sposobem na rozpoczęcie jest wyeliminowanie dokumentów, które nie zawierają wszystkich trzech słów „the”, „brązowy” i „krowa”, ale nadal pozostaje wiele dokumentów. Aby je dodatkowo rozróżnić, możemy policzyć, ile razy każdy termin występuje w każdym dokumencie; to, ile razy dany termin występuje w dokumencie, nazywa się jego częstotliwością . Jednak w przypadku, gdy długość dokumentów jest bardzo zróżnicowana, często dokonuje się korekt (patrz definicja poniżej). Pierwsza forma ważenia terminów pochodzi od Hansa Petera Luhna (1957), którą można podsumować jako:

Waga terminu występującego w dokumencie jest po prostu proporcjonalna do częstotliwości terminu.

Odwrotna częstotliwość dokumentu

Ponieważ termin „the” jest tak powszechny, częstotliwość terminów będzie błędnie podkreślać dokumenty, w których zdarza się, że słowo „the” jest używane częściej, bez przywiązywania wystarczającej wagi do bardziej znaczących terminów „brązowy” i „krowa”. Termin „the” nie jest dobrym słowem kluczowym do rozróżniania odpowiednich i nieistotnych dokumentów i terminów, w przeciwieństwie do mniej popularnych słów „brązowy” i „krowa”. W związku z tym włączony jest odwrotny współczynnik częstotliwości dokumentu, który zmniejsza wagę terminów, które występują bardzo często w zestawie dokumentów i zwiększa wagę terminów, które występują rzadko.

Karen Spärck Jones (1972) wymyśliła statystyczną interpretację specyficzności terminów zwaną odwrotną częstotliwością dokumentu (idf), która stała się kamieniem węgielnym ważenia terminów:

Specyfikę terminu można określić ilościowo jako odwrotną funkcję liczby dokumentów, w których występuje.

Definicja

- tf–idf jest iloczynem dwóch statystyk: częstotliwości terminu i odwrotnej częstotliwości dokumentu . Istnieją różne sposoby określania dokładnych wartości obu statystyk.

- Formuła mająca na celu określenie ważności słowa kluczowego lub frazy w dokumencie lub na stronie internetowej.

| schemat ważenia | waga tf |

|---|---|

| dwójkowy | |

| surowa liczba | |

| częstotliwość terminu | |

| normalizacja dziennika | |

| podwójna normalizacja 0,5 | |

| podwójna normalizacja K |

Termin częstotliwość

Częstotliwość wyrazu , tf( t , d ) , jest częstotliwością wyrazu t ,

- ,

gdzie f t , d jest surową liczbą terminu w dokumencie, tj. ile razy termin t występuje w dokumencie d . Istnieje wiele innych sposobów definiowania terminu częstotliwość:

- Ilość surowego sama: tf ( t , d ) = f t , d

- „Częstotliwości” logiczne : tf( t , d ) = 1 jeśli t występuje w d i 0 w przeciwnym wypadku;

- Określenie częstotliwości dostosowana do długości dokument: tf ( t , d ) = f t , d ÷ (liczba słów d)

- logarytmicznie skalowania częstotliwości: tf ( t , d ) = log (1 + f t , d ) ;

- zwiększona częstotliwość, aby zapobiec przesunięciu w kierunku dłuższych dokumentów, np. surowa częstotliwość podzielona przez surową częstotliwość najczęściej występującego terminu w dokumencie:

Odwrotna częstotliwość dokumentu

| schemat ważenia | waga idf ( ) |

|---|---|

| jednoargumentowy | 1 |

| odwrotna częstotliwość dokumentu | |

| odwrócona częstotliwość dokumentu gładka | |

| odwrócona częstotliwość dokumentu maks. | |

| probabilistyczna odwrotna częstotliwość dokumentów |

Częstotliwość dokumentu odwrotność jest miarą tego, jak wiele informacji słowo zapewnia, to znaczy czy jest to powszechne lub rzadkie we wszystkich dokumentach. Jest to logarytmicznie przeskalowany ułamek odwrotny dokumentów zawierających to słowo (otrzymany przez podzielenie całkowitej liczby dokumentów przez liczbę dokumentów zawierających termin, a następnie logarytmowanie tego ilorazu):

z

- : całkowita liczba dokumentów w korpusie

- : liczba dokumentów, w których pojawia się termin (np . ). Jeśli terminu nie ma w korpusie, doprowadzi to do dzielenia przez zero. Dlatego często dopasowuje się mianownik do .

Termin częstotliwość – odwrotna częstotliwość dokumentu

Wtedy tf–idf oblicza się jako

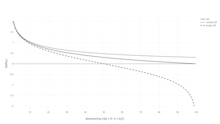

Wysoką wagę w tf–idf osiąga wysoka częstotliwość terminowa (w danym dokumencie) i niska częstotliwość dokumentacyjna terminu w całym zbiorze dokumentów; wagi mają zatem tendencję do odfiltrowywania wspólnych terminów. Ponieważ stosunek wewnątrz funkcji logarytmicznej idf jest zawsze większy lub równy 1, wartość idf (i tf–idf) jest większa lub równa 0. Gdy termin pojawia się w większej liczbie dokumentów, stosunek wewnątrz logarytmu zbliża się do 1 , zbliżając idf i tf–idf do 0.

| schemat ważenia | waga terminu dokumentu | waga terminu zapytania |

|---|---|---|

| 1 | ||

| 2 | ||

| 3 |

Uzasadnienie idf

Idf zostało wprowadzone jako „specyficzność terminów” przez Karen Spärck Jones w artykule z 1972 roku. Chociaż sprawdziła się dobrze jako heurystyka , jej teoretyczne podstawy były kłopotliwe przez co najmniej trzy dekady później, a wielu badaczy próbowało znaleźć dla niej teoretyczne uzasadnienie informacji .

Własne wyjaśnienie Spärcka Jonesa nie proponowało wiele teorii, poza powiązaniem z prawem Zipfa . Próbowano oprzeć idf na podstawie probabilistycznej , szacując prawdopodobieństwo, że dany dokument d zawiera wyraz t jako względną częstotliwość dokumentu,

tak, że możemy zdefiniować idf jako

Mianowicie, odwrotna częstotliwość dokumentu jest logarytmem „odwrotnej” względnej częstotliwości dokumentu.

Ta probabilistyczna interpretacja z kolei przybiera taką samą formę jak samoinformacja . Jednak zastosowanie takich pojęć informacyjno-teoretycznych do problemów związanych z wyszukiwaniem informacji prowadzi do problemów przy próbie zdefiniowania odpowiednich przestrzeni zdarzeń dla wymaganych rozkładów prawdopodobieństwa : należy wziąć pod uwagę nie tylko dokumenty, ale także zapytania i terminy.

Powiązanie z teorią informacji

Termin Częstotliwość i Odwrotna Częstotliwość Dokumentu mogą być sformułowane przy użyciu teorii informacji ; pomaga zrozumieć, dlaczego ich produkt ma znaczenie w zakresie wspólnej treści informacyjnej dokumentu. Charakterystycznym założeniem dotyczącym rozkładu jest to, że:

To założenie i jego implikacje, według Aizawy: „reprezentują heurystykę, którą stosuje tf-idf”.

Przypomnijmy wyrażenie warunkowej entropii „losowo wybranego” dokumentu w korpusie, uwarunkowane tym, że zawiera on określony termin (i załóżmy, że wszystkie dokumenty mają jednakowe prawdopodobieństwo wyboru i małą istotę r=prawdopodobieństwa)):

Pod względem notacji, i są „zmiennymi losowymi” odpowiadające odpowiednio narysować dokument lub terminu. Teraz przypomnij sobie definicję informacji wzajemnej i zauważ, że można ją wyrazić jako

Ostatnim krokiem jest rozwinięcie bezwarunkowego prawdopodobieństwa narysowania terminu w odniesieniu do (przypadkowego) wyboru dokumentu, aby uzyskać:

Wyrażenie to pokazuje, że zsumowanie Tf–idf wszystkich możliwych terminów i dokumentów pozwala na odzyskanie wzajemnej informacji między dokumentami i terminem z uwzględnieniem wszystkich specyfiki ich wspólnego rozmieszczenia. Każdy Tf–idf niesie zatem „bit informacji” dołączony do pary dokumentów termin x.

Przykład tf–idf

Załóżmy, że mamy tabele liczby terminów w korpusie składającym się tylko z dwóch dokumentów, wymienionych po prawej stronie.

| Semestr | Liczba terminów |

|---|---|

| ten | 1 |

| jest | 1 |

| inne | 2 |

| przykład | 3 |

| Semestr | Liczba terminów |

|---|---|

| ten | 1 |

| jest | 1 |

| a | 2 |

| próbka | 1 |

Obliczenie tf–idf dla terminu „to” wykonuje się w następujący sposób:

W swojej surowej formie częstotliwości tf jest po prostu częstotliwością „tego” dla każdego dokumentu. W każdym dokumencie słowo „to” pojawia się raz; ale ponieważ dokument 2 zawiera więcej słów, jego względna częstotliwość jest mniejsza.

Identyfikator idf jest stały na korpus i uwzględnia stosunek dokumentów zawierających słowo „to”. W tym przypadku mamy do czynienia z korpusem dwóch dokumentów i wszystkie zawierają słowo „to”.

Tak więc tf–idf to zero dla słowa „to”, co oznacza, że słowo to nie jest zbyt pouczające, ponieważ pojawia się we wszystkich dokumentach.

Bardziej interesujące jest słowo „przykład” – występuje trzy razy, ale tylko w drugim dokumencie:

Wreszcie,

(przy użyciu logarytmu o podstawie 10 ).

Poza warunkami

Idea stojąca za tf-idf dotyczy również podmiotów innych niż terminy. W 1998 roku do cytatów zastosowano koncepcję idf. Autorzy argumentowali, że „jeśli bardzo rzadkie cytowanie występuje w dwóch dokumentach, powinno to mieć większą wagę niż cytowanie z dużej liczby dokumentów”. Ponadto tf–idf zastosowano do „wizualnych słów” w celu dopasowania obiektów w filmach i całych zdaniach. Jednak koncepcja tf–idf nie okazała się skuteczniejsza we wszystkich przypadkach niż zwykły schemat tf (bez idf). Kiedy tf–idf zastosowano do cytowań, naukowcy nie mogli znaleźć żadnej poprawy w stosunku do prostej liczby cytowań, która nie zawierała składnika idf.

Pochodne

Szereg schematów ważenia terminów wywodzi się z tf–idf. Jednym z nich jest TF-PDF (Term Frequency * Proportional Document Frequency). TF–PDF został wprowadzony w 2001 roku w kontekście identyfikacji pojawiających się tematów w mediach. Składnik PDF mierzy różnicę częstotliwości występowania terminu w różnych domenach. Inną pochodną jest TF-IDuF. W TF–IDuF idf nie jest obliczany na podstawie korpusu dokumentu, który ma być przeszukiwany lub zalecany. Zamiast tego idf jest obliczany na podstawie osobistych kolekcji dokumentów użytkowników. Autorzy podają, że TF–IDuF był równie skuteczny jak tf–idf, ale mógł być również stosowany w sytuacjach, gdy np. system modelowania użytkowników nie ma dostępu do globalnego korpusu dokumentów.

Zobacz też

Bibliografia

- Salton, G ; McGill, MJ (1986). Wprowadzenie do nowoczesnego wyszukiwania informacji . McGraw-Hill . Numer ISBN 978-0-07-054484-0.

- Salton, G .; Lis, EA; Wu, H. (1983). „Rozszerzone wyszukiwanie informacji logicznych”. Komunikaty ACM . 26 (11): 1022–1036. doi : 10.1145/182.358466 . hdl : 1813/6351 . S2CID 207180535 .

- Salton, G .; Buckley, C. (1988). „Podejścia do ważenia terminów w automatycznym wyszukiwaniu tekstu” (PDF) . Przetwarzanie i zarządzanie informacjami . 24 (5): 513–523. doi : 10.1016/0306-4573(88)90021-0 . hdl : 1813/6721 .

- Wu, HC; Łukasz, RWP; Wong, KF; Kwok, KL (2008). „Interpretowanie wag terminowych TF-IDF jako podejmowanie decyzji dotyczących istotności” . Transakcje ACM w systemach informatycznych . 26 (3): 1. doi : 10.1145/1361684.1361686 . hdl : 10397/10130 . S2CID 18303048 .

Linki zewnętrzne i sugerowana lektura

- Gensim to biblioteka Pythona do modelowania przestrzeni wektorowych i zawiera ważenie tf–idf.

- Anatomia wyszukiwarki

- tf-idf i powiązane definicje stosowane w Lucene

- TfidfTransformer w scikit-learn

- Text to Matrix Generator (TMG) Zestaw narzędzi MATLAB, który można wykorzystać do różnych zadań w eksploracji tekstu (TM) w szczególności i) indeksowania, ii) wyszukiwania, iii) redukcji wymiarowości, iv) grupowania, v) klasyfikacji. Krok indeksowania oferuje użytkownikowi możliwość zastosowania lokalnych i globalnych metod ważenia, w tym tf–idf.

- Określenie częstotliwości wyjaśnione Objaśnienie określenie częstotliwości