Mapa samoorganizująca się - Self-organizing map

| Część serii na |

|

Uczenie maszynowe i eksploracja danych |

|---|

|

Samoorganizujące map ( SOM ) lub samoorganizujące cechą map ( SOFM ) jest bez nadzoru maszyna nauka technika wykorzystywana do produkcji nisko-wymiarowej (zazwyczaj dwuwymiarowy) reprezentowanie wyższej wymiarowej zbioru danych przy jednoczesnym zachowaniu topologiczną strukturę z następujących dane. Na przykład zestaw danych z p zmiennych mierzonych w n obserwacjach może być reprezentowany jako skupienia obserwacji o podobnych wartościach zmiennych. Skupiska te mogą być następnie wizualizowane jako dwuwymiarowa „mapa”, tak że obserwacje w gromadach proksymalnych mają bardziej podobne wartości niż obserwacje w gromadach dystalnych. Może to ułatwić wizualizację i analizę danych wielowymiarowych.

SOM jest rodzajem sztucznej sieci neuronowej, ale jest szkolony przy użyciu konkurencyjnego uczenia się, a nie uczenia korekcji błędów (np. wstecznej propagacji z gradientem ) stosowanego przez inne sztuczne sieci neuronowe. SOM został wprowadzony przez fińskiego profesora Teuvo Kohonena w latach 80. i dlatego jest czasami nazywany mapą Kohonena lub siecią Kohonena . Mapa lub sieć Kohonena to wygodna obliczeniowo abstrakcja oparta na biologicznych modelach systemów neuronowych z lat 70. i modelach morfogenezy sięgających czasów Alana Turinga w latach 50. XX wieku.

Przegląd

Mapy samoorganizujące się, podobnie jak większość sztucznych sieci neuronowych, działają w dwóch trybach: trenowaniu i mapowaniu. Po pierwsze, uczenie wykorzystuje zestaw danych wejściowych („przestrzeń wejściowa”) w celu wygenerowania reprezentacji danych wejściowych o niższym wymiarze („przestrzeń mapy”). Po drugie, mapowanie klasyfikuje dodatkowe dane wejściowe przy użyciu wygenerowanej mapy.

W większości przypadków celem szkolenia jest przedstawienie przestrzeni wejściowej o wymiarach p jako przestrzeni mapy z dwoma wymiarami. Mówi się, że przestrzeń wejściowa z p zmiennymi ma p wymiarów. Przestrzeń mapy składa się z komponentów zwanych „węzłami” lub „neuronami”, które są ułożone w sześciokątną lub prostokątną siatkę o dwóch wymiarach. Liczba węzłów i ich rozmieszczenie są określone z góry na podstawie większych celów analizy i eksploracji danych .

Każdy węzeł w przestrzeni mapy jest powiązany z wektorem „wagi”, który jest pozycją węzła w przestrzeni wejściowej. Podczas gdy węzły w przestrzeni mapy pozostają stałe, uczenie polega na przesuwaniu wektorów wagi w kierunku danych wejściowych (zmniejszając metrykę odległości, taką jak odległość euklidesowa ) bez psucia topologii indukowanej z przestrzeni mapy. Po nauczeniu mapy można użyć do klasyfikacji dodatkowych obserwacji dla przestrzeni wejściowej poprzez znalezienie węzła o wektorze wag najbliższym (najmniejsza metryka odległości) do wektora przestrzeni wejściowej.

Algorytm uczenia

Celem uczenia się na samoorganizującej się mapie jest spowodowanie, aby różne części sieci reagowały podobnie na pewne wzorce wejściowe. Jest to częściowo motywowane sposobem, w jaki informacje wizualne, słuchowe lub inne sensoryczne są obsługiwane w oddzielnych częściach kory mózgowej w ludzkim mózgu .

Wagi neuronów są inicjowane albo do małych wartości losowych, albo są pobierane równomiernie z podprzestrzeni rozpiętej przez dwa największe wektory własne głównych składowych . W przypadku drugiej alternatywy nauka jest znacznie szybsza, ponieważ początkowe wagi już dają dobre przybliżenie wag SOM.

Sieć musi być zasilana dużą liczbą przykładowych wektorów, które reprezentują, tak blisko, jak to możliwe, rodzaje wektorów oczekiwane podczas mapowania. Przykłady są zwykle podawane kilka razy jako iteracje.

Szkolenie wykorzystuje konkurencyjne uczenie się . Gdy przykład uczący jest wprowadzany do sieci, obliczana jest jego odległość euklidesowa do wszystkich wektorów wag. Neuron, którego wektor wag jest najbardziej podobny do wejścia, nazywany jest najlepiej dopasowaną jednostką (BMU). Wagi BMU i bliskich mu neuronów w siatce SOM są dostosowywane do wektora wejściowego. Wielkość zmiany zmniejsza się wraz z upływem czasu i odległością od sieci BMU. Wzór aktualizacyjny dla neuronu v z wektorem wagowym W v (s) to

- ,

gdzie s jest indeksem kroku, t indeksem próbki uczącej , u jest indeksem BMU dla wektora wejściowego D (t), α(s) jest monotonicznie malejącym współczynnikiem uczenia; Θ(u, v, s) to funkcja sąsiedztwa określająca odległość między neuronem u a neuronem v w kroku s. W zależności od implementacji, t może systematycznie skanować zestaw danych uczących (t wynosi 0, 1, 2...T-1, a następnie powtórzyć, T jest rozmiarem próbki uczącej), być losowo pobierany ze zbioru danych ( próbkowanie początkowe ) lub zaimplementuj inną metodę próbkowania (np. scyzoryk ).

Funkcja sąsiedztwa Θ(u, v, s) (zwana również funkcją interakcji bocznej ) zależy od odległości siatki pomiędzy BMU (neuron u ) a neuronem v . W najprostszej postaci jest to 1 dla wszystkich neuronów wystarczająco blisko BMU i 0 dla innych, ale często wybierane są również funkcje gaussowskie i meksykańskie . Niezależnie od formy funkcjonalnej funkcja sąsiedztwa z czasem kurczy się. Na początku, gdy sąsiedztwo jest szerokie, samoorganizacja odbywa się w skali globalnej. Gdy sąsiedztwo skurczyło się do zaledwie kilku neuronów, wagi zbliżają się do lokalnych szacunków. W niektórych implementacjach współczynnik uczenia α i funkcja sąsiedztwa Θ stale maleją wraz ze wzrostem s, w innych (w szczególności tych, w których t skanuje zestaw danych treningowych) zmniejszają się stopniowo, raz na T kroków.

Proces ten jest powtarzany dla każdego wektora wejściowego przez (zwykle dużą) liczbę cykli λ . Sieć kończy się, kojarząc węzły wyjściowe z grupami lub wzorcami w zestawie danych wejściowych. Jeśli te wzorce można nazwać, nazwy mogą być dołączone do powiązanych węzłów w wyuczonej sieci.

Podczas mapowania będzie jeden wygrywający neuron: neuron, którego wektor wagowy leży najbliżej wektora wejściowego. Można to po prostu określić, obliczając odległość euklidesową między wektorem wejściowym a wektorem wagowym.

Podczas gdy w niniejszym artykule podkreślono, że dane wejściowe są przedstawiane jako wektory, każdy rodzaj obiektu, który może być reprezentowany cyfrowo, który ma skojarzoną z nim odpowiednią miarę odległości i w którym możliwe są operacje niezbędne do uczenia, może być użyty do skonstruowania siebie. -organizacja mapy. Obejmuje to macierze, funkcje ciągłe, a nawet inne mapy samoorganizujące się.

Zmienne

To są potrzebne zmienne, z wektorami pogrubionymi,

- jest aktualna iteracja

- jest limit iteracji

- jest indeksem docelowego wektora danych wejściowych w zbiorze danych wejściowych

- jest docelowym wektorem danych wejściowych

- jest indeksem węzła na mapie

- jest aktualnym wektorem wagi węzła

- to indeks najlepiej dopasowanej jednostki (BMU) na mapie

- jest ograniczeniem ze względu na odległość od BMU, zwykle nazywaną funkcją sąsiedztwa, oraz

- jest ograniczeniem w nauce ze względu na postęp iteracji.

Algorytm

- Losuj wektory wagi węzłów na mapie

- Losowo wybierz wektor wejściowy

- Przejdź przez każdy węzeł na mapie

- Użyj wzoru na odległość euklidesową, aby znaleźć podobieństwo między wektorem wejściowym a wektorem wagi węzła mapy

- Śledź węzeł, który generuje najmniejszą odległość (ten węzeł jest najlepiej dopasowaną jednostką, BMU)

- Zaktualizuj wektory wag węzłów w sąsiedztwie BMU (w tym samego BMU), przyciągając je bliżej wektora wejściowego

- Zwiększ i powtórz od kroku 2, dopóki

Algorytm alternatywny

- Losuj wektory wagi węzłów mapy

- Przemierz każdy wektor wejściowy w zbiorze danych wejściowych

- Przejdź przez każdy węzeł na mapie

- Użyj wzoru na odległość euklidesową, aby znaleźć podobieństwo między wektorem wejściowym a wektorem wagi węzła mapy

- Śledź węzeł, który generuje najmniejszą odległość (ten węzeł jest najlepiej dopasowaną jednostką, BMU)

- Zaktualizuj węzły w sąsiedztwie BMU (w tym samego BMU), przyciągając je bliżej wektora wejściowego

- Przejdź przez każdy węzeł na mapie

- Zwiększ i powtórz od kroku 2, dopóki

Opcje inicjalizacji

Wybór wag początkowych jako dobrych przybliżeń wag końcowych jest dobrze znanym problemem dla wszystkich iteracyjnych metod sztucznych sieci neuronowych, w tym map samoorganizujących się. Kohonen pierwotnie zaproponował losową inicjację wag. (To podejście znajduje odzwierciedlenie w algorytmach opisanych powyżej). Ostatnio inicjalizacja głównych składowych, w której początkowe wagi mapy są wybierane z przestrzeni pierwszych głównych składowych, stała się popularna ze względu na dokładną odtwarzalność wyników.

Uważne porównanie inicjacji losowej z inicjalizacją głównego składnika dla mapy jednowymiarowej wykazało jednak, że zalety inicjalizacji głównego składnika nie są uniwersalne. Najlepsza metoda inicjalizacji zależy od geometrii określonego zestawu danych. Inicjalizacja głównego składnika była preferowana (dla mapy jednowymiarowej), gdy główna krzywa aproksymująca zbiór danych mogła być jednowartościowo i liniowo rzutowana na pierwszy główny składnik (zestawy quasilinearne). Jednak w przypadku nieliniowych zestawów danych inicjacja losowa działała lepiej.

Interpretacja

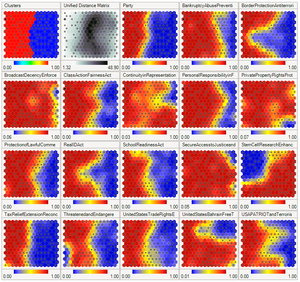

Istnieją dwa sposoby interpretacji SOM. Ponieważ w fazie treningu wagi całego sąsiedztwa przesuwają się w tym samym kierunku, podobne elementy mają tendencję do pobudzania sąsiednich neuronów. Dlatego SOM tworzy mapę semantyczną, na której podobne próbki są mapowane blisko siebie, a różne od siebie. Można to zobrazować za pomocą macierzy U (odległości euklidesowej między wektorami wag sąsiednich komórek) SOM.

Innym sposobem jest myślenie o wagach neuronalnych jako wskaźnikach do przestrzeni wejściowej. Tworzą dyskretne przybliżenie rozkładu próbek uczących. Więcej neuronów wskazuje na regiony o wysokim stężeniu próbek treningowych, a mniej na obszary, w których próbki są rzadkie.

SOM można uznać za nieliniowe uogólnienie analizy głównych składowych (PCA). Wykazano, wykorzystując zarówno sztuczne, jak i rzeczywiste dane geofizyczne, że SOM ma wiele zalet w porównaniu z konwencjonalnymi metodami ekstrakcji cech , takimi jak empiryczne funkcje ortogonalne (EOF) czy PCA.

Pierwotnie SOM nie był formułowany jako rozwiązanie problemu optymalizacji. Mimo to podjęto kilka prób modyfikacji definicji SOM i sformułowania problemu optymalizacyjnego, który daje podobne wyniki. Na przykład mapy sprężystości wykorzystują mechaniczną metaforę elastyczności do przybliżania głównych rozmaitości : analogią jest elastyczna membrana i płyta.

Przykłady

Dane kwiatu tęczówki Fishera

Rozważmy tablicę węzłów n × m , z których każdy zawiera wektor wagi i jest świadomy swojego położenia w tablicy. Każdy wektor wagi ma taki sam wymiar jak wektor wejściowy węzła. Wagi mogą być początkowo ustawione na wartości losowe.

Teraz potrzebujemy danych wejściowych, aby zasilić mapę. Kolory mogą być reprezentowane przez ich składową czerwoną, zieloną i niebieską. W związku z tym będziemy reprezentować kolory jako wektory w sześcianie jednostkowym przestrzeni swobodnej nad ℝ wygenerowanym przez bazę :

- R = <255, 0, 0>

- G = <0, 255, 0>

- B = <0, 0, 255>

Przedstawiony schemat

porównuje wyniki treningu na zbiorach danych

- trzykolory = [255, 0, 0], [0, 255, 0], [0, 0, 255]

- osiemKolorów = [0, 0, 0], [255, 0, 0], [0, 255, 0], [0, 0, 255], [255, 255, 0], [0, 255, 255], [255, 0, 255], [255, 255, 255]

i oryginalne obrazy. Zwróć uwagę na uderzające podobieństwo między nimi.

Podobnie, po wytrenowaniu siatki neuronów 40×40 dla 250 iteracji z szybkością uczenia 0,1 na tęczówce Fishera , mapa może już wykryć główne różnice między gatunkami.

Inne

- Priorytetyzacja i wybór projektów

- Analiza facji sejsmicznych w poszukiwaniu ropy i gazu

- Analiza przyczyn i skutków awarii

- Tworzenie dzieła sztuki

Alternatywy

- Generatywna mapa topograficzna (GTM) jest potencjalnym alternatywą dla modeli SOM. W tym sensie, że GTM wyraźnie wymaga płynnego i ciągłego mapowania z przestrzeni wejściowej do przestrzeni mapy, zachowuje topologię. Jednak w sensie praktycznym brakuje tej miary zachowania topologicznego.

- Sieć samoorganizującej się mapy czasu adaptacyjnej (TASOM) jest rozszerzeniem podstawowego SOM. TASOM wykorzystuje adaptacyjne tempo uczenia się i funkcje sąsiedzkie. Zawiera również parametr skalowania, dzięki któremu sieć jest niezmienna w stosunku do skalowania, translacji i rotacji przestrzeni wejściowej. TASOM i jego warianty zostały wykorzystane w kilku zastosowaniach, w tym w adaptacyjnym grupowaniu, wielopoziomowym progowaniu, aproksymacji przestrzeni wejściowej i aktywnym modelowaniu konturów. Zaproponowano ponadto drzewo binarne TASOM lub BTASOM, przypominające binarne drzewo naturalne posiadające węzły złożone z sieci TASOM, w którym liczba jego poziomów oraz liczba jego węzłów jest dostosowana do środowiska.

- Rośnie samoorganizujące map (GSOM) jest rosnąca odmiana samoorganizujących mapie. GSOM został opracowany w celu rozwiązania problemu identyfikacji odpowiedniego rozmiaru mapy w SOM. Rozpoczyna się od minimalnej liczby węzłów (zwykle czterech) i powiększa nowe węzły na granicy w oparciu o heurystykę. Używając wartości zwanej współczynnikiem rozproszenia , analityk danych ma możliwość kontrolowania wzrostu GSOM.

- Te elastyczne mapy podejść pożycza od interpolacji spline idei minimalizacji energii sprężystej . W nauce minimalizuje sumę kwadratowej energii zginania i rozciągania z najmniejszym błędem aproksymacji kwadratów .

- Podejście konforemne, które wykorzystuje mapowanie konforemne do interpolacji każdej próbki treningowej między węzłami siatki na ciągłej powierzchni. W tym podejściu możliwe jest gładkie mapowanie jeden do jednego.

- Zorientowane i skalowalna mapa (OS-Map) upowszechnia funkcji sąsiedztwa i wybór zwycięzcy. Jednorodna funkcja sąsiedztwa Gaussa zostaje zastąpiona wykładniczą macierzą. W ten sposób można określić orientację w przestrzeni mapy lub w przestrzeni danych. SOM ma ustaloną skalę (=1), dzięki czemu mapy „optymalnie opisują dziedzinę obserwacji”. Ale co z mapą obejmującą domenę dwukrotnie lub w n-fałdach? Wiąże się to z koncepcją skalowania. OS-Map traktuje skalę jako statystyczny opis liczby najlepiej pasujących węzłów danych wejściowych na mapie.

Zobacz też

- Gaz neuronowy

- Nauka kwantyzacji wektorowej

- Maszyna w stanie ciekłym

- Hybrydowy Kohonen SOM

- Rzadkie kodowanie

- Rzadka pamięć rozproszona

- Głęboka nauka

- Neokognitron

- Analiza danych topologicznych