Funkcja Rosenbrocka - Rosenbrock function

W optymalizacji matematycznej The funkcja Rosenbrocka stanowi nie wypukłość funkcji , wprowadzony przez Howard H. ROSENBROCK 1960, który jest wykorzystywany jako błąd testowania wydajności dla optymalizacji algorytmu . Jest również znany jako dolina Rosenbrocka lub funkcja bananowa Rosenbrocka .

Globalne minimum znajduje się w długiej, wąskiej, płaskiej dolinie o parabolicznym kształcie. Znalezienie doliny jest banalne. Jednak zbliżenie się do globalnego minimum jest trudne.

Funkcja jest zdefiniowana przez

Ma globalne minimum w , gdzie . Zwykle te parametry są ustawione tak, że i . Tylko w trywialnym przypadku, gdy funkcja jest symetryczna, a minimum jest na początku.

Wielowymiarowe uogólnienia

Powszechnie spotyka się dwa warianty.

Jeden jest sumą niezwiązanych dwuwymiarowych problemów Rosenbrocka i jest definiowany tylko dla parzystych s:

Ten wariant ma przewidywalnie proste rozwiązania.

Drugi, bardziej zaangażowany wariant to

ma dokładnie jedno minimum dla (at ) i dokładnie dwie minima dla - globalne minimum wszystkich i lokalne minimum blisko . Wynik ten uzyskuje się ustawiając gradient funkcji na zero, zauważając, że otrzymane równanie jest funkcją wymierną . Dla małych wielomiany można dokładnie określić, a twierdzenie Sturma można wykorzystać do określenia liczby rzeczywistych pierwiastków, podczas gdy pierwiastki mogą być ograniczone w obszarze . W przypadku większych ta metoda załamuje się ze względu na wielkość zaangażowanych współczynników.

Punkty stacjonarne

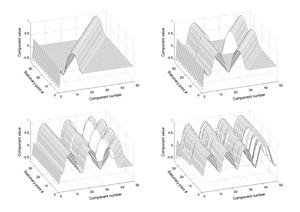

Wiele stacjonarnych punktów funkcji wykazuje na wykresie regularny wzór. Ta struktura może zostać wykorzystana do ich zlokalizowania.

Przykłady optymalizacji

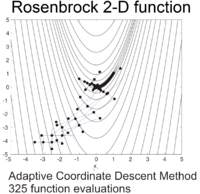

Funkcję Rosenbrocka można efektywnie zoptymalizować, dostosowując odpowiedni układ współrzędnych bez użycia informacji o gradiencie i bez tworzenia lokalnych modeli aproksymacyjnych (w przeciwieństwie do wielu optymalizatorów bez derywatów). Poniższy rysunek ilustruje przykład dwuwymiarowej optymalizacji funkcji Rosenbrocka poprzez adaptacyjne zejście współrzędnych od punktu początkowego . Rozwiązanie z wartością funkcji można znaleźć po 325 ocenach funkcji.

Korzystając z metody Neldera – Meada od punktu początkowego z regularnym początkowym simplexem, po 185 ocenach funkcji znajduje się minimum z wartością funkcji. Poniższy rysunek przedstawia ewolucję algorytmu.

![f ({\ mathbf {x}}) = f (x_ {1}, x_ {2}, \ dots, x_ {N}) = \ sum _ {{i = 1}} ^ {{N / 2}} \ left [100 (x _ {{2i-1}} ^ {2} -x _ {{2i}}) ^ {2} + (x _ {{2i-1}} - 1) ^ {2} \ right].](https://wikimedia.org/api/rest_v1/media/math/render/svg/4793c1eb9633dd26a5b848f5b4c794cba19ccb18)

![{\ displaystyle f (\ mathbf {x}) = \ suma _ {i = 1} ^ {N-1} [100 (x_ {i + 1} -x_ {i} ^ {2}) ^ {2} + (1-x_ {i}) ^ {2}] \ quad {\ mbox {gdzie}} \ quad \ mathbf {x} = (x_ {1}, \ ldots, x_ {N}) \ in \ mathbb {R } ^ {N}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bccb2e1a454191b3392cf24b57256e57d65bf1d6)