Numeryczna prognoza pogody - Numerical weather prediction

Numeryczna prognoza pogody ( NWP ) wykorzystuje matematyczne modele atmosfery i oceanów do przewidywania pogody na podstawie aktualnych warunków pogodowych. Chociaż po raz pierwszy podjęto próbę w latach 20., dopiero wraz z pojawieniem się symulacji komputerowych w latach 50. numeryczne prognozy pogody dały realistyczne wyniki. Wiele globalnych i regionalnych modeli prognostycznych działa w różnych krajach na całym świecie, wykorzystując jako dane wejściowe bieżące obserwacje pogodowe przekazywane z radiosond , satelitów pogodowych i innych systemów obserwacyjnych.

Modele matematyczne oparte na tych samych zasadach fizycznych można wykorzystać do generowania krótkoterminowych prognoz pogody lub długoterminowych prognoz klimatycznych; te ostatnie są szeroko stosowane do zrozumienia i prognozowania zmian klimatycznych . Udoskonalenia wprowadzone w modelach regionalnych pozwoliły na znaczną poprawę prognoz tras cyklonów tropikalnych i jakości powietrza ; jednak modele atmosferyczne słabo radzą sobie z procesami zachodzącymi na stosunkowo ograniczonym obszarze, takimi jak pożary .

Manipulowanie ogromnymi zbiorami danych i wykonywanie skomplikowanych obliczeń niezbędnych do nowoczesnych numerycznych prognoz pogody wymaga jednych z najpotężniejszych superkomputerów na świecie. Nawet przy rosnącej mocy superkomputerów umiejętność prognozowania numerycznych modeli pogodowych trwa tylko około sześciu dni. Czynniki wpływające na dokładność prognoz numerycznych obejmują gęstość i jakość obserwacji wykorzystywanych jako dane wejściowe do prognoz, a także braki w samych modelach numerycznych. Techniki przetwarzania końcowego, takie jak statystyki wyjściowe modelu (MOS), zostały opracowane w celu poprawy obsługi błędów w prognozach numerycznych.

Bardziej fundamentalny problem leży w chaotycznej naturze równań różniczkowych cząstkowych, które rządzą atmosferą. Nie jest możliwe dokładne rozwiązanie tych równań, a małe błędy rosną z czasem (podwajają się co około pięć dni). Obecnie rozumiemy, że to chaotyczne zachowanie ogranicza dokładne prognozy do około 14 dni, nawet przy dokładnych danych wejściowych i bezbłędnym modelu. Ponadto do równań różniczkowych cząstkowych stosowanych w modelu należy dodać parametryzacje dla promieniowania słonecznego , procesów zawilgocenia (chmury i opady ), wymiany ciepła , gleby, roślinności, wód powierzchniowych oraz wpływu ukształtowania terenu. W celu ilościowego określenia dużej ilości nieodłącznej niepewności pozostającej w prognozach numerycznych, od lat 90. XX wieku stosuje się prognozy zbiorcze, aby pomóc ocenić zaufanie do prognozy i uzyskać przydatne wyniki w dalszej przyszłości, niż byłoby to możliwe w inny sposób. To podejście analizuje wiele prognoz utworzonych za pomocą pojedynczego modelu prognozy lub wielu modeli.

Historia

Historia numerycznych prognoz pogody rozpoczęła się w 1920 roku dzięki staraniom Lewis Fry Richardson , który stosowanych procedur pierwotnie opracowane przez Vilhelm Bjerknes do produkcji ręcznie prognozę sześć godzin dla stanu atmosfery nad dwoma punktami w Europie Środkowej, mając na co najmniej sześć tygodni na to. Dopiero wraz z pojawieniem się komputerów i symulacji komputerowych czas obliczeń został skrócony do mniej niż sam okres prognozy. ENIAC został wykorzystany do stworzenia pierwszych prognoz pogody za pośrednictwem komputera w 1950 roku, w oparciu o bardzo uproszczonej zbliżenia do atmosfery równań rządzących. W 1954 r. grupa Carla-Gustava Rossby'ego w Szwedzkim Instytucie Meteorologicznym i Hydrologicznym wykorzystała ten sam model do stworzenia pierwszej prognozy operacyjnej (tj. rutynowej prognozy do praktycznego zastosowania). Operacyjna numeryczna prognoza pogody w Stanach Zjednoczonych rozpoczęła się w 1955 roku w ramach Wspólnej Numerical Weather Prediction Unit (JNWPU), wspólnego projektu US Air Force , Navy and Weather Bureau . W 1956 roku Norman Phillips opracował model matematyczny, który mógł realistycznie przedstawiać miesięczne i sezonowe wzorce w troposferze; stało się to pierwszym udanym modelem klimatycznym . Po pracach Phillipsa kilka grup rozpoczęło pracę nad stworzeniem ogólnych modeli obiegu . Pierwszy ogólny cyrkulacyjny model klimatu, który łączył procesy oceaniczne i atmosferyczne, został opracowany pod koniec lat 60. w Laboratorium Geofizycznej Dynamiki Płynów NOAA .

Wraz ze wzrostem mocy komputerów zwiększył się rozmiar początkowych zestawów danych i opracowano nowsze modele atmosferyczne, aby wykorzystać dostępną moc obliczeniową. Te nowsze modele obejmują więcej procesów fizycznych w uproszczeniu równań ruchu w symulacjach numerycznych atmosfery. W 1966 roku Niemcy Zachodnie i Stany Zjednoczone rozpoczęły tworzenie prognoz operacyjnych w oparciu o modele oparte na pierwotnych równaniach , a następnie Wielka Brytania w 1972 i Australia w 1977. Rozwój modeli o ograniczonym obszarze (regionalnych) umożliwił postęp w prognozowaniu śladów cyklonów tropikalnych jak również jakość powietrza w latach 70. i 80. XX wieku. Na początku lat 80. modele zaczęły uwzględniać interakcje gleby i roślinności z atmosferą, co doprowadziło do bardziej realistycznych prognoz.

Wyniki modeli prognostycznych opartych na dynamice atmosfery nie są w stanie wyjaśnić niektórych szczegółów pogody w pobliżu powierzchni Ziemi. W związku z tym w latach 70. i 80. opracowano statystyczną zależność między wynikami numerycznego modelu pogodowego a wynikającymi z niego warunkami na ziemi, znaną jako statystyka wyników modelu (MOS). Począwszy od lat 90., prognozy zespołowe modeli były wykorzystywane do pomocy w określeniu niepewności prognozy i poszerzeniu okna, w którym numeryczne prognozowanie pogody jest wykonalne dalej w przyszłości, niż byłoby to możliwe w innym przypadku.

Inicjalizacja

Atmosfera jest płyn . Ideą numerycznego przewidywania pogody jest próbkowanie stanu płynu w określonym czasie i wykorzystanie równań dynamiki płynów i termodynamiki do oszacowania stanu płynu w pewnym momencie w przyszłości. Proces wprowadzania danych obserwacyjnych do modelu w celu wygenerowania warunków początkowych nazywa się inicjalizacją . Na lądzie mapy terenu dostępne w rozdzielczości do 1 kilometra (0,6 mil) na całym świecie są wykorzystywane do modelowania cyrkulacji atmosferycznej w regionach o nierównej topografii, aby lepiej przedstawiać takie cechy, jak wiatry opadające, fale górskie i związane z nimi zachmurzenie, które wpływa na przychodzące słońce promieniowanie. Główne dane wejściowe z krajowych służb meteorologicznych to obserwacje z urządzeń (zwanych radiosondami ) w balonach meteorologicznych, które mierzą różne parametry atmosferyczne i przesyłają je do stacjonarnego odbiornika, a także z satelitów pogodowych . Światowa Organizacja Meteorologiczna działa standaryzacja oprzyrządowania, obserwując praktyki i terminy tych obserwacji na całym świecie. Stacje nadają raporty co godzinę w meldunkach METAR lub co sześć godzin w meldunkach SYNOP . Obserwacje te są rozmieszczone w nieregularnych odstępach, dlatego są przetwarzane metodami asymilacji danych i obiektywnej analizy, które przeprowadzają kontrolę jakości i uzyskują wartości w lokalizacjach możliwych do wykorzystania przez algorytmy matematyczne modelu. Dane są następnie wykorzystywane w modelu jako punkt wyjścia do prognozy.

Do zbierania danych obserwacyjnych do wykorzystania w modelach numerycznych stosuje się różne metody. Strony uruchamiają radiosondy w balonach meteorologicznych, które wznoszą się przez troposferę i głęboko w stratosferę . Informacje z satelitów pogodowych są wykorzystywane tam, gdzie tradycyjne źródła danych nie są dostępne. Commerce dostarcza raporty pilotażowe na trasach samolotów i raporty statków na trasach żeglugowych. Projekty badawcze wykorzystują samoloty zwiadowcze do latania w interesujących systemach pogodowych i wokół nich, takich jak cyklony tropikalne . Samoloty zwiadowcze są również przelatywane nad otwartymi oceanami w zimnych porach roku do systemów, które powodują znaczną niepewność w prowadzeniu prognoz lub oczekuje się, że będą miały duży wpływ za trzy do siedmiu dni w przyszłości nad kontynentem w dolnym biegu. Lód morski zaczęto inicjować w modelach prognostycznych w 1971 roku. Wysiłki mające na celu włączenie temperatury powierzchni morza do inicjalizacji modelu rozpoczęto w 1972 roku ze względu na jego rolę w modulowaniu pogody na wyższych szerokościach geograficznych Pacyfiku.

Obliczenie

Model atmosfery to program komputerowy, który generuje informacje meteorologiczne dla przyszłych czasów w określonych lokalizacjach i wysokościach. W każdym nowoczesnym modelu znajduje się zestaw równań, znanych jako równania pierwotne , używanych do przewidywania przyszłego stanu atmosfery. Równania te — wraz z prawem gazu doskonałego — służą do ewolucji pól skalarnych gęstości , ciśnienia i potencjalnej temperatury oraz pola wektorowego prędkości powietrza (wiatr) atmosfery w czasie. Dodatkowe równania transportu dla zanieczyszczeń i innych aerozoli są również zawarte w niektórych modelach o wysokiej rozdzielczości opartych na prymitywnych równaniach. Stosowane równania są nieliniowymi równaniami różniczkowymi cząstkowymi, których nie można rozwiązać dokładnie metodami analitycznymi, z wyjątkiem kilku wyidealizowanych przypadków. Dlatego metody numeryczne uzyskują przybliżone rozwiązania. Różne modele wykorzystują różne metody rozwiązań: niektóre modele globalne i prawie wszystkie modele regionalne wykorzystują metody różnic skończonych dla wszystkich trzech wymiarów przestrzennych, podczas gdy inne modele globalne i kilka modeli regionalnych wykorzystują metody spektralne dla wymiarów poziomych i metody różnic skończonych w pionie.

Równania te są inicjowane na podstawie danych analitycznych i określane są szybkości zmian. Te szybkości zmian przewidują stan atmosfery w niedługim czasie w przyszłości; przyrost czasu dla tej prognozy nazywa się krokiem czasowym . Ten przyszły stan atmosfery jest następnie wykorzystywany jako punkt wyjścia do kolejnego zastosowania równań prognostycznych w celu znalezienia nowych szybkości zmian, a te nowe szybkości zmian przewidują atmosferę w jeszcze kolejnym kroku w przyszłość. Ten krok czasowy jest powtarzany, aż rozwiązanie osiągnie żądany czas prognozy. Długość kroku czasowego wybranego w modelu jest powiązana z odległością między punktami na siatce obliczeniowej i jest wybierana w celu zachowania stabilności numerycznej . Kroki czasowe dla modeli globalnych są rzędu kilkudziesięciu minut, podczas gdy kroki czasowe dla modeli regionalnych wynoszą od jednej do czterech minut. Modele globalne są uruchamiane w różnych okresach w przyszłości. UKMET jednolity model prowadzony jest przez sześć dni w przyszłość, podczas gdy Europejskie Centrum Średnioterminowych prognozach pogody „ Zintegrowanego Systemu Prognoz i Środowisko Kanada ” s Globalnego Środowiska Wieloskalowe model zarówno zabrakło do dziesięciu dni w przyszłość, a Global Forecast System model prowadzony przez Centrum Modelowania Środowiskowego jest uruchamiany szesnaście dni w przyszłość. Wizualny wynik generowany przez rozwiązanie modelowe jest znany jako wykres prognostyczny lub prog .

Parametryzacja

Niektóre procesy meteorologiczne mają zbyt małą skalę lub są zbyt złożone, aby można je było jednoznacznie uwzględnić w numerycznych modelach prognozowania pogody. Parametryzacja to procedura reprezentowania tych procesów przez powiązanie ich ze zmiennymi na skalach, które rozwiązuje model. Na przykład kratki w modelach pogody i klimatu mają boki o długości od 5 km (3 mil) do 300 km (200 mil). Typowa chmura cumulus ma skalę mniejszą niż 1 kilometr (0,6 mi) i wymagałaby siatki jeszcze drobniejszej niż ta, aby była fizycznie reprezentowana przez równania ruchu płynu. Dlatego procesy, które reprezentują takie chmury, są parametryzowane przez procesy o różnym stopniu zaawansowania. W najwcześniejszych modelach, jeśli kolumna powietrza w siatce modelu była warunkowo niestabilna (zasadniczo spód był cieplejszy i wilgotniejszy niż góra), a zawartość pary wodnej w dowolnym punkcie kolumny uległa nasyceniu, to zostałaby przewrócona ( ciepłe, wilgotne powietrze zaczęłoby się unosić), a powietrze w tej pionowej kolumnie mieszało się. Bardziej wyrafinowane schematy zakładają, że tylko niektóre części pudełka mogą konwekcji i że zachodzą porywanie i inne procesy. Modele pogodowe, które mają gridboxy o rozmiarach od 5 do 25 kilometrów (3 do 16 mil) mogą wyraźnie reprezentować chmury konwekcyjne, chociaż muszą sparametryzować mikrofizykę chmur, która występuje na mniejszą skalę. Tworzenie się chmur wielkoskalowych ( typu stratus ) jest bardziej oparte na fizyce; tworzą się, gdy wilgotność względna osiąga określoną wartość. Należy wziąć pod uwagę procesy w skali podsieci. Zamiast zakładać, że chmury tworzą się przy 100% wilgotności względnej, ułamek chmur może być powiązany z krytyczną wartością wilgotności względnej mniejszą niż 100%, odzwierciedlając zmienność skali podrzędnej, która występuje w świecie rzeczywistym.

Ilość promieniowania słonecznego docierającego do ziemi, a także powstawanie kropel chmur zachodzą w skali molekularnej, dlatego muszą zostać sparametryzowane przed włączeniem ich do modelu. Należy również sparametryzować opór atmosferyczny wytwarzany przez góry, ponieważ ograniczenia w rozdzielczości konturów elewacji powodują znaczne niedoszacowanie oporu. Ta metoda parametryzacji jest również wykonywana dla powierzchniowego strumienia energii między oceanem a atmosferą, aby określić realistyczne temperatury powierzchni morza i rodzaj lodu morskiego znajdującego się w pobliżu powierzchni oceanu. Uwzględniany jest kąt słońca oraz wpływ wielu warstw chmur. Rodzaj gleby, rodzaj roślinności i wilgotność gleby określają, ile promieniowania wpływa na ocieplenie i ile wilgoci jest wciągane do otaczającej atmosfery, dlatego ważne jest, aby sparametryzować ich udział w tych procesach. W modelach jakości powietrza parametryzacja uwzględnia emisje atmosferyczne z wielu stosunkowo niewielkich źródeł (np. dróg, pól, fabryk) w ramach określonych skrzynek sieci.

Domeny

Pozioma domena modelu jest albo globalna , obejmująca całą Ziemię, albo regionalna , obejmująca tylko część Ziemi. Modele regionalne (znane również jako modele ograniczonego obszaru lub LAM) pozwalają na użycie drobniejszych odstępów siatki niż modele globalne, ponieważ dostępne zasoby obliczeniowe koncentrują się na określonym obszarze, a nie na całym świecie. Umożliwia to modelom regionalnym rozwiązywanie wyraźnie mniejszych zjawisk meteorologicznych, których nie można przedstawić w bardziej zgrubnej siatce modelu globalnego. Modele regionalne wykorzystują model globalny do określania warunków na krawędzi swojej domeny ( warunki brzegowe ), aby umożliwić systemom spoza domeny modelu regionalnego przemieszczanie się na jej obszar. Niepewność i błędy w modelach regionalnych wprowadza model globalny stosowany dla warunków brzegowych modelu regionalnego, a także błędy przypisywane samemu modelowi regionalnemu.

Układy współrzędnych

Współrzędne poziome

Pozycja pozioma może być wyrażona bezpośrednio we współrzędnych geograficznych ( szerokość i długość geograficzna ) dla modeli globalnych lub w odwzorowaniu mapy współrzędne planarne dla modeli regionalnych. Niemiecka służba meteorologiczna wykorzystuje w swoim globalnym modelu ICON (ikosahedral niehydrostatyczny globalny model cyrkulacji) siatkę opartą na dwudziestościanie foremnym . Podstawowe komórki w tej siatce to trójkąty zamiast czterech komórek narożnych w tradycyjnej siatce szerokości i długości geograficznej. Zaletą jest to, że w odróżnieniu od szerokości i długości geograficznej komórki są wszędzie na kuli ziemskiej tej samej wielkości. Wadą jest to, że równania w tej nieprostokątnej siatce są bardziej skomplikowane.

Współrzędne pionowe

Współrzędna pionowa jest obsługiwana na różne sposoby. W modelu Lewisa Fry Richardsona z 1922 r. jako współrzędną pionową wykorzystano wysokość geometryczną ( ). Późniejsze modele zastąpiły współrzędną geometryczną układem współrzędnych ciśnienia, w którym geopotencjalne wysokości powierzchni o stałym ciśnieniu stają się zmiennymi zależnymi , co znacznie upraszcza równania pierwotne. Ta korelacja między układami współrzędnych może być osiągnięta, ponieważ ciśnienie spada wraz z wysokością przez ziemską atmosferę . Pierwszy model wykorzystany do prognoz operacyjnych, jednowarstwowy model barotropowy, wykorzystywał pojedynczą współrzędną ciśnienia na poziomie 500 milibarów (około 5500 m (18 000 ft)), a zatem był zasadniczo dwuwymiarowy. Modele o wysokiej rozdzielczości — zwane również modelami mezoskalowymi — takie jak model badania pogody i prognozowania zwykle używają znormalizowanych współrzędnych ciśnienia, określanych jako współrzędne sigma . Ten układ współrzędnych otrzymał swoją nazwę od zmiennej niezależnej używanej do skalowania ciśnień atmosferycznych w odniesieniu do ciśnienia na powierzchni, a w niektórych przypadkach również do ciśnienia w górnej części domeny.

Statystyki wyjściowe modelu

Ponieważ modele prognostyczne oparte na równaniach dynamiki atmosfery nie określają idealnie warunków pogodowych, opracowano metody statystyczne w celu skorygowania prognoz. Modele statystyczne stworzono na podstawie trójwymiarowych pól generowanych przez numeryczne modele pogodowe, obserwacje powierzchni i warunki klimatyczne dla określonych lokalizacji. Te modele statystyczne są zbiorczo określane jako statystyka wyników modelu (MOS) i zostały opracowane przez National Weather Service dla zestawu modeli prognozowania pogody pod koniec lat sześćdziesiątych.

Statystyka wyników modelu różni się od doskonałej techniki progowej , która zakłada, że wyniki numerycznych prognoz pogody są doskonałe. MOS może korygować lokalne efekty, których model nie może rozwiązać z powodu niewystarczającej rozdzielczości siatki, a także błędów systematycznych modelu. Ponieważ MOS działa zgodnie z odpowiednim modelem globalnym lub regionalnym, jego produkcja jest znana jako przetwarzanie końcowe. Parametry prognozy w ramach MOS obejmują maksymalne i minimalne temperatury, procentowe prawdopodobieństwo wystąpienia deszczu w ciągu kilku godzin, oczekiwaną ilość opadów, prawdopodobieństwo, że opady zostaną zamrożone w przyrodzie, prawdopodobieństwo wystąpienia burzy, zachmurzenia i wiatrów powierzchniowych.

Zespoły

W 1963 roku Edward Lorenz odkrył chaotyczną naturę z dynamiki płynów równań zaangażowanych w prognozowaniu pogody. Niezwykle małe błędy w temperaturze, wietrze lub innych początkowych danych wejściowych do modeli numerycznych będą się wzmacniać i podwajać co pięć dni, uniemożliwiając prognozom dalekosiężnym — zrobionym z ponad dwutygodniowym wyprzedzeniem — przewidywanie stanu atmosfery z każdy stopień umiejętności prognozowania . Ponadto istniejące sieci obserwacyjne w niektórych regionach mają słaby zasięg (na przykład nad dużymi zbiornikami wodnymi, takimi jak Ocean Spokojny), co wprowadza niepewność w prawdziwy początkowy stan atmosfery. Chociaż zestaw równań, znany jako równania Liouville'a , istnieje w celu określenia początkowej niepewności podczas inicjalizacji modelu, równania są zbyt złożone, aby można je było uruchamiać w czasie rzeczywistym, nawet przy użyciu superkomputerów. Te niepewności ograniczają dokładność modelu prognozy do około pięciu lub sześciu dni w przyszłość.

Edward Epsteina ujęte w 1969, że atmosfera nie może być w pełni opisany w jednym okresie prognozy ze względu na związane z niedokładnością i zaproponowano stosując zespół z stochastyczny symulacji Monte Carlo do wytwarzania środków i wariancji o stan atmosfery. Chociaż ten wczesny przykład zespołu wykazał umiejętności, w 1974 r. Cecil Leith wykazał, że wytwarzali odpowiednie prognozy tylko wtedy, gdy rozkład prawdopodobieństwa zespołu był reprezentatywną próbką rozkładu prawdopodobieństwa w atmosferze.

Od lat dziewięćdziesiątych prognozy zespołowe były wykorzystywane operacyjnie (jako prognozy rutynowe) w celu uwzględnienia stochastycznego charakteru procesów pogodowych – czyli rozwiązania ich nieodłącznej niepewności. Metoda ta polega na analizie wielu prognoz tworzonych za pomocą indywidualnego modelu prognozy przy użyciu różnych parametryzacji fizycznych lub różnych warunków początkowych. Począwszy od 1992 r. z prognozami zespołowymi przygotowanymi przez Europejskie Centrum Prognoz Średnioterminowych (ECMWF) i Krajowe Centra Prognozowania Środowiska , do określenia niepewności prognozy i rozszerzenia okna, w którym można przeprowadzić numeryczne prognozy pogody, wykorzystano prognozy zespołowe. jest opłacalny w dalszej przyszłości, niż byłoby to możliwe w inny sposób. Model ECMWF, Ensemble Prediction System, wykorzystuje pojedyncze wektory do symulacji początkowej gęstości prawdopodobieństwa , podczas gdy zespół NCEP, Global Ensemble Forecasting System, wykorzystuje technikę znaną jako hodowla wektorów . UK Met Office prowadzi globalne i regionalne prognozy zespołowe, w których zakłócenia warunków początkowych są wytwarzane przy użyciu filtra Kalmana . W Globalnym i Regionalnym Systemie Przewidywania Zespołów Met Office (MOGREPS) jest 24 członków.

W podejściu opartym na pojedynczym modelu prognoza zespołowa jest zwykle oceniana pod kątem średniej z indywidualnych prognoz dotyczących jednej zmiennej prognozowanej, a także stopnia zgodności różnych prognoz w ramach systemu zespołowego, reprezentowanego przez ich łączny rozrzut. Rozprzestrzenianie się zbioru jest diagnozowane za pomocą narzędzi takich jak wykresy spaghetti , które pokazują rozrzut jednej wielkości na wykresach prognostycznych dla określonych przedziałów czasowych w przyszłości. Innym narzędziem, w którym stosuje się rozkład grupowy , jest meteogram , który pokazuje rozrzut w prognozie jednej wielkości dla jednej konkretnej lokalizacji. Często zdarza się, że rozproszenie zbioru jest zbyt małe, aby uwzględnić faktycznie występującą pogodę, co może prowadzić do błędnej diagnozy niepewności modelu przez prognostów; problem ten staje się szczególnie dotkliwy w przypadku prognoz pogody z dziesięciodniowym wyprzedzeniem. Gdy rozrzut zespołowy jest mały, a rozwiązania prognostyczne są spójne w ramach wielu przebiegów modelu, prognostycy dostrzegają większe zaufanie do średniej zespołowej i prognozy w ogóle. Pomimo tego postrzegania, zależność rozrzut-umiejętność jest często słaba lub nieznana, ponieważ korelacje rozrzut-błędy są zwykle mniejsze niż 0,6, a tylko w szczególnych okolicznościach wahają się między 0,6–0,7. Związek między rozproszeniem zbioru a umiejętnością prognozowania różni się znacznie w zależności od takich czynników, jak model prognozy i region, dla którego prognoza jest wykonywana.

W ten sam sposób, w jaki można użyć wielu prognoz z jednego modelu do utworzenia zestawu, wiele modeli można również połączyć w celu uzyskania prognozy zespołowej. Takie podejście nosi nazwę prognozowania zespołowego wielomodelowego i wykazano, że poprawia prognozy w porównaniu z podejściem opartym na jednym modelu. Modele w zespole składającym się z wielu modeli można dostosowywać pod kątem ich różnych błędów systematycznych, co jest procesem znanym jako prognozowanie superzespołu . Ten rodzaj prognozy znacznie zmniejsza błędy w wynikach modelu.

Aplikacje

Modelowanie jakości powietrza

Prognozowanie jakości powietrza próbuje przewidzieć, kiedy stężenia zanieczyszczeń osiągną poziomy niebezpieczne dla zdrowia publicznego. Stężenie zanieczyszczeń w atmosferze determinowane jest ich transportem , czyli średnią prędkością poruszania się w atmosferze, ich dyfuzją , przemianą chemiczną i depozycją gruntową . Oprócz informacji o źródle zanieczyszczeń i terenie, modele te wymagają danych o stanie przepływu płynu w atmosferze w celu określenia jego transportu i dyfuzji. Warunki meteorologiczne, takie jak inwersje termiczne, mogą zapobiegać podnoszeniu się powietrza na powierzchni, zatrzymując zanieczyszczenia w pobliżu powierzchni, co sprawia, że dokładne prognozy takich zdarzeń mają kluczowe znaczenie dla modelowania jakości powietrza. Modele jakości powietrza w miastach wymagają bardzo dokładnej siatki obliczeniowej, wymagającej użycia mezoskalowych modeli pogodowych o wysokiej rozdzielczości; pomimo tego jakość numerycznych wskazówek pogodowych jest główną niepewnością w prognozach jakości powietrza.

Modelowanie klimatu

Ogólny model cyrkulacji (GCM) to model matematyczny, który można wykorzystać w symulacjach komputerowych globalnej cyrkulacji atmosfery planety lub oceanu. Ogólny model cyrkulacji atmosferycznej (AGCM) jest zasadniczo taki sam jak globalny numeryczny model prognozowania pogody, a niektóre (takie jak ten stosowany w brytyjskim modelu ujednoliconym) można skonfigurować zarówno dla krótkoterminowych prognoz pogody, jak i długoterminowych prognoz klimatycznych . Wraz z lodem morskim i komponentami powierzchni lądu, AGCM i oceaniczne GCM (OGCM) są kluczowymi komponentami globalnych modeli klimatycznych i są szeroko stosowane do zrozumienia klimatu i prognozowania zmian klimatycznych . Jeśli chodzi o aspekty zmiany klimatu, do modeli klimatycznych można wprowadzić szereg scenariuszy emisji substancji chemicznych, aby zobaczyć, jak zwiększony efekt cieplarniany zmodyfikuje klimat Ziemi. Wersje przeznaczone do zastosowań klimatycznych ze skalą czasową od dziesięcioleci do stuleci zostały pierwotnie stworzone w 1969 roku przez Syukuro Manabe i Kirka Bryana w Geophysical Fluid Dynamics Laboratory w Princeton, New Jersey . W przypadku uruchamiania przez wiele dziesięcioleci ograniczenia obliczeniowe oznaczają, że modele muszą wykorzystywać zgrubną siatkę, która pozostawia nierozwiązane interakcje w mniejszej skali.

Modelowanie powierzchni oceanu

Transfer energii pomiędzy wiatrem wiejącym nad powierzchnią oceanu a górną warstwą oceanu jest ważnym elementem dynamiki fal. Widmowa równanie transportu fali jest używany do określenia zmiany w widmie fali na zmianę topografii. Symuluje generowanie fal, ruch fal (propagację w płynie), narastanie fal , załamanie , przenoszenie energii między falami i rozpraszanie fal. Ponieważ wiatry powierzchniowe są głównym mechanizmem wymuszającym w równaniu transportu fal spektralnych, modele fal oceanicznych wykorzystują informacje generowane przez numeryczne modele prognozowania pogody jako dane wejściowe do określenia, ile energii jest przekazywane z atmosfery do warstwy na powierzchni oceanu. Wraz z rozpraszaniem energii poprzez białe czapki i rezonans pomiędzy falami, wiatry powierzchniowe z numerycznych modeli pogodowych pozwalają na dokładniejsze przewidywanie stanu powierzchni morza.

Prognozowanie cyklonu tropikalnego

Prognozowanie cyklonu tropikalnego również opiera się na danych dostarczanych przez numeryczne modele pogodowe. Istnieją trzy główne klasy modeli naprowadzania cyklonów tropikalnych : Modele statystyczne opierają się na analizie zachowania burzy przy użyciu klimatologii i korelują pozycję burzy oraz datę w celu uzyskania prognozy, która nie jest oparta na fizyce atmosfery w danym czasie. Modele dynamiczne to modele numeryczne, które rozwiązują rządzące równaniami przepływu płynu w atmosferze; opierają się na tych samych zasadach, co inne modele numerycznej prognozy pogody o ograniczonym obszarze, ale mogą obejmować specjalne techniki obliczeniowe, takie jak udoskonalone domeny przestrzenne, które poruszają się wraz z cyklonem. Modele wykorzystujące elementy obu podejść nazywane są modelami statystyczno-dynamicznymi.

W 1978 r. zaczął działać pierwszy model śledzenia huraganów oparty na dynamice atmosfery — model ruchomej drobnej siatki (MFM). W dziedzinie prognozowania śladów cyklonów tropikalnych , pomimo coraz lepszych wskazówek dotyczących modeli dynamicznych, które pojawiały się wraz ze wzrostem mocy obliczeniowej, dopiero w latach 80. numeryczne prognozy pogody wykazały się umiejętnością , a do lat 90., gdy konsekwentnie przewyższały statystyczne lub proste modele dynamiczne . Prognozy intensywności cyklonu tropikalnego oparte na numerycznej prognozie pogody nadal stanowią wyzwanie, ponieważ metody statystyczne nadal wykazują wyższe umiejętności w porównaniu z dynamicznym prowadzeniem.

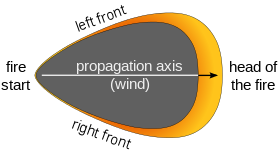

Modelowanie pożaru

W skali molekularnej istnieją dwa główne konkurujące ze sobą procesy reakcji związane z degradacją celulozy lub paliw drzewnych podczas pożarów . Gdy we włóknie celulozowym występuje niewielka ilość wilgoci, następuje ulatnianie się paliwa; proces ten będzie generował pośrednie produkty gazowe, które ostatecznie staną się źródłem spalania . Gdy występuje wilgoć lub gdy z włókna odprowadzana jest wystarczająca ilość ciepła, następuje zwęglenie . W kinetyki chemicznej obu reakcji wskazują, że istnieje punkt, w których poziom wilgoci jest wystarczająco niska, i / lub szybkość ogrzewania na tyle wysoka, do procesów spalania, do samodzielnego życia. W związku z tym, zmiany prędkości wiatru, kierunek, wilgoci, temperatury i szybkości upływ na różnych poziomach w atmosferze może mieć znaczący wpływ na zachowanie i wzrostu pożar. Ponieważ pożar działa jak źródło ciepła dla przepływu atmosferycznego, pożar może modyfikować lokalne wzorce adwekcji , wprowadzając pętlę sprzężenia zwrotnego między ogniem a atmosferą.

Uproszczona dwuwymiarowy model rozprzestrzeniania się pożarów, które używane konwekcji do reprezentowania działanie wiatru i terenu, jak również promieniowanie, jako głównego środka transportu ciepła doprowadziło do układów reakcyjnych dyfuzji z równań różniczkowych . Bardziej złożone modele łączą numeryczne modele pogodowe lub modele obliczeniowej dynamiki płynów z komponentem pożaru, który umożliwia oszacowanie efektów sprzężenia zwrotnego między ogniem a atmosferą. Dodatkowa złożoność w drugiej klasie modeli przekłada się na odpowiedni wzrost zapotrzebowania na moc komputera. W rzeczywistości pełna trójwymiarowa obróbka spalania poprzez bezpośrednią symulację numeryczną w skalach istotnych dla modelowania atmosfery nie jest obecnie praktyczna z powodu nadmiernych kosztów obliczeniowych, których wymagałaby taka symulacja. Numeryczne modele pogodowe mają ograniczone umiejętności prognozowania w rozdzielczościach przestrzennych poniżej 1 kilometra (0,6 mil), zmuszając złożone modele pożarów do parametryzacji pożaru w celu obliczenia, w jaki sposób wiatry zostaną zmodyfikowane lokalnie przez pożar, oraz do wykorzystania tych zmodyfikowanych wiatrów do określenia szybkość, z jaką pożar będzie się rozprzestrzeniał lokalnie. Chociaż modele takie jak FIRETEC Los Alamos rozwiązują stężenia paliwa i tlenu , siatka obliczeniowa nie może być wystarczająco dokładna, aby rozwiązać reakcję spalania, dlatego należy dokonać przybliżeń dla rozkładu temperatury w każdej komórce siatki, a także dla spalania. same szybkości reakcji.

Zobacz też

- Fizyka atmosfery

- Termodynamika atmosfery

- Model prognozy cyklonu tropikalnego

- Rodzaje modeli atmosferycznych

Bibliografia

Dalsza lektura

- Benistona, Martina (1998). Od turbulencji do klimatu: numeryczne badania atmosfery z hierarchią modeli . Berlin: Springer. Numer ISBN 978-3-540-63495-9.

- Kalnay, Eugenia (2003). Modelowanie atmosfery, asymilacja i przewidywalność danych . Modelowanie atmosfery . Wydawnictwo Uniwersytetu Cambridge. P. 364. Kod Bibcode : 2002amda.book.....K . Numer ISBN 978-0-521-79629-3.

- Roulstone, Ian i Norbury, John (2013). Invisible in the Storm: rola matematyki w zrozumieniu pogody . Wydawnictwo Uniwersytetu Princeton. Numer ISBN 978-0691152721.

- Thompson, Filip (1961). Numeryczna analiza i prognoza pogody . Nowy Jork: Firma Macmillan.

- Departament Handlu Stanów Zjednoczonych; Narodowy Oceaniczny; Administracja atmosfery; National Weather Service, wyd. (1979). National Weather Service Handbook nr 1 – Produkty faksowe . Waszyngton, DC: Departament Handlu.

Linki zewnętrzne

- Aktualizacja superkomputera NOAA

- Superkomputery NOAA

- Laboratorium Zasobów Powietrza

- Flotowe Centrum Meteorologii i Oceanografii Numerycznej

- Europejskie Centrum Prognoz Średnioterminowych

- Biuro w Wielkiej Brytanii