Bioinformatyka - Bioinformatics

Bioinformatykę ( / ˌ b aɪ . Oʊ ˌ ɪ n f ər m ć t ɪ k y / ( słuchać )![]() ) jest interdyscyplinarnego pole, które rozwija metody i narzędzi programistycznych dla zrozumienia biologicznej danych, w szczególności, gdy zestawy danych są duże i skomplikowane . Jako interdyscyplinarna dziedzina nauki, bioinformatyka łączy biologię , informatykę , inżynierię informacyjną , matematykę i statystykę w celu analizy i interpretacji danych biologicznych . Bioinformatyka została wykorzystana do analiz in silico zapytań biologicznych przy użyciu technik matematycznych i statystycznych.

) jest interdyscyplinarnego pole, które rozwija metody i narzędzi programistycznych dla zrozumienia biologicznej danych, w szczególności, gdy zestawy danych są duże i skomplikowane . Jako interdyscyplinarna dziedzina nauki, bioinformatyka łączy biologię , informatykę , inżynierię informacyjną , matematykę i statystykę w celu analizy i interpretacji danych biologicznych . Bioinformatyka została wykorzystana do analiz in silico zapytań biologicznych przy użyciu technik matematycznych i statystycznych.

Bioinformatyka obejmuje badania biologiczne wykorzystujące programowanie komputerowe jako część swojej metodologii, a także specyficzne „potoki” analityczne, które są wielokrotnie wykorzystywane, szczególnie w dziedzinie genomiki . Powszechne zastosowania bioinformatyki obejmują identyfikację genów kandydujących i polimorfizmów pojedynczego nukleotydu ( SNP ). Często taka identyfikacja ma na celu lepsze zrozumienie genetycznych podstaw choroby, unikalnych adaptacji, pożądanych właściwości (zwłaszcza u gatunków rolniczych) lub różnic między populacjami. W mniej formalny sposób bioinformatyka stara się również zrozumieć zasady organizacji sekwencji kwasów nukleinowych i białek , zwane proteomiką .

Przegląd

Bioinformatyka stała się ważną częścią wielu dziedzin biologii. W eksperymentalnej biologii molekularnej techniki bioinformatyczne, takie jak przetwarzanie obrazu i sygnału, umożliwiają ekstrakcję użytecznych wyników z dużych ilości surowych danych. W dziedzinie genetyki wspomaga sekwencjonowanie i opisywanie genomów oraz ich obserwowanych mutacji . Odgrywa rolę w eksploracji tekstów literatury biologicznej i rozwoju ontologii biologicznych i genowych w celu organizowania i wyszukiwania danych biologicznych. Odgrywa również rolę w analizie ekspresji i regulacji genów i białek. Narzędzia bioinformatyczne pomagają porównywać, analizować i interpretować dane genetyczne i genomiczne oraz, bardziej ogólnie, w zrozumieniu ewolucyjnych aspektów biologii molekularnej. Na bardziej integracyjnym poziomie pomaga analizować i katalogować biologiczne ścieżki i sieci, które są ważną częścią biologii systemów . W biologii strukturalnej wspomaga symulację i modelowanie DNA, RNA, białek oraz oddziaływań biomolekularnych.

Historia

Historycznie termin bioinformatyka nie oznaczał tego, co oznacza dzisiaj. Paulien Hogeweg i Ben Hesper ukuli go w 1970 roku, aby odnieść się do badania procesów informacyjnych w systemach biotycznych. Definicja ta stawia bioinformatykę jako dziedzinę równoległą do biochemii (badanie procesów chemicznych w układach biologicznych).

Sekwencje

Komputery stały się niezbędne w biologii molekularnej, gdy sekwencje białek stały się dostępne po tym, jak Frederick Sanger określił sekwencję insuliny na początku lat pięćdziesiątych. Porównywanie wielu sekwencji ręcznie okazało się niepraktyczne. Pionierką w tej dziedzinie była Margaret Oakley Dayhoff . Skompilowała jedną z pierwszych baz danych sekwencji białkowych, początkowo opublikowaną w formie książek i będącą pionierem metod dopasowania sekwencji i ewolucji molekularnej. Innym wczesnym uczestnikiem bioinformatyki był Elvin A. Kabat , który w 1970 roku był pionierem w analizie sekwencji biologicznych z obszernymi tomami sekwencji przeciwciał wypuszczonych wraz z Tai Te Wu w latach 1980-1991. W latach 70. nowe techniki sekwencjonowania DNA zastosowano do bakteriofaga MS2 i øX174, a rozszerzone sekwencje nukleotydowe analizowano następnie za pomocą algorytmów informacyjnych i statystycznych. Badania te pokazały, że dobrze znane cechy, takie jak segmenty kodujące i kod trypletowy, są ujawniane w prostych analizach statystycznych, a zatem były dowodem na to, że bioinformatyka byłaby wnikliwa.

Cele

Aby zbadać, w jaki sposób normalna aktywność komórkowa zmienia się w różnych stanach chorobowych, należy połączyć dane biologiczne, aby stworzyć kompleksowy obraz tych działań. Dlatego dziedzina bioinformatyki rozwinęła się tak, że obecnie najpilniejszym zadaniem jest analiza i interpretacja różnych typów danych. Obejmuje to również sekwencje nukleotydowe i aminokwasowe , domeny białkowe i struktury białkowe . Właściwy proces analizy i interpretacji danych określany jest mianem biologii obliczeniowej . Ważne poddyscypliny w bioinformatyce i biologii obliczeniowej obejmują:

- Opracowywanie i wdrażanie programów komputerowych umożliwiających sprawny dostęp, zarządzanie i korzystanie z różnego rodzaju informacji.

- Opracowanie nowych algorytmów (wzory matematyczne) i miar statystycznych oceniających relacje między członkami dużych zbiorów danych. Na przykład, istnieją metody lokalizowania genu w sekwencji, przewidywania struktury i/lub funkcji białka oraz łączenia sekwencji białkowych w rodziny powiązanych sekwencji.

Podstawowym celem bioinformatyki jest lepsze zrozumienie procesów biologicznych. Tym, co odróżnia ją od innych podejść, jest jednak skupienie się na rozwijaniu i stosowaniu intensywnych obliczeniowo technik do osiągnięcia tego celu. Przykłady obejmują: rozpoznawanie wzorców , eksplorację danych , algorytmy uczenia maszynowego i wizualizację . Znaczne wysiłki badawcze w tej dziedzinie to dopasowanie sekwencji , ustalenie genu , genom montażu , projektowaniu leków , Drug Discovery , wyrównanie struktury białka , przewidywanie struktury białka , przewidywanie ekspresji genu i oddziaływań białko-białko , badania asocjacji całego genomu , modelowanie ewolucji i podział/mitoza komórek.

Bioinformatyka obejmuje obecnie tworzenie i rozwój baz danych, algorytmów, technik obliczeniowych i statystycznych oraz teorii w celu rozwiązywania formalnych i praktycznych problemów wynikających z zarządzania i analizy danych biologicznych.

W ciągu ostatnich kilkudziesięciu lat szybki rozwój technologii genomicznych i innych badań molekularnych oraz rozwój technologii informatycznych połączył się, tworząc ogromną ilość informacji związanych z biologią molekularną. Bioinformatyka to nazwa nadana tym matematycznym i obliczeniowym podejściom używanym do zrozumienia procesów biologicznych.

Typowe działania w bioinformatyce obejmują mapowanie i analizowanie sekwencji DNA i białek, dopasowywanie sekwencji DNA i białek w celu ich porównania oraz tworzenie i przeglądanie trójwymiarowych modeli struktur białkowych.

Związek z innymi dziedzinami

Bioinformatyka to dziedzina nauki, która jest podobna do obliczeń biologicznych , ale różni się od nich , chociaż często jest uważana za synonim biologii obliczeniowej . Obliczenia biologiczne wykorzystują bioinżynierię i biologię do budowy komputerów biologicznych , natomiast bioinformatyka wykorzystuje obliczenia do lepszego zrozumienia biologii. Bioinformatyka i biologia obliczeniowa obejmują analizę danych biologicznych, w szczególności sekwencji DNA, RNA i białek. Dziedzina bioinformatyki doświadczyła gwałtownego wzrostu od połowy lat 90., napędzanego głównie przez Projekt Genomu Ludzkiego i szybkie postępy w technologii sekwencjonowania DNA.

Analiza danych biologicznych w celu uzyskania znaczących informacji obejmuje pisanie i uruchamianie programów, które wykorzystują algorytmy z teorii grafów , sztucznej inteligencji , soft computing , eksploracji danych , przetwarzania obrazów i symulacji komputerowych . Algorytmy z kolei zależy od podstaw teoretycznych jak dyskretnych matematyki , teorii sterowania , teorii systemów , teorii informacji i statystyk .

Analiza sekwencji

Ponieważ Fag Φ-x174 został zsekwencjonowany w 1977 roku, gdy sekwencje DNA zostały dekodowane i przechowywane w bazach tysięcy organizmów. Te informacje o sekwencji są analizowane w celu określenia genów kodujących białka , geny RNA, sekwencje regulatorowe, motywy strukturalne i sekwencje powtarzalne. Porównanie genów w obrębie gatunku lub między różnymi gatunkami może wykazywać podobieństwa między funkcjami białek lub relacje między gatunkami (wykorzystanie systematyki molekularnej do konstruowania drzew filogenetycznych ). Wraz z rosnącą ilością danych, dawno temu ręczne analizowanie sekwencji DNA stało się niepraktyczne. Programy komputerowe, takie jak BLAST, są rutynowo używane do wyszukiwania sekwencji – od 2008 roku z ponad 260 000 organizmów zawierających ponad 190 miliardów nukleotydów .

sekwencjonowanie DNA

Zanim sekwencje będą mogły być analizowane, muszą być uzyskane z banku pamięci danych, np. Genbank. Sekwencjonowanie DNA jest nadal nietrywialnym problemem, ponieważ surowe dane mogą być zaszumione lub obarczone słabymi sygnałami. Opracowano algorytmy bazowe dla różnych eksperymentalnych podejść do sekwencjonowania DNA.

Montaż sekwencji

Większość technik sekwencjonowania DNA wytwarza krótkie fragmenty sekwencji, które należy złożyć w celu uzyskania pełnej sekwencji genu lub genomu. Technika sekwencjonowania tzw. shotgun (która została wykorzystana m.in. przez The Institute for Genomic Research (TIGR) do sekwencjonowania pierwszego genomu bakterii Haemophilus influenzae ) generuje sekwencje wielu tysięcy małych fragmentów DNA (od 35 do 900 nukleotydów, w zależności od technologii sekwencjonowania). Końce tych fragmentów zachodzą na siebie i po odpowiednim dopasowaniu za pomocą programu do składania genomu można je wykorzystać do zrekonstruowania całego genomu. Sekwencjonowanie shotgun szybko dostarcza danych sekwencyjnych, ale zadanie złożenia fragmentów może być dość skomplikowane w przypadku większych genomów. W przypadku genomu tak dużego jak ludzki , złożenie fragmentów może zająć wiele dni procesora na komputerach wieloprocesorowych o dużej pamięci, a wynikowy zespół zwykle zawiera liczne luki, które należy później wypełnić. Sekwencjonowanie strzelby jest metodą z wyboru dla praktycznie wszystkich sekwencjonowanych obecnie genomów, a algorytmy składania genomu są krytycznym obszarem badań bioinformatycznych.

Adnotacja do genomu

W kontekście genomiki , przyp to proces znakowania genów i inne funkcje biologiczne w sekwencji DNA. Proces ten należy zautomatyzować, ponieważ większość genomów jest zbyt duża, aby można je było opisywać ręcznie, nie wspominając już o chęci opisywania jak największej liczby genomów, ponieważ szybkość sekwencjonowania przestała stanowić wąskie gardło. Adnotacja jest możliwa dzięki temu, że geny mają rozpoznawalne regiony start i stop, chociaż dokładna sekwencja znaleziona w tych regionach może się różnić w zależności od genów.

Pierwszy opis kompleksowego systemu adnotacji genomu został opublikowany w 1995 roku przez zespół Instytutu Badań Genomicznych, który przeprowadził pierwsze kompletne sekwencjonowanie i analizę genomu wolno żyjącego organizmu, bakterii Haemophilus influenzae . Owen White zaprojektował i zbudował system oprogramowania do identyfikacji genów kodujących wszystkie białka, przenoszących RNA, rybosomalnych RNA (i innych miejsc) oraz do wstępnego przypisania funkcji. Większość obecnych systemów adnotacji genomu działa podobnie, ale programy dostępne do analizy genomowego DNA, takie jak program GeneMark wyszkolony i wykorzystywany do wyszukiwania genów kodujących białka u Haemophilus influenzae , ciągle się zmieniają i ulepszają.

W ślad za celami, jakie po zamknięciu w 2003 r. pozostawił Human Genome Project po jego zamknięciu, pojawił się nowy projekt opracowany przez National Human Genome Research Institute w USA. Tak zwany projekt ENCODE polega na wspólnym gromadzeniu danych funkcjonalnych elementów genomu ludzkiego, który wykorzystuje technologie sekwencjonowania DNA nowej generacji i macierze płytek genomowych, technologie zdolne do automatycznego generowania dużych ilości danych przy radykalnie obniżonym koszcie bazowym ale z taką samą dokładnością (błąd wywołania podstawowego) i wiernością (błąd montażu).

Przewidywanie funkcji genów

Chociaż adnotacja genomu opiera się głównie na podobieństwie sekwencji (a tym samym homologii ), inne właściwości sekwencji można wykorzystać do przewidywania funkcji genów. W rzeczywistości większość metod przewidywania funkcji genów koncentruje się na sekwencjach białek , ponieważ są one bardziej pouczające i bogatsze w funkcje. Na przykład rozkład aminokwasów hydrofobowych przewiduje segmenty transbłonowe w białkach. Jednak przewidywanie funkcji białek może również wykorzystywać informacje zewnętrzne, takie jak dane dotyczące ekspresji genu (lub białka) , struktura białka lub interakcje białko-białko .

Obliczeniowa biologia ewolucyjna

Biologia ewolucyjna zajmuje się badaniem pochodzenia i pochodzenia gatunków , a także ich zmian w czasie. Informatyka pomogła biologom ewolucyjnym, umożliwiając naukowcom:

- śledzić ewolucję dużej liczby organizmów, mierząc zmiany w ich DNA , a nie wyłącznie przez taksonomię fizyczną lub obserwacje fizjologiczne,

- porównywać całe genomy , co pozwala na badanie bardziej złożonych zdarzeń ewolucyjnych, takich jak duplikacja genów , horyzontalny transfer genów oraz przewidywanie czynników istotnych w specjacji bakterii ,

- budować złożone modele obliczeniowej genetyki populacji w celu przewidywania wyników systemu w czasie

- śledzić i udostępniać informacje o coraz większej liczbie gatunków i organizmów

Przyszłe prace mają na celu zrekonstruowanie bardziej złożonego drzewa życia .

Obszar badań w informatyce, który wykorzystuje algorytmy genetyczne, jest czasami mylony z obliczeniową biologią ewolucyjną, ale te dwa obszary niekoniecznie są ze sobą powiązane.

Genomika porównawcza

Istotą porównawczej analizy genomu jest ustalenie zgodności między genami ( analiza ortologiczna ) lub innymi cechami genomowymi w różnych organizmach. To właśnie te mapy międzygenomiczne umożliwiają prześledzenie procesów ewolucyjnych odpowiedzialnych za rozbieżność dwóch genomów. Mnogość wydarzeń ewolucyjnych działających na różnych poziomach organizacyjnych kształtuje ewolucję genomu. Na najniższym poziomie mutacje punktowe wpływają na poszczególne nukleotydy. Na wyższym poziomie duże segmenty chromosomów podlegają duplikacji, transferowi bocznemu, inwersji, transpozycji, delecji i insercji. Ostatecznie w procesy hybrydyzacji, poliploidyzacji i endosymbiozy zaangażowane są całe genomy , co często prowadzi do szybkiej specjacji. Złożoność ewolucji genomu stawia wiele ekscytujących wyzwań przed twórcami modeli i algorytmów matematycznych, którzy odwołują się do szerokiego spektrum technik algorytmicznych, statystycznych i matematycznych, od dokładnych, heurystycznych , algorytmów o stałych parametrach i algorytmów aproksymacji do problemów opartych na modelach oszczędnościowych po Markowa. łańcuchowe algorytmy Monte Carlo do bayesowskiej analizy problemów w oparciu o modele probabilistyczne.

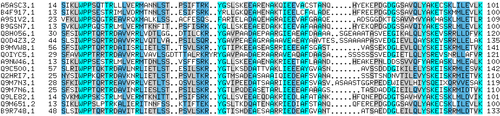

Wiele z tych badań opiera się na wykrywaniu homologii sekwencji w celu przypisania sekwencji do rodzin białek .

Pan genomika

Pan genomika to koncepcja wprowadzona w 2005 roku przez Tettelin i Medini, która ostatecznie zakorzeniła się w bioinformatyce. Genom pan jest kompletnym repertuarem genów określonej grupy taksonomicznej: chociaż początkowo stosowany do blisko spokrewnionych szczepów gatunku, może być stosowany w szerszym kontekście, takim jak rodzaj, gromada itp. Jest podzielony na dwie części - Genom podstawowy: Zestaw genów wspólnych dla wszystkich badanych genomów (często są to geny porządkowe niezbędne do przetrwania) oraz The Dispensable/Flexible Genome: Zestaw genów nieobecnych we wszystkich badanych genomach poza jednym lub kilkoma. Do scharakteryzowania Pan Genomu gatunków bakterii można wykorzystać narzędzie bioinformatyczne BPGA.

Genetyka choroby

Wraz z pojawieniem się sekwencjonowania nowej generacji uzyskujemy wystarczającą ilość danych sekwencyjnych do mapowania genów złożonych chorób niepłodności , raka piersi czy choroby Alzheimera . Badania asocjacyjne całego genomu są użytecznym podejściem do wskazywania mutacji odpowiedzialnych za tak złożone choroby. Dzięki tym badaniom zidentyfikowano tysiące wariantów DNA, które są powiązane z podobnymi chorobami i cechami. Co więcej, możliwość wykorzystania genów w prognozowaniu, diagnozowaniu lub leczeniu jest jednym z najważniejszych zastosowań. Wiele badań omawia zarówno obiecujące sposoby wyboru genów do wykorzystania, jak i problemy i pułapki związane z wykorzystaniem genów do przewidywania obecności choroby lub rokowania.

Analiza mutacji w raku

W przypadku raka genomy dotkniętych komórek ulegają przegrupowaniu w złożony, a nawet nieprzewidywalny sposób. Ogromne wysiłki sekwencjonowania są wykorzystywane do identyfikacji wcześniej nieznanych mutacji punktowych w różnych genach raka. Bioinformatycy nadal produkują wyspecjalizowane zautomatyzowane systemy do zarządzania samą ilością wytworzonych danych sekwencyjnych, a także tworzą nowe algorytmy i oprogramowanie do porównywania wyników sekwencjonowania z rosnącą kolekcją sekwencji ludzkiego genomu i polimorfizmów linii zarodkowej . Wykorzystywane są nowe fizyczne technologie wykrywania, takie jak mikromacierze oligonukleotydowe do identyfikacji przyrostów i strat chromosomów (tzw. porównawcza hybrydyzacja genomowa ) oraz macierze polimorfizmu pojedynczego nukleotydu do wykrywania znanych mutacji punktowych . Te metody wykrywania jednocześnie mierzą kilkaset tysięcy miejsc w całym genomie, a gdy są używane w wysokiej przepustowości do pomiaru tysięcy próbek, generują terabajty danych na eksperyment. Ponownie ogromne ilości i nowe rodzaje danych stwarzają nowe możliwości dla bioinformatyków. Często okazuje się, że dane zawierają znaczną zmienność lub szum , dlatego też opracowuje się model ukrytego Markowa i metody analizy punktów zmian, aby wywnioskować zmiany rzeczywistej liczby kopii .

W analizie genomów nowotworowych bioinformatycznie odnoszących się do identyfikacji mutacji w egzomie można zastosować dwie ważne zasady . Po pierwsze, rak jest chorobą nagromadzonych mutacji somatycznych w genach. Drugi rak zawiera mutacje kierowcy, które należy odróżnić od pasażerów.

Dzięki przełomowym odkryciom, jakie ta technologia sekwencjonowania nowej generacji zapewnia w dziedzinie bioinformatyki, genomika nowotworów może ulec radykalnym zmianom. Te nowe metody i oprogramowanie pozwalają bioinformatom na szybką i niedrogą sekwencjonowanie wielu genomów raka. Mogłoby to stworzyć bardziej elastyczny proces klasyfikacji typów raka poprzez analizę mutacji nowotworowych w genomie. Co więcej, w przyszłości możliwe będzie śledzenie pacjentów podczas postępu choroby za pomocą sekwencji próbek raka.

Innym rodzajem danych, który wymaga opracowania nowej informatyki, jest analiza zmian chorobowych, które są nawracające w wielu nowotworach.

Ekspresja genów i białek

Analiza ekspresji genów

Ekspresji wielu genów, może być określona przez pomiar mRNA poziomy z wielu technik, w tym mikromacierzy , wyrażone cDNA znacznik sekwencji (EST) sekwencjonowanie wielokrotną analizę ekspresji genów (SAGE) znacznika sekwencjonowania sekwencjonowanie podpis masowego przetwarzania równoległego (MPSS) RNA seq , znany również jako „Whole Transcriptome Shotgun Sequencing” (WTSS) lub różne zastosowania multipleksowanej hybrydyzacji in-situ. Wszystkie te techniki są niezwykle podatne na szumy i/lub podlegają stronniczości w pomiarach biologicznych, a główny obszar badań w biologii obliczeniowej obejmuje opracowanie narzędzi statystycznych do oddzielania sygnału od szumu w wysokoprzepustowych badaniach ekspresji genów. Takie badania są często wykorzystywane do określenia genów związanych z zaburzeniem: można porównać dane z mikromacierzy z nowotworowych komórek nabłonka z danymi z komórek nienowotworowych, aby określić transkrypty, które są regulowane w górę i w dół w określonej populacji komórek nowotworowych .

Analiza ekspresji białek

Mikromacierze białkowe i wysokoprzepustowa (HT) spektrometria masowa (MS) mogą dostarczyć migawkę białek obecnych w próbce biologicznej. Bioinformatyka jest bardzo zaangażowana w zrozumienie mikromacierzy białkowych i danych HT MS; pierwsze podejście napotyka podobne problemy, jak w przypadku mikromacierzy ukierunkowanych na mRNA, drugie wiąże się z problemem dopasowania dużych ilości danych masowych do przewidywanych mas z baz danych sekwencji białek oraz skomplikowanej analizy statystycznej próbek, w których wiele, ale niekompletnych peptydów z każdego białka jest wykryto. Lokalizację białek komórkowych w kontekście tkankowym można osiągnąć za pomocą proteomiki powinowactwa przedstawianej jako dane przestrzenne w oparciu o immunohistochemię i mikromacierze tkankowe .

Analiza regulacji

Regulacja genów to złożona orkiestracja zdarzeń, dzięki której sygnał, potencjalnie sygnał zewnątrzkomórkowy, taki jak hormon , ostatecznie prowadzi do zwiększenia lub zmniejszenia aktywności jednego lub większej liczby białek . Techniki bioinformatyczne zostały zastosowane do zbadania różnych etapów tego procesu.

Na przykład ekspresja genów może być regulowana przez pobliskie elementy genomu. Analiza promotora obejmuje identyfikację i badanie motywów sekwencji w DNA otaczającym region kodujący genu. Motywy te wpływają na stopień transkrypcji tego regionu do mRNA. Elementy wzmacniające znajdujące się daleko od promotora mogą również regulować ekspresję genów poprzez trójwymiarowe interakcje pętli. Te interakcje można określić za pomocą bioinformatycznej analizy eksperymentów z wychwytywaniem konformacji chromosomów .

Dane dotyczące ekspresji można wykorzystać do wywnioskowania regulacji genów: można porównać dane z mikromacierzy z wielu różnych stanów organizmu, aby sformułować hipotezy dotyczące genów zaangażowanych w każdy stan. W organizmie jednokomórkowym można porównać etapy cyklu komórkowego wraz z różnymi warunkami stresowymi (szok cieplny, głód itp.). Można następnie zastosować algorytmy grupowania do tych danych ekspresji, aby określić, które geny ulegają koekspresji. Na przykład, regiony powyżej (promotory) koeksprymowanych genów można przeszukiwać pod kątem nadreprezentowanych elementów regulatorowych . Przykładami algorytmów grupowania stosowanych w grupowaniu genów są grupowanie k-średnich , mapy samoorganizujące się (SOM), grupowanie hierarchiczne i metody grupowania konsensusowego .

Analiza organizacji komórkowej

Opracowano kilka podejść do analizy lokalizacji organelli, genów, białek i innych składników w komórkach. Jest to istotne, ponieważ lokalizacja tych składników wpływa na zdarzenia w komórce, a tym samym pomaga nam przewidywać zachowanie systemów biologicznych. Gen ontologia kategoria, składnikiem komórkowym , została opracowana do przechwytywania wewnątrzkomórkową lokalizację w wielu biologicznych baz danych .

Mikroskopia i analiza obrazu

Zdjęcia mikroskopowe pozwalają nam zlokalizować zarówno organelle, jak i molekuły. Może również pomóc nam odróżnić komórki prawidłowe od nieprawidłowych, np. w raku .

Lokalizacja białka

Lokalizacja białek pomaga nam ocenić rolę białka. Na przykład, jeśli białko zostanie znalezione w jądrze , może być zaangażowane w regulację genu lub splicing . W przeciwieństwie do tego, jeśli białko znajduje się w mitochondriach , może być zaangażowane w oddychanie lub inne procesy metaboliczne . Lokalizacja białek jest zatem ważnym elementem przewidywania funkcji białek . Dostępne są dobrze rozwinięte zasoby przewidywania lokalizacji na poziomie subkomórkowym białek , w tym bazy danych lokalizacji na poziomie subkomórkowym białek i narzędzia do przewidywania.

Jądrowa organizacja chromatyny

Dane z wysokoprzepustowych eksperymentów wychwytywania konformacji chromosomów , takich jak Hi-C (eksperyment) i ChIA-PET , mogą dostarczyć informacji o przestrzennej bliskości loci DNA. Analiza tych eksperymentów może określić trójwymiarową strukturę i organizację jądrową chromatyny. Wyzwania bioinformatyczne w tej dziedzinie obejmują podział genomu na domeny, takie jak domeny powiązane topologicznie (TAD), które są zorganizowane razem w przestrzeni trójwymiarowej.

Bioinformatyka strukturalna

Przewidywanie struktury białek to kolejne ważne zastosowanie bioinformatyki. Sekwencję aminokwasową białka, tzw. strukturę pierwszorzędową , można łatwo określić na podstawie sekwencji kodującej ją genu. W zdecydowanej większości przypadków ta pierwotna struktura jednoznacznie determinuje strukturę w jej rodzimym środowisku. (Oczywiście, istnieją wyjątki takie jak bydlęcej gąbczastej encefalopatii (choroba wściekłych krów) priony ). Znajomość tej konstrukcji jest to istotne dla zrozumienia funkcji białek. Informacje strukturalne są zwykle klasyfikowane jako informacje o strukturze drugorzędowej , trzeciorzędowej i czwartorzędowej . Realne ogólne rozwiązanie takich prognoz pozostaje otwartym problemem. Większość dotychczasowych wysiłków była skierowana na heurystyki, które działają przez większość czasu.

Jedną z kluczowych idei w bioinformatyce jest pojęcie homologii . W genomicznej gałęzi bioinformatyki homologia służy do przewidywania funkcji genu: jeśli sekwencja genu A , którego funkcja jest znana, jest homologiczna do sekwencji genu B, którego funkcja jest nieznana, można wnioskować, że B może dzielić funkcję A. W strukturalnej gałęzi bioinformatyki, homologia jest używana do określenia, które części białka są ważne w tworzeniu struktury i interakcji z innymi białkami. W technice zwanej modelowaniem homologii informacje te są wykorzystywane do przewidywania struktury białka po poznaniu struktury białka homologicznego. Obecnie pozostaje to jedynym sposobem wiarygodnego przewidywania struktur białkowych.

Jednym z przykładów jest hemoglobina u ludzi i hemoglobina w roślinach strączkowych ( leghemoglobina ), które są dalekimi krewnymi z tej samej nadrodziny białek . Oba służą temu samemu celowi transportu tlenu w organizmie. Chociaż oba te białka mają zupełnie różne sekwencje aminokwasowe, ich struktury białkowe są praktycznie identyczne, co odzwierciedla ich niemal identyczne cele i wspólnego przodka.

Inne techniki przewidywania struktury białek obejmują wątkowanie białek i modelowanie de novo (od zera) oparte na fizyce.

Innym aspektem bioinformatyki strukturalnej jest wykorzystanie struktur białkowych do wirtualnych modeli przesiewowych , takich jak modele ilościowej relacji struktura-aktywność i modele proteochemometryczne (PCM). Ponadto struktura krystaliczna białka może być wykorzystana do symulacji na przykład badań wiązania ligandów i badań mutagenezy in silico .

Biologia sieci i systemów

Analiza sieci ma na celu zrozumienie relacji w sieciach biologicznych, takich jak sieci interakcji metabolicznych lub białko-białko . Chociaż sieci biologiczne można zbudować z jednego typu cząsteczki lub jednostki (takiej jak geny), biologia sieci często próbuje zintegrować wiele różnych typów danych, takich jak białka, małe cząsteczki, dane dotyczące ekspresji genów i inne, które są połączone fizycznie , funkcjonalnie lub jedno i drugie.

Biologia systemów polega na stosowaniu w symulacjach komputerowych z komórkowych podzespołów (takich jak sieci metabolitów i enzymy , które zawierają metabolizm , transdukcji sygnałów ścieżki i sieci regulacji genów ) zarówno analizujących i wizualizacji skomplikowanych połączeń tych procesów komórkowych. Sztuczne życie lub wirtualna ewolucja próbuje zrozumieć procesy ewolucyjne poprzez komputerową symulację prostych (sztucznych) form życia.

Sieci interakcji molekularnych

Dziesiątki tysięcy trójwymiarowych struktur białkowych określono za pomocą krystalografii rentgenowskiej i spektroskopii magnetycznego rezonansu jądrowego białek (białkowy NMR), a głównym pytaniem w bioinformatyce strukturalnej jest to, czy praktyczne jest przewidywanie możliwych interakcji białko-białko tylko na podstawie tych Kształty 3D bez przeprowadzania eksperymentów interakcji białko-białko . Opracowano różne metody, aby rozwiązać problem dokowania białko-białko , chociaż wydaje się, że wciąż jest wiele do zrobienia w tej dziedzinie.

Inne interakcje spotykane w tej dziedzinie obejmują białko-ligand (w tym lek) i białko-peptyd . Molekularna dynamiczna symulacja ruchu atomów wokół wiązań obrotowych jest podstawową zasadą algorytmów obliczeniowych , określanych jako algorytmy dokowania, do badania interakcji molekularnych .

Inni

Analiza literatury

Wzrost liczby publikowanej literatury praktycznie uniemożliwia przeczytanie każdego artykułu, co skutkuje rozłącznymi poddziedzinami badawczymi. Analiza literatury ma na celu wykorzystanie lingwistyki obliczeniowej i statystycznej do przeszukiwania tej rosnącej biblioteki zasobów tekstowych. Na przykład:

- Rozpoznawanie skrótów – zidentyfikuj długą formę i skrót terminów biologicznych

- Rozpoznawanie nazwanych jednostek – rozpoznawanie terminów biologicznych, takich jak nazwy genów

- Interakcja białko-białko – zidentyfikuj, które białka wchodzą w interakcje z jakimi białkami z tekstu

Obszar badań czerpie ze statystyki i językoznawstwa komputerowego .

Analiza obrazu o wysokiej przepustowości

Technologie obliczeniowe służą do przyspieszenia lub pełnej automatyzacji przetwarzania, oceny ilościowej i analizy dużych ilości obrazów biomedycznych o dużej zawartości informacji . Nowoczesne systemy analizy obrazu zwiększają zdolność obserwatora do dokonywania pomiarów na podstawie dużego lub złożonego zestawu obrazów, poprawiając dokładność , obiektywność lub szybkość. W pełni rozwinięty system analizy może całkowicie zastąpić obserwatora. Chociaż systemy te nie są unikalne dla obrazowania biomedycznego, obrazowanie biomedyczne staje się coraz ważniejsze zarówno w diagnostyce, jak i badaniach. Oto kilka przykładów:

- wysokoprzepustowa i wierna kwantyfikacja i lokalizacja subkomórkowa ( przesiewowe badania przesiewowe , cytohistopatologia, informatyka Bioimage )

- morfometria

- analiza i wizualizacja obrazu klinicznego

- określenie wzorców przepływu powietrza w czasie rzeczywistym w oddychających płucach żywych zwierząt

- ilościowe określenie wielkości okluzji na obrazach w czasie rzeczywistym z rozwoju i powrotu do zdrowia po urazie tętnicy

- dokonywanie obserwacji behawioralnych z rozbudowanych nagrań wideo zwierząt laboratoryjnych

- pomiary w podczerwieni do określenia aktywności metabolicznej

- wnioskowanie nakładania się klonów w mapowaniu DNA , np. wynik Sulstona

Wysokowydajna analiza danych z pojedynczej komórki

Techniki obliczeniowe są wykorzystywane do analizowania wysokoprzepustowych danych z pojedynczych komórek o niskich pomiarach, takich jak te uzyskane z cytometrii przepływowej . Metody te zazwyczaj obejmują znajdowanie populacji komórek, które są istotne dla określonego stanu chorobowego lub stanu doświadczalnego.

Informatyka bioróżnorodności

Informatyka bioróżnorodności zajmuje się gromadzeniem i analizą danych dotyczących bioróżnorodności , takich jak bazy danych taksonomicznych lub dane dotyczące mikrobiomu . Przykłady takich analiz obejmują filogenetykę , modelowanie niszowe , mapowanie bogactwa gatunków , kodowanie kreskowe DNA lub narzędzia do identyfikacji gatunków .

Ontologie i integracja danych

Ontologie biologiczne są skierowane acykliczne wykresy z kontrolowanych słowników . Zostały zaprojektowane tak, aby uchwycić pojęcia i opisy biologiczne w sposób, który można łatwo kategoryzować i analizować za pomocą komputerów. Przy takiej kategoryzacji można uzyskać wartość dodaną z całościowej i zintegrowanej analizy.

OBO Foundry była próbą ujednolicenia pewnych ontologii. Jedną z najbardziej rozpowszechnionych jest ontologia genów opisująca funkcję genów. Istnieją również ontologie opisujące fenotypy.

Bazy danych

Bazy danych są niezbędne do badań i zastosowań bioinformatycznych. Istnieje wiele baz danych obejmujących różne rodzaje informacji: na przykład sekwencje DNA i białek, struktury molekularne, fenotypy i bioróżnorodność. Bazy danych mogą zawierać dane empiryczne (uzyskane bezpośrednio z eksperymentów), dane przewidywane (uzyskane z analizy) lub, najczęściej, oba. Mogą być specyficzne dla konkretnego organizmu, ścieżki lub cząsteczki będącej przedmiotem zainteresowania. Alternatywnie mogą zawierać dane skompilowane z wielu innych baz danych. Te bazy danych różnią się formatem, mechanizmem dostępu oraz tym, czy są publiczne, czy nie.

Poniżej wymieniono niektóre z najczęściej używanych baz danych. Aby uzyskać bardziej wyczerpującą listę, sprawdź link na początku podsekcji.

- Stosowane w analizie sekwencji biologicznej: Genbank , UniProt

- Stosowany w analizie struktury: Protein Data Bank (PDB)

- Używany w znalezieniu rodzin białek i Motif Znalezienie: Interpro , pfam

- Używany do sekwencjonowania nowej generacji: archiwum odczytu sekwencji

- Wykorzystywane w analizie sieci: bazy danych szlaków metabolicznych ( KEGG , BioCyc ), bazy danych analizy interakcji, sieci funkcjonalne

- Stosowany w projektowaniu syntetycznych obwodów genetycznych: GenoCAD

Oprogramowanie i narzędzia

Narzędzia programowe dla bioinformatyki obejmują zarówno proste narzędzia wiersza poleceń, jak i bardziej złożone programy graficzne i samodzielne usługi sieciowe dostępne w różnych firmach bioinformatycznych lub instytucjach publicznych.

Oprogramowanie bioinformatyczne typu open source

Wiele darmowych i open-source narzędzi programowych istnieje i rozwija się od lat 80. XX wieku. Połączenie ciągłego zapotrzebowania na nowe algorytmy do analizy pojawiających się typów odczytów biologicznych, potencjału innowacyjnych eksperymentów in silico oraz swobodnie dostępnych otwartych baz kodu pomogło stworzyć wszystkim grupom badawczym możliwości wniesienia wkładu zarówno w bioinformatykę, jak i dostępnego oprogramowania typu open source, niezależnie od ustaleń dotyczących finansowania. Narzędzia open source często działają jako inkubatory pomysłów lub wspierane przez społeczność wtyczki w aplikacjach komercyjnych. Mogą również dostarczać de facto standardów i wspólnych modeli obiektów, aby pomóc w wyzwaniu integracji bioinformacji.

Zakres pakietów oprogramowania open source zawiera takie tytuły jak BioConductor , BioPerl , Biopython , BioJava , BioJS , BioRuby , Bioclipse , EMBOSS , .NET Bio , pomarańczowy z jego bioinformatyka add-on, Apache Taverna , UGENE i GenoCAD . Aby podtrzymać tę tradycję i stworzyć dalsze możliwości, non-profit Open Bioinformatics Foundation wspiera coroczną konferencję Bioinformatics Open Source Conference (BOSC) od 2000 roku.

Alternatywną metodą budowania publicznych bioinformatycznych baz danych jest użycie silnika MediaWiki z rozszerzeniem WikiOpener . System ten umożliwia dostęp i aktualizację bazy danych wszystkim ekspertom w tej dziedzinie.

Serwisy internetowe w bioinformatyce

Interfejsy oparte na SOAP i REST zostały opracowane dla szerokiej gamy aplikacji bioinformatycznych, dzięki czemu aplikacja działająca na jednym komputerze w jednej części świata może korzystać z algorytmów, danych i zasobów obliczeniowych na serwerach w innych częściach świata. Główne zalety wynikają z faktu, że użytkownicy końcowi nie muszą zajmować się kosztami utrzymania oprogramowania i bazy danych.

Podstawowe usługi bioinformatyczne są klasyfikowane przez EBI w trzech kategoriach: SSS (Sequence Search Services), MSA (Multiple Sequence Alignment) oraz BSA (Biological Sequence Analysis). Dostępność tych zorientowanych na usługi zasobów bioinformatycznych demonstruje możliwość zastosowania internetowych rozwiązań bioinformatycznych i obejmuje zarówno zbiór samodzielnych narzędzi ze wspólnym formatem danych w ramach pojedynczego, samodzielnego lub internetowego interfejsu, jak i integracyjną, rozproszoną i rozszerzalną bioinformatykę systemy zarządzania przepływem pracy .

Bioinformatyczne systemy zarządzania przepływem pracy

A bioinformatyka workflow system zarządzania jest wyspecjalizowaną formą systemu zarządzania przepływem pracy zaprojektowanego specjalnie do komponowania i wykonać szereg czynności obliczeniowych lub dane manipulacja, czy workflow, w aplikacji Bioinformatyki. Takie systemy mają na celu:

- zapewnić łatwe w obsłudze środowisko dla indywidualnych naukowców zajmujących się aplikacjami do tworzenia własnych przepływów pracy,

- udostępnienie naukowcom interaktywnych narzędzi umożliwiających im wykonywanie przepływów pracy i przeglądanie ich wyników w czasie rzeczywistym,

- uprościć proces udostępniania i ponownego wykorzystywania przepływów pracy między naukowcami oraz

- umożliwiają naukowcom śledzenie pochodzenia wyników wykonania przepływu pracy i etapów tworzenia przepływu pracy.

Niektóre z tych platform dających tej usługi: Galaxy , Keplera , Taverna , UGENE , Anduril , ula .

Obiekty BioCompute i BioCompute

W 2014 roku amerykańska Agencja ds. Żywności i Leków sponsorowała konferencję, która odbyła się w kampusie National Institutes of Health Bethesda, aby omówić odtwarzalność w bioinformatyce. Przez następne trzy lata konsorcjum interesariuszy spotykało się regularnie, aby omówić, co stanie się paradygmatem BioCompute. Wśród tych interesariuszy znaleźli się przedstawiciele rządu, przemysłu i instytucji akademickich. Liderzy sesji reprezentowali liczne oddziały instytutów i centrów FDA i NIH, organizacje non-profit, w tym Human Variome Project i Europejską Federację Informatyki Medycznej , oraz instytucje badawcze, w tym Stanford , New York Genome Center i George Washington University .

Zdecydowano, że paradygmat BioCompute będzie miał formę cyfrowych „zeszytów laboratoryjnych”, które pozwolą na odtwarzalność, replikację, przegląd i ponowne wykorzystanie protokołów bioinformatycznych. Zaproponowano to, aby umożliwić większą ciągłość w grupie badawczej w trakcie normalnego przepływu personelu, jednocześnie wspierając wymianę pomysłów między grupami. Amerykańska Agencja ds. Żywności i Leków (FDA) sfinansowała tę pracę, aby informacje o rurociągach były bardziej przejrzyste i dostępne dla personelu regulacyjnego.

W 2016 roku grupa zebrała się ponownie w NIH w Bethesda i omówiła potencjał obiektu BioCompute , przykład paradygmatu BioCompute. Ta praca została skopiowana zarówno jako dokument „standardowego użycia próbnego”, jak i papier do druku wstępnego przesłany do bioRxiv. Obiekt BioCompute umożliwia udostępnianie rekordu w formacie JSON wśród pracowników, współpracowników i regulatorów.

Platformy edukacyjne

Platformy programowe przeznaczone do nauczania koncepcji i metod bioinformatycznych obejmują Rosalind i kursy online oferowane za pośrednictwem portalu szkoleniowego Swiss Institute of Bioinformatics . Kanadyjski Bioinformatyka Warsztaty udostępnia filmy i slajdy ze szkolenia warsztaty na swojej stronie internetowej pod Creative Commons licencji. Projekt 4273π lub projekt 4273pi oferuje również bezpłatne materiały edukacyjne typu open source. Kurs działa na tanich komputerach Raspberry Pi i był wykorzystywany do nauczania dorosłych i uczniów. 4273π jest aktywnie rozwijane przez konsorcjum naukowców i pracowników naukowych, którzy prowadzili bioinformatykę na poziomie badawczym przy użyciu komputerów Raspberry Pi i systemu operacyjnego 4273π.

Platformy MOOC zapewniają również certyfikacje online w zakresie bioinformatyki i pokrewnych dyscyplin, w tym specjalizacji bioinformatycznej Coursera ( UC San Diego ) i specjalizacji nauk genetycznych ( Johns Hopkins ), a także analizy danych EdX dla nauk przyrodniczych XSeries ( Harvard ). University of Southern California oferuje Masters In Translational Bioinformatics, koncentrując się na zastosowaniach biomedycznych.

Konferencje

Istnieje kilka dużych konferencji związanych z bioinformatyką. Niektóre z najbardziej godnych uwagi przykładów to Inteligentne Systemy Biologii Molekularnej (ISMB), Europejska Konferencja Biologii Obliczeniowej (ECCB) i Badania w Obliczeniowej Biologii Molekularnej (RECOMB).

Zobacz też

- Informatyka bioróżnorodności

- Firmy bioinformatyczne

- Biologia obliczeniowa

- Biomodelowanie obliczeniowe

- Genomika obliczeniowa

- Cyberbiobezpieczeństwo

- Genomika funkcjonalna

- Informatyka zdrowotna

- Międzynarodowe Towarzystwo Biologii Obliczeniowej

- Skokowa biblioteka

- Lista instytucji bioinformatycznych

- Lista oprogramowania bioinformatycznego o otwartym kodzie źródłowym

- Lista czasopism bioinformatycznych

- Metabolomika

- Sekwencja kwasu nukleinowego

- Filogenetyka

- Proteomika

- Baza danych chorób genowych

Bibliografia

Dalsza lektura

- Sehgal i in. : Badania strukturalne, filogenetyczne i dokowania aktywatora D-aminokwasowej oksydazy (DAOA ), kandydującego genu schizofrenii. Biologia teoretyczna i modelowanie medyczne 2013 10 :3.

- Raul Isea Współczesne znaczenie słowa Bioinformatyka , Global Journal of Advanced Research, 2015

- Achuthsankar S Nair Computational Biology & Bioinformatics – Delikatny przegląd , Communications of Computer Society of India, styczeń 2007

- Aluru, Srinivas , wyd. Podręcznik komputerowej biologii molekularnej . Chapman & Hall/Crc, 2006. ISBN 1-58488-406-1 (Chapman & Hall/Crc Computer and Information Science Series)

- Baldi, P i Brunak, S, Bioinformatics: The Machine Learning Approach , wydanie drugie. MIT Press, 2001. ISBN 0-262-02506-X

- Barnes, MR i Gray, IC, eds., Bioinformatics for Geneticists , wydanie pierwsze. Wiley, 2003. ISBN 0-470-84394-2

- Baxevanis, AD i Ouellette, BFF, red., Bioinformatyka: praktyczny przewodnik po analizie genów i białek , wydanie trzecie. Wiley, 2005. ISBN 0-471-47878-4

- Baxevanis, AD, Petsko, GA, Stein, LD i Stormo, GD, red., Current Protocols in Bioinformatics . Wiley, 2007. ISBN 0-471-25093-7

- Cristianini, N. i Hahn, M. Wprowadzenie do genomiki obliczeniowej , Cambridge University Press, 2006. ( ISBN 9780521671910 | ISBN 0-521-67191-4 )

- Durbin, R., S. Eddy, A. Krogh i G. Mitchison, Biologiczna analiza sekwencji . Cambridge University Press, 1998. ISBN 0-521-62971-3

- Gilbert D (wrzesień 2004). "Zasoby oprogramowania bioinformatycznego" . Odprawy w Bioinformatyce . 5 (3): 300-4. doi : 10.1093/bib/5.3.300 . PMID 15383216 .

- Keedwell, E., Inteligentna bioinformatyka: zastosowanie technik sztucznej inteligencji do problemów bioinformatycznych . Wiley, 2005. ISBN 0-470-02175-6

- Kohane i in. Mikromacierze dla genomiki integracyjnej. MIT Press, 2002. ISBN 0-262-11271-X

- Lund, O. i in. Bioinformatyka immunologiczna. Prasa MIT, 2005. ISBN 0-262-12280-4

- Pachter, Lior i Sturmfels, Bernd . „Statystyka algebraiczna dla biologii obliczeniowej” Cambridge University Press, 2005. ISBN 0-521-85700-7

- Pevzner, Pavel A. Computational Molecular Biology: podejście algorytmiczne The MIT Press, 2000. ISBN 0-262-16197-4

- Soinov, L. Bioinformatics and Pattern Recognition Come Together Journal of Pattern Recognition Research ( JPRR ), tom 1 (1) 2006 s. 37–41

- Stevens, Hallam, Life Out of Sequence: A Data-Driven History of Bioinformatics , Chicago: The University of Chicago Press, 2013, ISBN 9780226080208

- Tisdall, James. „Początek Perl dla Bioinformatyki” O'Reilly, 2001. ISBN 0-596-00080-4

- Catalizing Inquiry at the Interface of Computing and Biology (2005) raport CSTB

- Obliczanie tajemnic życia: wkład nauk matematycznych i obliczeń do biologii molekularnej (1995)

- Kurs MIT Podstawy Biologii Obliczeniowej i Systemowej

- Biologia obliczeniowa: genomy, sieci, ewolucja Bezpłatny kurs MIT

Zewnętrzne linki

|

Zasoby biblioteczne o Bioinformatyce |

-

Słownikowa definicja bioinformatyki w Wikisłowniku

Słownikowa definicja bioinformatyki w Wikisłowniku -

Materiały edukacyjne związane z bioinformatyką na Wikiversity

Materiały edukacyjne związane z bioinformatyką na Wikiversity -

Multimedia związane z bioinformatyką w Wikimedia Commons

Multimedia związane z bioinformatyką w Wikimedia Commons - Portal zasobów bioinformatycznych (SIB)